Профессиональная видеокарта Nvidia Quadro T400

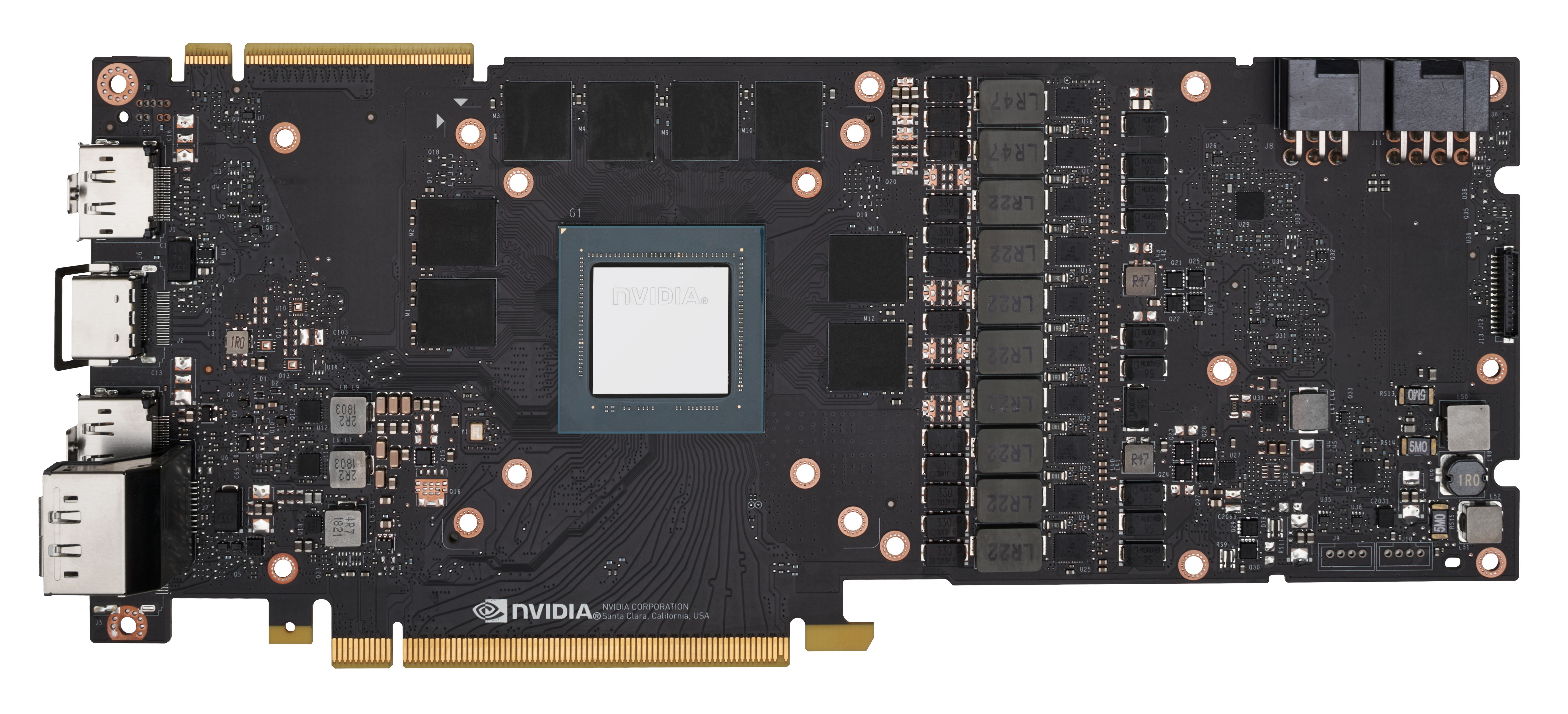

Новая профессиональная видеокарта NVIDIA Quadro T400 построенная на архитектуре Turing выполнена в однослотовом варианте и пришла на смену видеокарте NVIDIA Quadro P400.

NVIDIA Quadro T400 это невероятная производительность 3D приложений в компактном корпусе, 384 CUDA ядер, 2Гбайта графической памяти GDDR6 и низкопрофильный форм-фактор шириной в один слот для установки в системы с самыми ограниченными пространственными и энергоресурсами (SFF).

Архитектура NVIDIA Turing профессиональной видеокарты NVIDIA T400 значительно улучшила производительность по сравнению с предыдущим поколением P400, по сравнению с основными 3D-приложениями, до 60% повысив графическую производительность. Сверхбыстрая технология графической памяти GDDR6 предыдущего поколения обеспечивает в 2,5 раза большую пропускную способность памяти.

Теперь вы можете одновременно работать с трёмя дисплеями и получить полную поддержку стандарта нового поколения DisplayPort 1.

Программное обеспечение NVIDIA RTX Desktop Manager, интуитивно понятное управление окнами, несколькими рабочими столами и управление приложениями для обеспечения работы с одним большим дисплеем (8K 7680×4320 60Гц) или несколькими дисплеями.

Профессионалы доверяют им для обеспечения лучшего рабочего процесса в таких приложениях, как Adobe CC 2020, Avid Media Composer, Autodesk Inventor, Dassault Systemes CATIA и SolidWorks, Siemens NX, PTC Creo, и многие другие.

Профессионалы доверяют им для обеспечения лучшего рабочего процесса в таких приложениях, как Adobe CC 2020, Avid Media Composer, Autodesk Inventor, Dassault Systemes CATIA и SolidWorks, Siemens NX, PTC Creo, и многие другие.Все этапы профессионального рабочего процесса, от создания, редактирования и просмотра 2D- и 3D-моделей и видео до работы с несколькими приложениями на нескольких дисплеях, выигрывают от мощности, которую может обеспечить только дискретное решение GPU. Профессиональные графические процессоры начального уровня NVIDIA обеспечивают расширенные функции и производительность, значительно превосходящие возможности интегрированных графических решений (iGPU).

Специальный движок для кодирования NVENC для H.265 (HEVC) видео, независимый от 3D и вычислительного конвейера, обеспечивает более высокую производительность, чем в режиме реального времени, для транскодировки, редактирования видео и других приложений для кодирования.

Алгоритм сглаживания до 64x FSAA (128X со SLI) заметно снижает эффект зубчатости и неровность изображения, обеспечивая высокую реалистичность сцен.

Решения NVIDIA Quadro используют универсальные вычисления на GPU при помощи стандартных языков программирования, таких как C/C++ и Fortran, а также развивающихся API, таких как OpenCL и Direct Compute. Широкое применение возможностей CUDA позволяет ускорять такие техники, как трассировка лучей, обработка видео и изображений, а также вычисления в области динамики жидких тел.

Возможность работы с разрешением 16K x 16K при текстурировании и рендеринге для приложений, требующих самого высокого разрешения и качества визуализации изображений.

Поддержка включения движка Mercury Playback Engine GPU Acceleration (CUDA) в программе видеомонтажа Adobe Premiere Pro CC 2021.

Поддержка технологии аппаратного кодирования и декодирования в версии программы Adobe Premiere Pro CC 2021 (v15.0) и выше.

Графическая карта с поддержкой новейших версий OpenGL, DirectX, Vulkan и NVIDIA CUDA, гарантирующая совместимость с профессиональными приложениями.

Оцените высокую яркость и насыщенность цвета c коэффициентом контрастности 10 000:1 и возможностью подключения до трех дисплеев с разрешением 4K или одного дисплея 5K через разъем DisplayPort 1.4, а также удобную настройку с помощью NVIDIA nView. Создавайте и воспроизводите HDR-видео, используя кодеки H.264 и HEVC.

Видеокарта построена на 12нм FFN (FinFET NVIDIA) чипсете TU117-KA-A1. 4.7 миллиарда транзисторов. Площадь: 200 мм2.

384 CUDA процессоров, 16 текстурных блоков, 16 ROP.

Ядро и шейдерные блоки работают на частоте: 1070МГц и 1425МГц (Boost).

Производительность: 1,094 Тфлопс (одинарная точность). FP64: 1/32 FP32.

2ГБ GDDR6 памяти работают на частоте 10Gbps. 64-битная шина памяти. Полоса пропускания памяти: 80 Гб/с.

Интерфейс: PCI Express 3.0 x16.

Порты: 3х Mini DisplayPort 1.4a.

Максимальное разрешение DisplayPort 1.4a: 7680×4320@60Гц. Одновременная поддержка трёх мониторов с разрешением 4096×2160@60Hz и поддержкой HDR (SMPTE 2084/2086, BT.2020).

Поддержка технологии NVIDIA 3D Vision и DeepColor.

Поддержка: 64x anti-aliasing.

Поддержка: DirectX 12 Ultimate + Shader Model 5.1, DirectCompute 5.0, Vulkan 1.0. Оптимизация и поддержка OpenGL 4.6.

Нет поддержки NVIDIA SLI.

Поддержка API: CUDA C, CUDA C++, OpenCL, Java, Python, и Fortran.

Нет поддержки технологии NVIDIA GPUDirect for Video и VR Ready.

Поддержка HDCP 2.2.

Встроенный блок видеообработки NVIDIA NVENC 3.

0. 2x H.264 и HEVC кодера и 1x NVDEC Engine.

0. 2x H.264 и HEVC кодера и 1x NVDEC Engine.Поддержка операционных систем: Microsoft Windows 10, Red Hat Enterprise Linux 7.x, SUSE Linux Enterprise Desktop 15.x, OpenSuse 15, Fedora 31, Ubuntu 18.04, FreeBSD 11.x, Solaris 11.

Уровень TDP: 30 Вт.

Поддержка стандарта EnergyStar.

Требования к блоку питания: 300Вт. Без дополнительных силовых разъёмов питания PCIe.

Сертификационный стандарт: WHQL / ISO9241 / EU RoHS / JIG / REACH / HF / WEEE / RCM / BSMI / CE / FCC / ICES / KC / cUL, UL / VCCI.

Высота 156.0х68.9х18 мм, один слот. Вес: 129 грамм.

3 года гарантии.

Цена: $199.

Номер модели: ELSA EQT400-2GER, PNY VCNT400-PB.

» 13 советов по увеличению скорости рендера в After Effects

Рендеринг — это не самый приятный, но неизбежный этап процесса создания видеографики. Однако существует несколько простых шагов, следуя которым можно рендерить настолько быстро, насколько это возможно.

Однако существует несколько простых шагов, следуя которым можно рендерить настолько быстро, насколько это возможно.

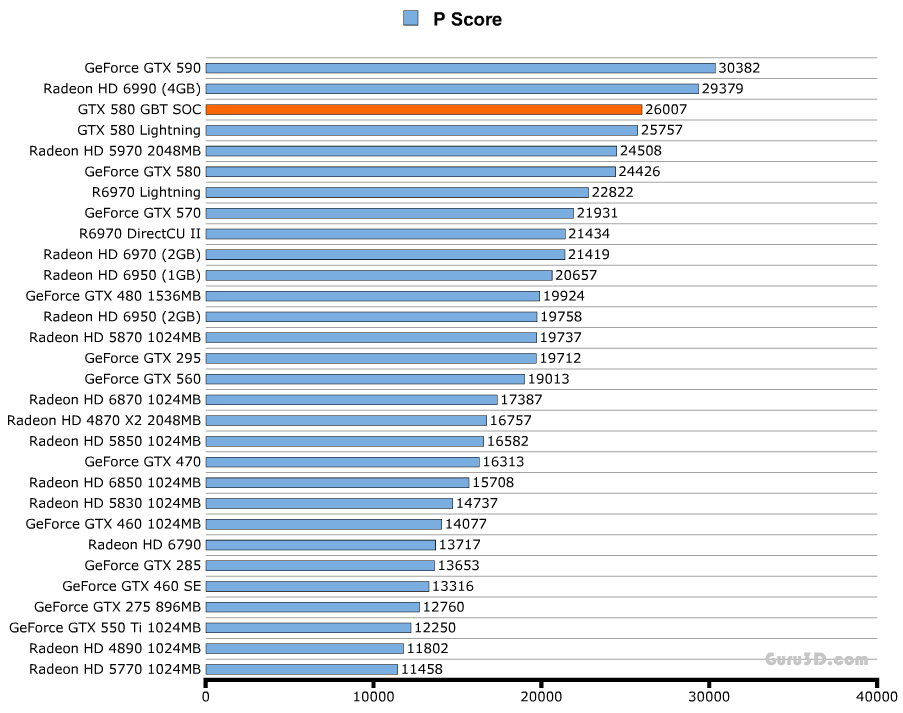

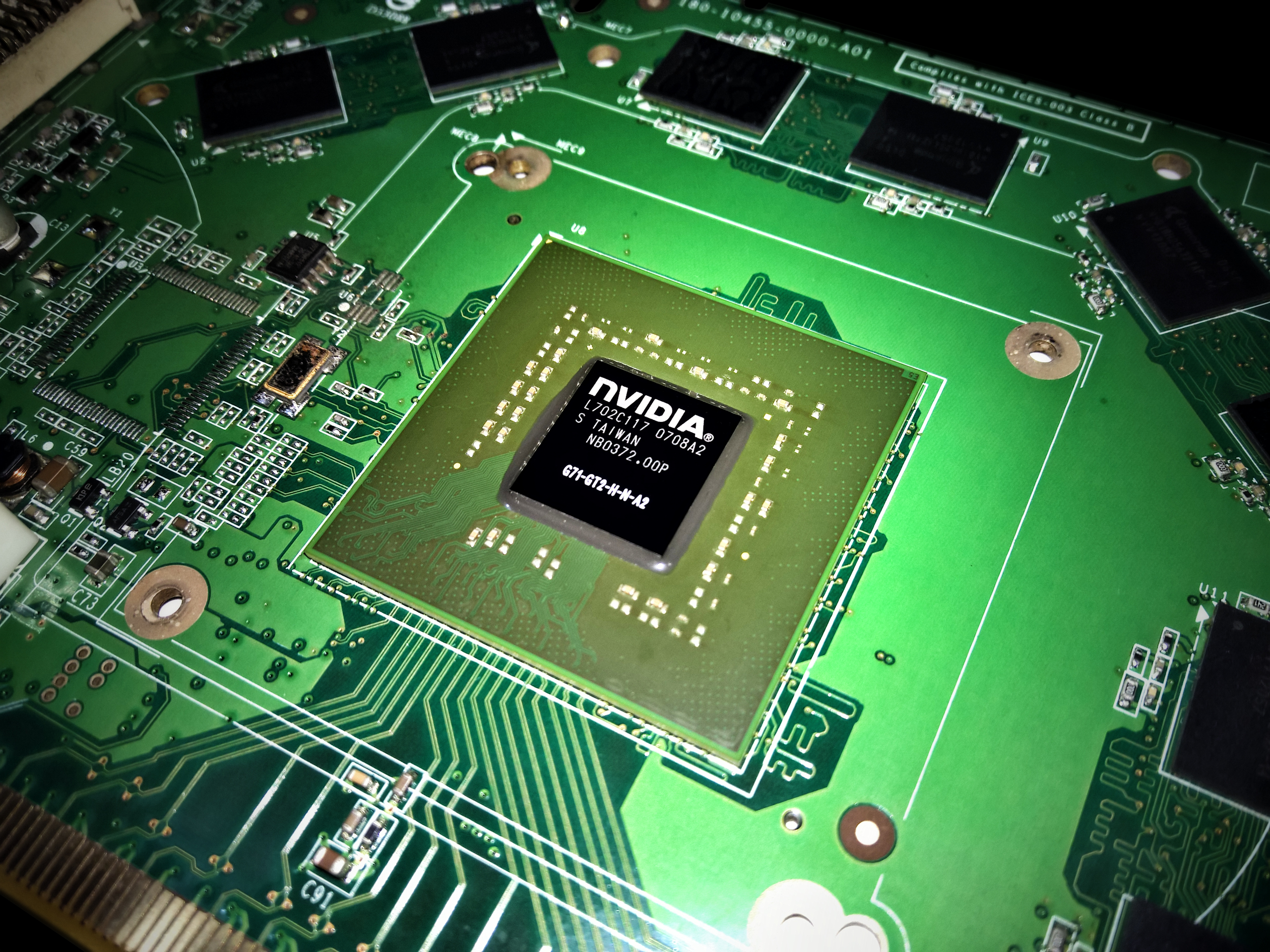

1. Подберите правильную видеокарту

After Effects — программа, которая сильно загружает видеокарту. Поэтому для наиболее эффективной работы с программой Adobe рекомендует следующие видеокарты. В частности, Adobe рекомендует пользоваться некоторыми картами от GeForce, Quadro и Tesla. Вы можете ознакомиться с полным списком наименований на сайте Adobe в разделе системные требования.

2. Обновите оперативную память

Adobe рекомендует использовать по крайней мере 4Гб оперативной памяти. Для профессионального использования пользователи AE отдают предпочтение памяти в 32Гб и более.

Использование такого вида диска не только позволит вам увеличить скорость рендера, но и повлияет на скорость работы компьютера в целом. Если вы приобрели внешний или внутренний жесткий диск по цене менее чем 100$ — пора его обновить. С монолитным жестким диском After Effects начнет быстрее загружать проекты, работать с оперативной памятью — что в совокупности ведет к снижению времени на рендер.

С монолитным жестким диском After Effects начнет быстрее загружать проекты, работать с оперативной памятью — что в совокупности ведет к снижению времени на рендер.

4. Используйте два жестких диска

Когда вы рендерите изображение на том же диске, где храните свой проект, диск вынужден выполнять одновременно две функции: считывать и записывать информацию. Поэтому рендер проходит в два раза дольше по времени. Вместо этого попробуйте сохранять проект и исходники на одном диске, а рендерить финальный вариант на другом.

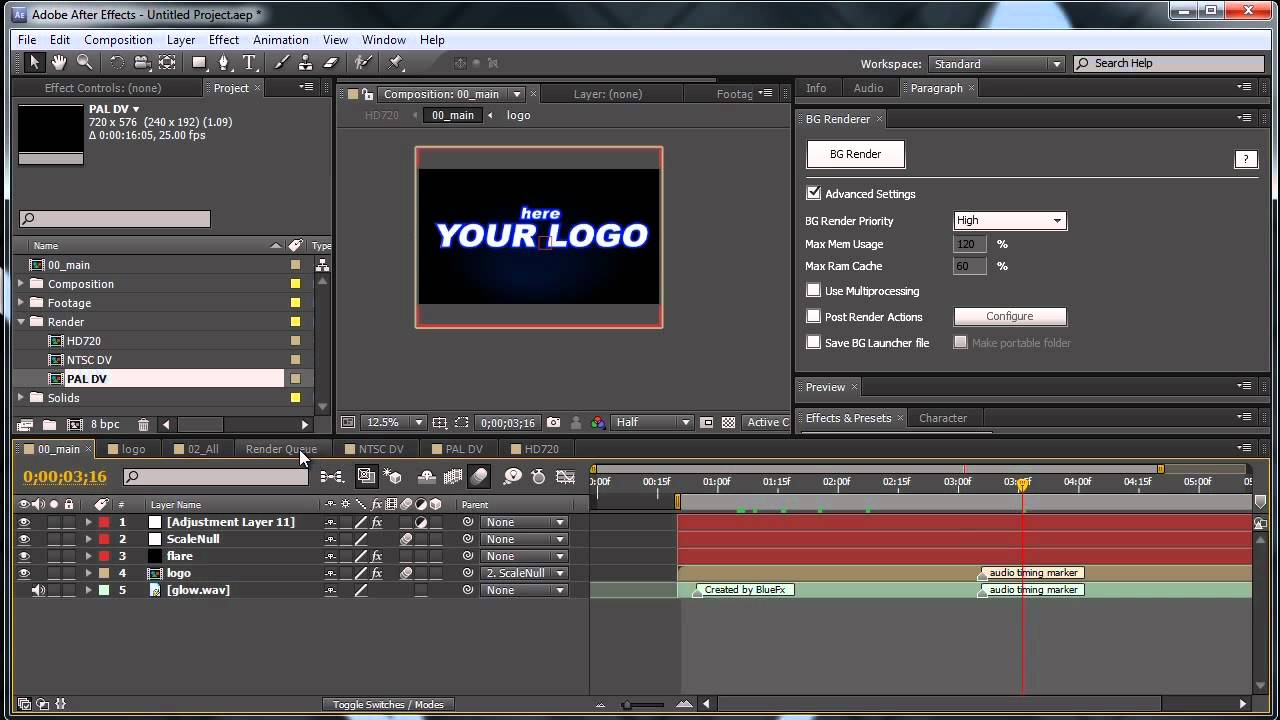

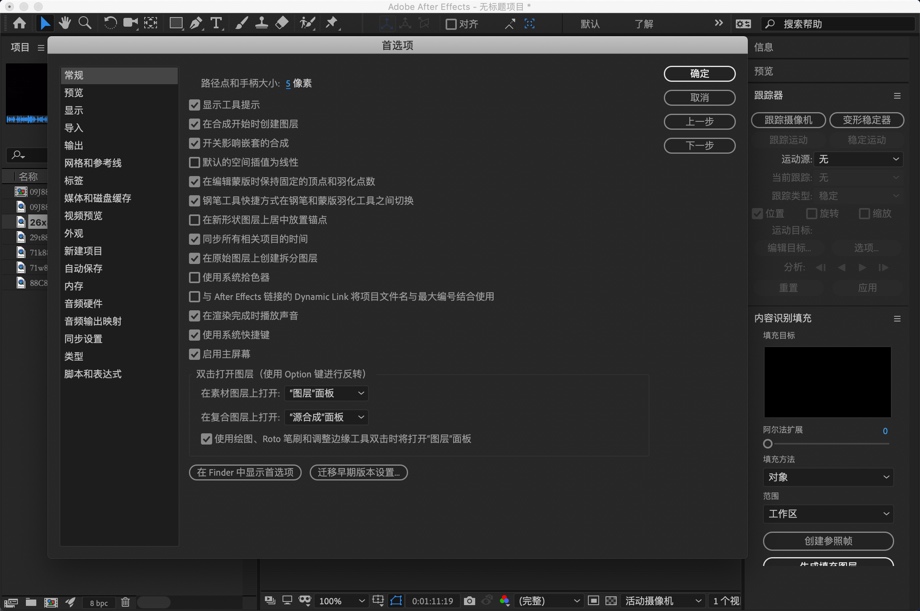

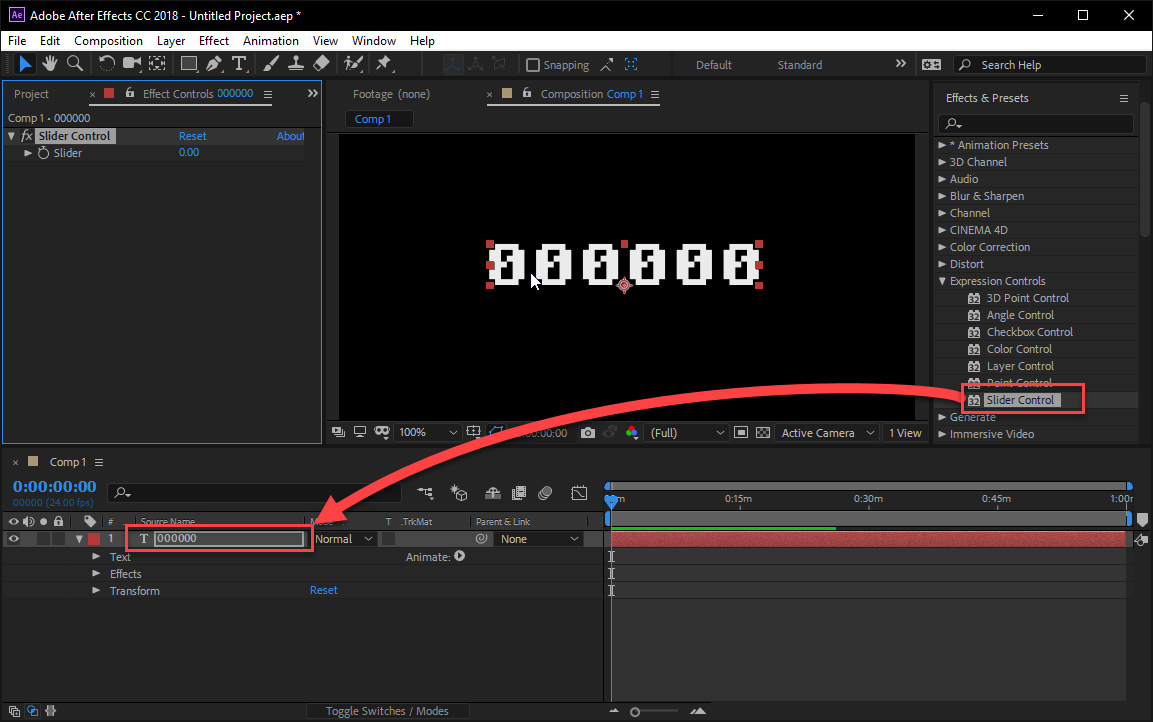

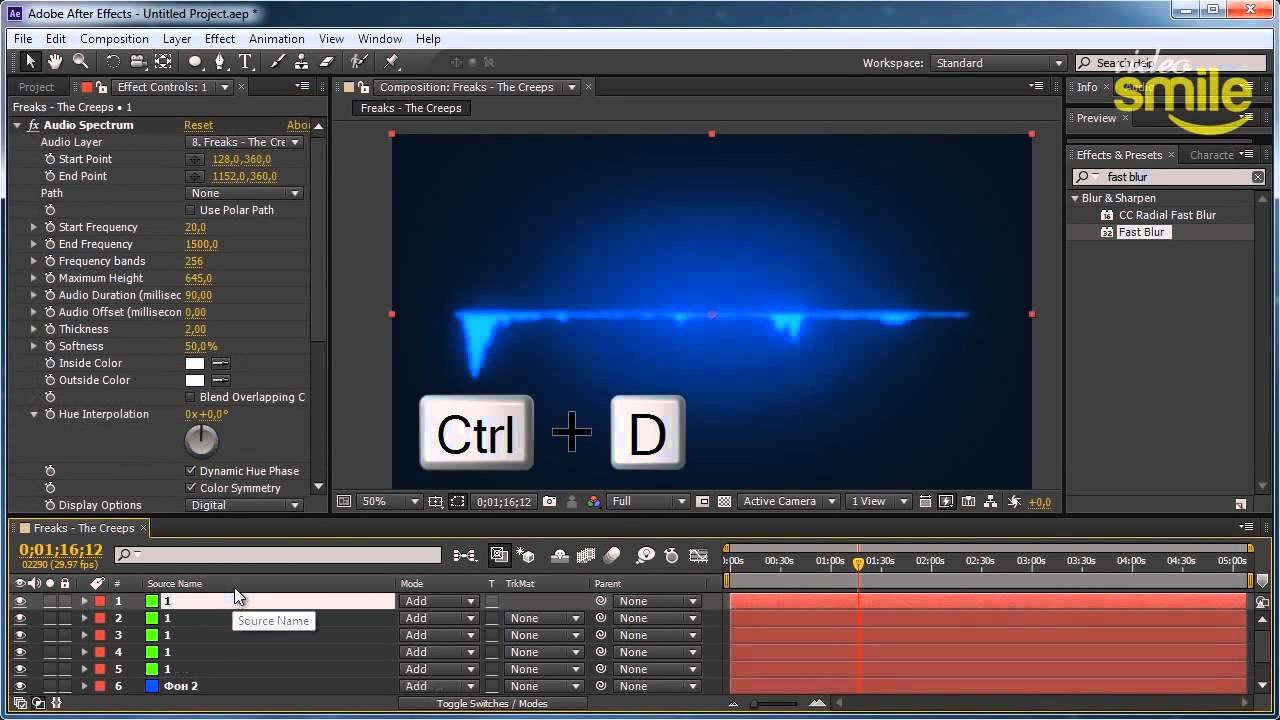

5. Задайте многопроцессорный режим

По умолчанию многопроцессорный режим не включен в AE — вы должны включить его вручную. Для этого следуйте схеме: After Effects>Preferences>Memory & Multiprocessing. На экране откроется меню:

Поставьте галочку напротив ‘Render Multiple Frames Simultaneously’ и далее задайте настройки по своему усмотрению.

6. Сократите использование прекомпозиции

Прекомпоз эффективен при создании удобного и систематизированного рабочего процесса в AE. Однако он может стать помехой при увеличении скорости рендера, поскольку использует пиксельную информацию всех слоев и помещает ее в композицию, перед тем как начать сам рендер.

Однако он может стать помехой при увеличении скорости рендера, поскольку использует пиксельную информацию всех слоев и помещает ее в композицию, перед тем как начать сам рендер.

7. Уберите все лишние элементы с композиции

Если вы не видите какие-то слои в своей композиции, это еще не значит, что они не будут рендериться. Поэтому перед тем, как отправить композицию на рендер, удостоверьтесь, что вырезаны все ненужные слои.

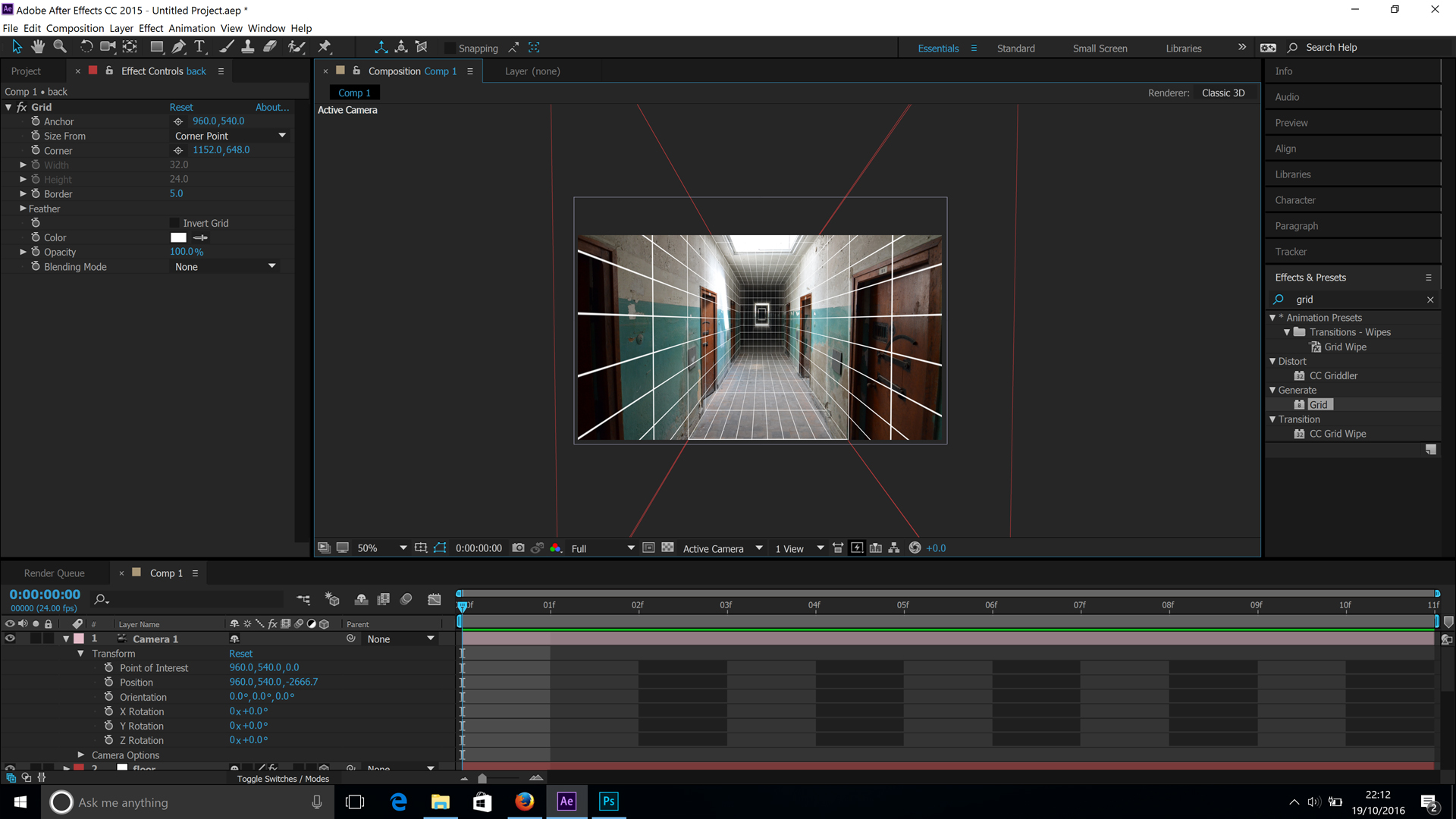

8. Отключите функцию Ray-Traced 3D

Слои Ray-Traced 3D стали одной из самых крутых функций в последней версии After Effects CS6 — наконец-то появился способ создания 3D-моделей прямо в AE. Однако эта новинка недолго вызывала восхищение пользователей, так как практическое применение данной функции требует высоких временных затрат. Поэтому удостоверьтесь, что композиция настроена на Classic 3D вместо Ray-Traced 3D, прежде чем начать рендер. Иначе вы станете свидетелем, того что процесс рендинга займет в два раза больше времени.

9. Закройте другие программы

Об этом можно легко забыть, но все-таки следует закрыть иные программы, запущенные на вашем компьютере. Это позволит освободить место на центральном процессоре.

10. Выбирайте правильные кодеки

Такие кодеки, как MOV, требуют больше времени на рендер, чем их более сжатые версии H.264 или ProRes. Главный вопрос — где вы планируете в дальнейшем использовать это видео, будет ли оно транслироваться на TV или на странице в интернете. Если оно предназначено для online-просмотра, то наверняка оно будет сжато при загрузке. Поэтому, может, даже не стоит пытаться экспортировать из программы высококачественное видео изначально?

11. Отключите функции Motion Blur, Depth of Field, и 3D, если вы их не используете

Время на рендер может тратиться меньше, если вы отключаете те функции, которые не используете в работе. Например, если вам не потребуется функция Motion Blur, отключите эту опцию. Если вы используете 3D-камеру, потребуется ли вам опция глубины изображения (depth of field) или будет достаточно 2D-изображения? Может быть, стоит симулировать 3D за счет уменьшения масштаба объектов и их переноса в 2D-пространство?

Если вы используете 3D-камеру, потребуется ли вам опция глубины изображения (depth of field) или будет достаточно 2D-изображения? Может быть, стоит симулировать 3D за счет уменьшения масштаба объектов и их переноса в 2D-пространство?

12. Будьте избирательны с эффектами

Не все эффекты одинаковы с технической точки зрения. Одни занимают больше времени на рендер, другие меньше. Поэтому тщательно выбирайте эффекты, с которыми будете работать. Большинство эффектов оптимизированы для рендера через множественные треды (потоки) на компьютерном процессоре, но есть и такие, которые проходят только через один тред — они и являются самыми время затратными.

Список таких эффектов:

• Auto Color

• Auto Contrast

• Auto Levels

• Cartoon

• Lens Blur

• Particle Playground

• Shadow/Highlight

13. Adobe каждый раз пытается выпустить более быструю и оптимальную версию программы AE

Старайтесь изначально устанавливать самую последнюю версию. Если раньше приобретение каждого Creative Suite требовало значительных финансовых затрат, то сейчас Creative Cloud находится в общем доступе, куда выкладываются все последние обновления.

Если раньше приобретение каждого Creative Suite требовало значительных финансовых затрат, то сейчас Creative Cloud находится в общем доступе, куда выкладываются все последние обновления.

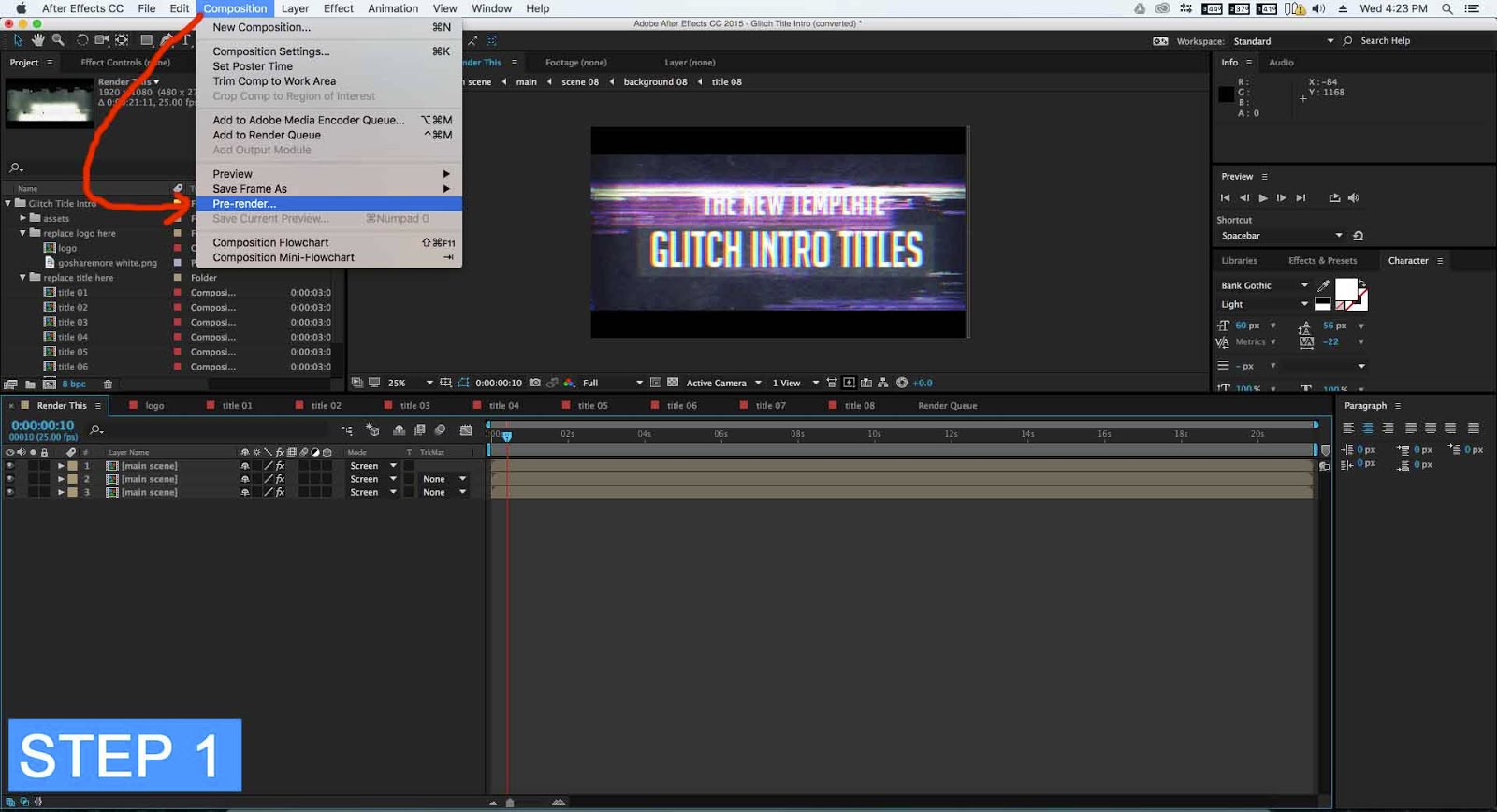

Бонус: используйте Media Encoder для экспортирования композиций

Самая большая проблема в процессе рендеринга — невозможность в это же время работать в программе. Но и эта проблема была решена, благодаря Adobe Media Encoder, который позволяет работать над другими проектами, в то время как идет рендер.

Источник: cinemotionlab.com

Графические решения NVIDIA QUADRO

Графические процессоры NVIDIA Quadro спроектированы для профессиональных рабочих станций и обеспечивают высокой производительностью более 200 профессиональных приложений в широком спектре отраслей, включая производство, проектирование и конструирование, масс-медиа и развлечения, науку и энергетику. Профессионалы доверяют решениям Quadro рабочие процессы в таких распространенных приложениях, как Adobe Creative Cloud, Avid Media Composer, Autodesk Inventor, Dassault Systemes CATIA и SolidWorks, Siemens NX, PTC Creo и многих других. Подробнее о профессиональных приложениях, для которых решения QUADRO сертифицированы и рекомендованы можно узнать на сайте

NVIDIA или на сайте PNY, производителя видеокарт с процессором NVIDIA QUADRO, используемых в рабочих станциях Team Workstation.

Подробнее о профессиональных приложениях, для которых решения QUADRO сертифицированы и рекомендованы можно узнать на сайте

NVIDIA или на сайте PNY, производителя видеокарт с процессором NVIDIA QUADRO, используемых в рабочих станциях Team Workstation.

Аппаратная совместимость и стабильность работы обеспечена поддержкой последних стандартов OpenGL, DirectX, OpenCL , NVIDIA CUDA и взаимодействием на их основе с разработчиками программного обеспечения.

Широкие возможности и качество работы графических рабочих станций обеспечиваются рядом технологий NVIDIA, как то, NVIDIa 3D Vision, G-Sync, NVLINK, PHYSX многих других. В частности, технология NVIDIA мульти-GPU позволяет успешно масштабировать производительность за счет использования в одной системе комбинации из нескольких графических карт NVIDIA QUADRO или NVIDIA TESLA.

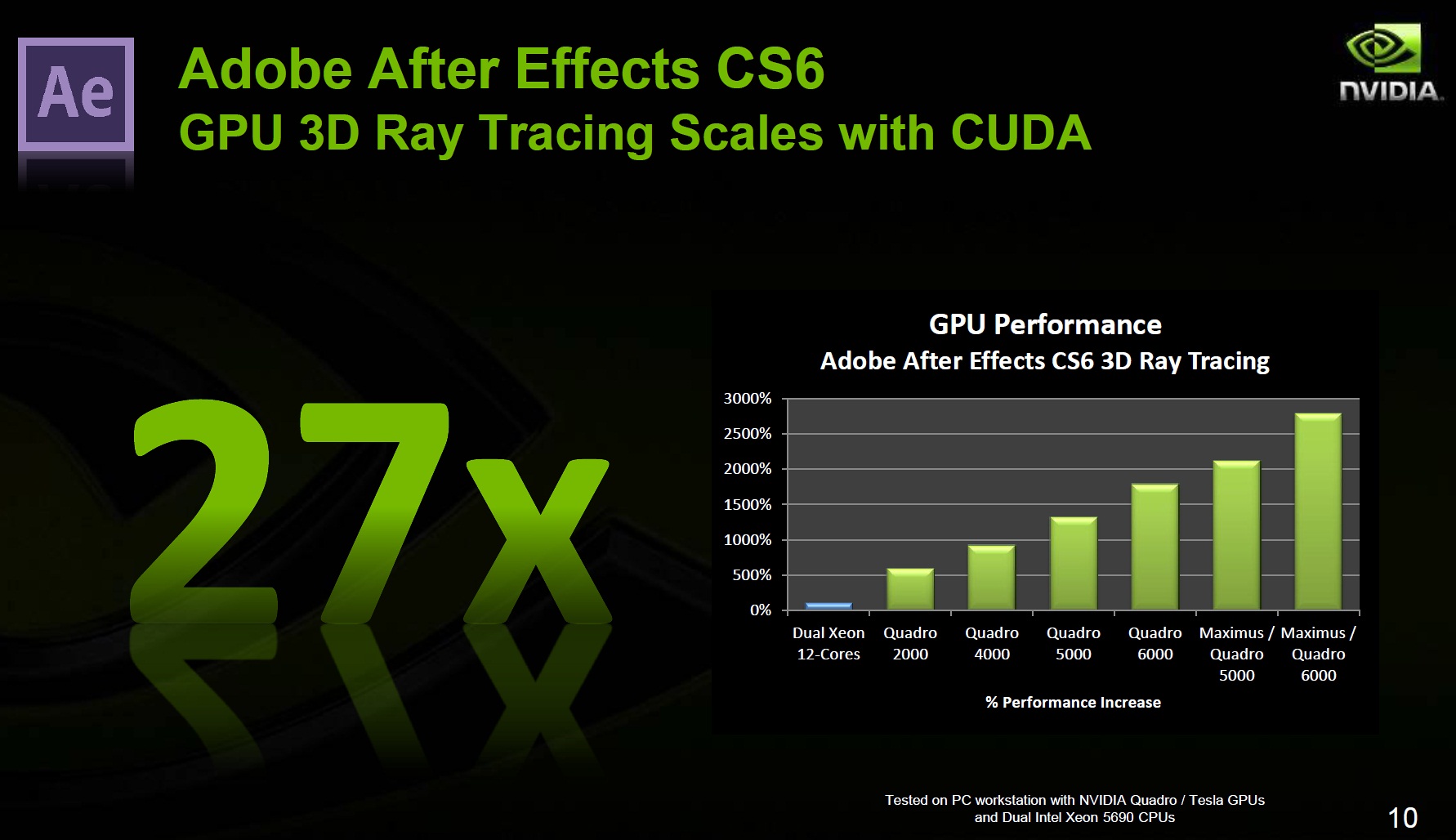

Повышение производительности приложений можно проиллюстрировать на примере популярных программ:

Adobe Premiere Pro CC

Мощный движок Adobe Mercury Playback Engine, разработанный совместно компаниями Adobe и NVIDIA ускоряет финальный рендеринг в 18 раз.

Adobe After Effects CC

Метод трассировки лучей ускоряет создание реалистичных 3D фигур до 23 раз по сравнению с CPU.

Autodesk 3ds Max

Фотореализм в 3ds Max повышается благодаря NVIDIA IRAY для интерактивного рендеринга. Материалы и свет взаимодействуют, как в реальном физическом мире. Ускорение рендеринга продемонстрировано в следующей таблице.

Современный модельный ряд графических решений NVIDIA QUADRO построен на архитектуре Kepler и включает перечень карт для различного бюджета, производительности и набора интерфейсов.

NVIDIA QUADRO K420

Однослотовая низкопрофильная карта с 1 Гб оперативной памяти DDR3 с поддержкой до четырех дисплеев с DisplayPort 1.2 с ультра-высокими разрешениями 3840×2160 @ 60 Гц при 30-битном цвете.

NVIDIA QUADRO K620

Однослотовая низкопрофильная карта с 2 Гб оперативной памяти DDR3 с поддержкой до четырех дисплеев с DisplayPort 1.2 с ультра-высокими разрешениями 3840×2160 @ 60 Гц при 30-битном цвете.

NVIDIA QUADRO K2200

Однослотовая полнопрофильная карта с 4 Гб оперативной памяти GDDR5 с поддержкой до четырех дисплеев с DisplayPort 1.2 с ультра-высокими разрешениями 3840×2160 @ 60 Гц при 30-битном цвете.

NVIDIA QUADRO K4200

Однослотовая полнопрофильная карта с 4 Гб оперативной памяти GDDR5 с поддержкой до четырех дисплеев с DisplayPort 1.2 с ультра-высокими разрешениями 3840×2160 @ 60 Гц при 30-битном цвете. Возможна синхронизация нескольких дисплеев в системах с платой Quadro Sync и ускорение передачи данных с помощью GPUDirect ™.

NVIDIA QUADRO K5200

Двухслотовая полнопрофильная карта на GPU с 2304 ядрами и 8 Гб оперативной памяти GDDR5. Поддерживает до четырех дисплеев с DisplayPort 1.2 с ультра-высокими разрешениями 4096 х 2160 @ 60 Гц при 30-битном цвете. Возможна синхронизация нескольких дисплеев в системах с платой Quadro Sync и ускорение передачи данных с помощью GPUDirect ™.

NVIDIA QUADRO K6000

Двухслотовая полнопрофильная карта на GPU с 2880 ядрами и 12 Гб оперативной памяти GDDR5. Поддерживает до четырех дисплеев с DisplayPort 1.2 с ультра-высокими разрешениями 4096 х 2160 @ 60 Гц при 30-битном цвете. Возможна синхронизация нескольких дисплеев в системах с платой Quadro Sync и ускорение передачи данных с помощью GPUDirect ™.

Поддерживает до четырех дисплеев с DisplayPort 1.2 с ультра-высокими разрешениями 4096 х 2160 @ 60 Гц при 30-битном цвете. Возможна синхронизация нескольких дисплеев в системах с платой Quadro Sync и ускорение передачи данных с помощью GPUDirect ™.

NVIDIA QUADRO M6000

Новинка на архитектуре Maxwell. Двухслотовая полнопрофильная карта на GPU с 3072 ядрами и 12 Гб оперативной памяти GDDR5. Поддерживает до четырех дисплеев с DisplayPort 1.2 с ультра-высокими разрешениями 4096 х 2160 @ 60 Гц при 30-битном цвете. Возможна синхронизация нескольких дисплеев в системах с платой Quadro Sync и ускорение передачи данных с помощью GPUDirect ™.

Prestige P100 и PS341WUК: компьютерная система, как творческая студия

В этой статье я расскажу, как я работаю, и как выбрать правильную компьютерную систему для использования в качестве креативной студии.

Мои друзья часто спрашивают, не геймер ли я. Дело в том, что мои работы – нечто, что они могут увидеть лишь в каком-то загадочном виртуальном мире. На самом деле, я никогда не был серьезным геймером. Обычно я играю лишь в какие-то стратегии или спортивные симуляторы, а не в популярные многопользовательские «ролевки» или AAA-проекты. Впрочем, лет 10 назад я осознал, что мультимедийный контент будет привлекать всеобщее внимание, когда покупал через интернет какие-то дополнения или игрушечные фигурки, посвященные таким играм. Социальные сети на тот момент были не особо удобными и не такими многофункциональными, как нынешние Instagram, Twitter и Facebook, что не помешало мне проводить необходимый анализ перед покупкой. И да, креативный контент виделся чрезвычайно важным для меня. Именно так я погрузился в загадочный мир, который стал моей профессией.

На самом деле, я никогда не был серьезным геймером. Обычно я играю лишь в какие-то стратегии или спортивные симуляторы, а не в популярные многопользовательские «ролевки» или AAA-проекты. Впрочем, лет 10 назад я осознал, что мультимедийный контент будет привлекать всеобщее внимание, когда покупал через интернет какие-то дополнения или игрушечные фигурки, посвященные таким играм. Социальные сети на тот момент были не особо удобными и не такими многофункциональными, как нынешние Instagram, Twitter и Facebook, что не помешало мне проводить необходимый анализ перед покупкой. И да, креативный контент виделся чрезвычайно важным для меня. Именно так я погрузился в загадочный мир, который стал моей профессией.

Эти беспорядочные бумажки вызывают улыбку, но они – часть рабочего процесса.

Эти беспорядочные бумажки вызывают улыбку, но они – часть рабочего процесса.В целом, мой творческий процесс выглядит следующим образом. Мне приходит в голову какая-то мысль или фантазия, затем я выражаю ее в виде рисунка, обрабатываю получившееся изображение, делаю на его основе анимационный ролик и получаю финальный результат в виде видеофайла или публикации на веб-сайте. Разумеется, хуже всего, когда воспроизведение видео идет с задержками, когда элементы на экране не двигаются плавно, особенно если приходится работать в условиях ограниченного времени. Поэтому в данной статье я расскажу вам, как выбрать правильное компьютерное оборудование, чтобы работать над своими творческими проектами более продуктивно.

Базовые приложения для творчества: Photoshop и Illustrator

Рисование или ретуширование изображений – основа всей работы. Ничего не может быть хуже, чем «рваное» перемещение элементов или слоев в приложении Photoshop или Illustrator (при этом изображение из сотен элементов еще считается довольно простым). Графическая работа похожа на паззл. Например, постер размером 420 х 594 мм и разрешением 300 точек на дюйм будет содержать 10 слоев (или 10 групп), включая освещение, перспективу, тени и даже эффекты кистей. Все это – необходимый минимум для профессионала. И для обработки всего этого в Illustrator или Photoshop требуется подходящий процессор, дополненный необходимым объемом оперативной памяти.

Графическая работа похожа на паззл. Например, постер размером 420 х 594 мм и разрешением 300 точек на дюйм будет содержать 10 слоев (или 10 групп), включая освещение, перспективу, тени и даже эффекты кистей. Все это – необходимый минимум для профессионала. И для обработки всего этого в Illustrator или Photoshop требуется подходящий процессор, дополненный необходимым объемом оперативной памяти.На данный момент Photoshop и Illustrator не особо эффективно используют процессоры с большим числом ядер. Иными словами, они ориентированы на однопоточность и лишь для некоторых операций задействуют сразу несколько ядер (не более восьми). В результате, некоторые процессоры X-серии оказываются в этих приложениях даже немного медленнее, чем Core i9-9900K, установленный в компьютере MSI Prestige P100. Для большинства сценариев использования Photoshop и Illustrator подойдет i9-9900K или даже i7-9700. Помимо процессора, для их быстрой работы нужен большой объем памяти. Я рекомендую 16 гигабайт для файлов размером около 500 МБ и 32 ГБ для файлов менее 1 ГБ. Размер файла указывается в нижнем левом углу окна приложения, когда тот открыт. Вы увидите там два числа, например «17.6M/497.1M». Правое (большее) число включает в себя все слои, поэтому именно оно наиболее точно указывает, сколько оперативной памяти следует установить в компьютер для комфортной работы с данным файлом.

Помимо процессора, для их быстрой работы нужен большой объем памяти. Я рекомендую 16 гигабайт для файлов размером около 500 МБ и 32 ГБ для файлов менее 1 ГБ. Размер файла указывается в нижнем левом углу окна приложения, когда тот открыт. Вы увидите там два числа, например «17.6M/497.1M». Правое (большее) число включает в себя все слои, поэтому именно оно наиболее точно указывает, сколько оперативной памяти следует установить в компьютер для комфортной работы с данным файлом.

Впрочем, поскольку Photoshop и Illustrator не предъявляют особо высоких требований к графическому процессору, я рекомендую вложиться больше в центральный процессор и оперативную память, а также не забыть о твердотельном накопителе (M.2, PCIe). Только тогда компьютер будет оптимален для продуктивной работы.

Впрочем, поскольку Photoshop и Illustrator не предъявляют особо высоких требований к графическому процессору, я рекомендую вложиться больше в центральный процессор и оперативную память, а также не забыть о твердотельном накопителе (M.2, PCIe). Только тогда компьютер будет оптимален для продуктивной работы.

Изображение оживает – в After Effects

Плавное воспроизведение в After Effects зависит от объема доступной памяти, особенно когда мы создали множество элементов в других программах, например рисунки в Illustrator, и пришло время задать начальные и конечные точки с помощью ключевых кадров. Кроме того, качество воспроизведения зависит от длины, разрешения и сложности проекта. Аниматор создает «скелет» модели и оживляет ее, перемещая отдельные части, однако «рваное» воспроизведение может испортить весь эффект. Для такой работы не обязательно иметь хорошие навыки рисования, потому что можно пробовать снова и снова, и возвращаться назад, если результат не нравится. И именно поэтому плавное воспроизведение очень важно для аниматора, будь то двухмерная или трехмерная анимация.

При наличии большого объема памяти в ней может храниться больше кадров для предварительного просмотра (и, соответственно, меньше кадров нужно будет отрисовывать заново). Для не особо сложных проектов я рекомендую не менее 32 ГБ памяти, но 64 ГБ будет еще лучше, потому что для создания слоев в After Effects мы обычно применяем другие приложения. Никто не хочет увидеть сообщение «Недостаточно памяти», особенно после часа работы. Лет 5-6 назад приложение After Effects с большой эффективностью использовало многоядерные процессоры, однако сейчас вместо множества ядер лучше иметь процессор с высокой частотой. Исключение – рендерер Cinema 4D, который будет работать быстрее на многоядерном процессоре. В целом, для большинства сценариев работы в After Effects отличным выбором будет Core i9-9900K или даже i7-9700K.

Далее, очень важно иметь хорошую видеокарту с достаточным объемом видеопамяти, не менее 4 гигабайт. Поскольку в компьютере MSI Prestige P100 имеется как минимум 6 ГБ видеопамяти, он работает в After Effects очень быстро, обгоняя многих конкурентов. Последняя версия After Effects позволяет использовать движок рендеринга Mercury, поддерживающий аппаратное ускорение с помощью графического процессора, для визуальных эффектов сторонних разработчиков, поэтому я рекомендую активировать параметр «Mercury GPU Acceleration (CUDA)», который находится в разделе «Video Rendering and Effects» настроек проекта в After Effects. Это сократит время рендеринга, а воспроизведение вашего ролика будет более плавным.

Поскольку в компьютере MSI Prestige P100 имеется как минимум 6 ГБ видеопамяти, он работает в After Effects очень быстро, обгоняя многих конкурентов. Последняя версия After Effects позволяет использовать движок рендеринга Mercury, поддерживающий аппаратное ускорение с помощью графического процессора, для визуальных эффектов сторонних разработчиков, поэтому я рекомендую активировать параметр «Mercury GPU Acceleration (CUDA)», который находится в разделе «Video Rendering and Effects» настроек проекта в After Effects. Это сократит время рендеринга, а воспроизведение вашего ролика будет более плавным.

Нелинейный видеомонтаж: для профессиональных режиссеров и любителей

В своей работе я обычно использую кодек H.264 AVC (также называемый MPEG-4), который является промышленным стандартом для записи, сжатия и распространения цифрового видеоконтента. Также иногда я импортирую и экспортирую материалы в формате H. 265 HEVC, который сжимает данные более эффективно, что означает уменьшенный размер файла, а значит и меньшие требования к пропускной способности канала при его онлайн-трансляции.

265 HEVC, который сжимает данные более эффективно, что означает уменьшенный размер файла, а значит и меньшие требования к пропускной способности канала при его онлайн-трансляции.

Неважно, используете ли вы Premiere Pro, Vegas Pro или Power Director, все они поддерживают аппаратное ускорение для кодирования в форматах H.264 и H.265 (HEVC) посредством технологии Intel Quick Sync. Это позволяет быстрее преобразовывать видеоматериалы в нужный вид, и поэтому процессоры i9-9900(K) и i7-9700(K) будут отличным выбором для данных приложений.

Разумеется, видеокарта еще более высокого класса с еще большим объемом видеопамяти, например RTX 2080 Ti с 11 гигабайтами, будет идеальной, если ваш рабочий процесс подразумевает использование нескольких приложений, скорость которых зависит от видеокарты, примером чего является приложение DaVinci Resolve.

Разумеется, видеокарта еще более высокого класса с еще большим объемом видеопамяти, например RTX 2080 Ti с 11 гигабайтами, будет идеальной, если ваш рабочий процесс подразумевает использование нескольких приложений, скорость которых зависит от видеокарты, примером чего является приложение DaVinci Resolve.

Редактирование и публикация контента через смартфон

Я часто читаю и публикую интересный контент в соцсетях Instagram и Facebook, когда еду в автобусе или метро. Порой я просто снимаю на видео свои ботинки во время прогулки, немного обрабатываю цвет в панели Lumetri и подписываю парой слов – и все это на смартфоне. Поэтому позвольте представить вам удобный инструмент – Premier Rush. Для его использования не нужно быть экспертом или иметь кинематографического качества материал. Premiere Rush предлагает функции приложений Premiere Pro и After Effects, а также доступ к коллекции ресурсов Adobe Stock, что позволяет мне легко и быстро редактировать свои работы. Я даже могу настраивать музыку и звуковые эффекты с помощью функции автоматической регулировки громкости. Все редактирование осуществляется на одном устройстве, будь то смартфон или компьютер, а публикация в интернете выполняется напрямую. Приложение Rush доступно в базовой версии бесплатно, но я пользуюсь версией Rush Single App, которая дополнена облачным хранилищем на 100 ГБ и возможностью неограниченного экспорта работ. Кстати, сейчас идет специальная акция «Get Rush, Get Unleashed», так что может самое время попробовать Rush?

Все редактирование осуществляется на одном устройстве, будь то смартфон или компьютер, а публикация в интернете выполняется напрямую. Приложение Rush доступно в базовой версии бесплатно, но я пользуюсь версией Rush Single App, которая дополнена облачным хранилищем на 100 ГБ и возможностью неограниченного экспорта работ. Кстати, сейчас идет специальная акция «Get Rush, Get Unleashed», так что может самое время попробовать Rush?

Важен ли монитор? Разумеется!

Хотя контент можно редактировать и на смартфоне, хороший дисплей с широким соотношением сторон 21:9 может серьезно повлиять на то, как вы работаете или играете в игры на своем компьютере. Раньше я использовал пару 24-дюймовых IPS-дисплеев, и это помогало повысить продуктивность. Чем больше экранного пространства, тем лучше, однако не все так просто. Учитывая расстояние между монитором и глазами, самым комфортным размером экрана является 34”, причем разрешение должно быть не меньше, чем WQHD. В таком случае я могу заменить пару 24-дюймовых моделей одним монитором и сэкономить место на рабочем столе.

В таком случае я могу заменить пару 24-дюймовых моделей одним монитором и сэкономить место на рабочем столе.

Когда я работаю с видео, у меня всегда очень длинная «шкала времени» с бессчетным числом ключевых кадров. Очень важно, чтобы я мог легко и точно перемещать эти кадры или слои, будь то для видеоматериала или изображения из Photoshop или Illustrator. Монитор MSI Prestige PS341WU обладает разрешением 5120 х 2160 пикселей (WUHD), поэтому я могу видеть и воспроизводить полную шкалу времени со всеми ключевыми кадрами. Речь идет не только о размере экрана, но и о разрешении: оно позволяет мне работать в окне формата 4K и параллельно просматривать контент в другом окне. Это настолько удобно, что я уже не смогу вернуться к своему обычному монитору.

Для моей работы также критически важен цвет, и я обычно пользовался аппаратным калибратором для настройки цветопередачи, особенно когда применял цветовые фильтры для сложных изображений, чтобы подчеркнуть оттенки цвета, освещение, перспективу, тени или даже эффекты кистей. Все это проявляется на мониторе, способном обеспечить нужную точность цветопередачи и широкий цветовой охват. Цветовой охват модели PS341WU составляет 100% sRGB и 98% Display P3, поэтому весь мой видеоматериал воспроизводится во всей красе. Этот монитор выводит цвета такими же, какими я их вижу на своей камере. Точность зеленых и красных оттенков, детализация теней, насыщенность и яркость – все это помогает мне при редактировании материала во время постобработки.

Все это проявляется на мониторе, способном обеспечить нужную точность цветопередачи и широкий цветовой охват. Цветовой охват модели PS341WU составляет 100% sRGB и 98% Display P3, поэтому весь мой видеоматериал воспроизводится во всей красе. Этот монитор выводит цвета такими же, какими я их вижу на своей камере. Точность зеленых и красных оттенков, детализация теней, насыщенность и яркость – все это помогает мне при редактировании материала во время постобработки.

Компьютер для монтажа 4K видео. Монтаж в разрешении 4К.

Этот компьютер прослужил мне 2,5 года. На чем я монтирую и на что снимаю сейчас.

Выбор комплектующих и сборка.

Итоговая конфигурация.

Тестирование производительности в Adobe Premiere Pro.

Многопоточное воспроизведение 4K видео.

Работа с эффектами в реальном времени.

Узкие места.

Заключение.

Предисловие

4K видео уже даже не на пороге, а зашло в дом. В большинстве случаев только к тем, кто вообще понимает, что значат эти 2 символа. Энтузиасты покупали Gh5, стоят в очереди за Sony A7s II, летают на DJI Phantom 3 и Inspire, а потом тратят десятки часов, чтобы выгрузить на YouTube ролик с разрешением 3840×2160. И мне тоже приходится это делать. И хочется делать это быстро, насколько это возможно и насколько позволяет мой кошелек.

Сам по себе монтаж видео в разрешении 4K возможен на любом i7 последних 3 лет, основную нагрузку берет на себя видеокарта. Но что делать, если вам нужно использовать фильтры или плагины, которые не всегда рендерятся силами GPU? Правильно — собирать новую систему, желательно самое мощное, что есть на рынке. 4K видео с наложенными Warp Stabilizer, Magic Bullet Looks или Film Convert, а уж тем-более старина Noise Reduction от Neat Video поставит на колени любой компьютер. Но мы будем сопротивляться и соберем мощный системник для монтажа 4K видео образца конца 2015 года. Цены я тут писать не буду, если захотите — посмотрите сами.

4K видео с наложенными Warp Stabilizer, Magic Bullet Looks или Film Convert, а уж тем-более старина Noise Reduction от Neat Video поставит на колени любой компьютер. Но мы будем сопротивляться и соберем мощный системник для монтажа 4K видео образца конца 2015 года. Цены я тут писать не буду, если захотите — посмотрите сами.

Выбор комплектующих и сборка

В общем, я решил не мелочиться, а сразу собрать хорошую систему, на которой я планирую работать ближайшие 3-4 года. На текущий момент самой перспективной производительной платформой Intel является 2011-3. Под нее на текущий момент существуют всего 3 десктопных процессора Haswell-E (серверные Xeon не рассматриваем). Это парочка шестиядерных Intel Core i7-5820K и 5930K, а также 8-ядерный Intel Core i7-5960X. Разница между 5820K и 5930K в 200 МГц тактовой частоты и в дополнительных 12 линиях PCI-E. Учитывая разницу между ними в 250$, данный бонус выглядит весьма сомнительно. Тем более, если учесть, что разницы между парой видеокарт, работающий в режиме 16+16 и 16+8 нет никакой. Я же вообще не планирую устанавливать несколько видеокарт в одну систему.

Я же вообще не планирую устанавливать несколько видеокарт в одну систему.

Что касается 8-ядерного монстра Core i7-5960X, то стоит он в 3 раза дороже, чем i7-5820K, при этом в Abobe Premiere и After Effects СС 2015 демонстрирует прирост производительности на уровне 7-10%. На всей текущей линейке Haswell-E разблокирован множитель, так что данный прирост можно достичь небольшим разгоном шестиядерных моделей.

В общем, я пришел к выводу, что оптимальным высокопроизводительным процессором на текущий момент является 6-ядерный Intel Core i7-5820K. Такого же мнения придерживаются большинство специализированных сайтов типа THG и Overclockers. Кстати, недавно анонсированная линейка процессоров Broadwell-E, которая предположительно будет включать и 10-ядерный Core i7-6950X также будет основана на сокете 2011-3, так что с апгрейдом в ближайшие 3-4 года проблем не возникнет.

Материнских плат под сокет 2011-3 достаточно много, в основном благодаря Asus. Все они максимально хорошо оснащены и обладают одинаковым базовым функционалом, т.к. построены на системной логике Intel X-99. Я остановился на новой MSI X99A SLI PLUS. Она одна из немногих имеет на борту два свежих USB 3.1, при этом в ней убраны некоторые «бонусы» из-за которых некоторые модели обходятся дороже .

Все они максимально хорошо оснащены и обладают одинаковым базовым функционалом, т.к. построены на системной логике Intel X-99. Я остановился на новой MSI X99A SLI PLUS. Она одна из немногих имеет на борту два свежих USB 3.1, при этом в ней убраны некоторые «бонусы» из-за которых некоторые модели обходятся дороже .

Материнки от Gigabyte на ранних этапах (и не только) имели много проблем с BIOS, поэтому их лучше вообще проигнорировать. В линейке ASUS очень много моделей, более дорогие версии имеют по 2 Lan, встроенный Wi-Fi модуль, наличие сразу нескольких разъемов M2 и экранирование звукового тракта (что для меня бесполезно, т.к. я использую Creative X-Fi) но принципиально в плане качества элементной базы и быстродействия — все эти материнские платы на одинаковом уровне.

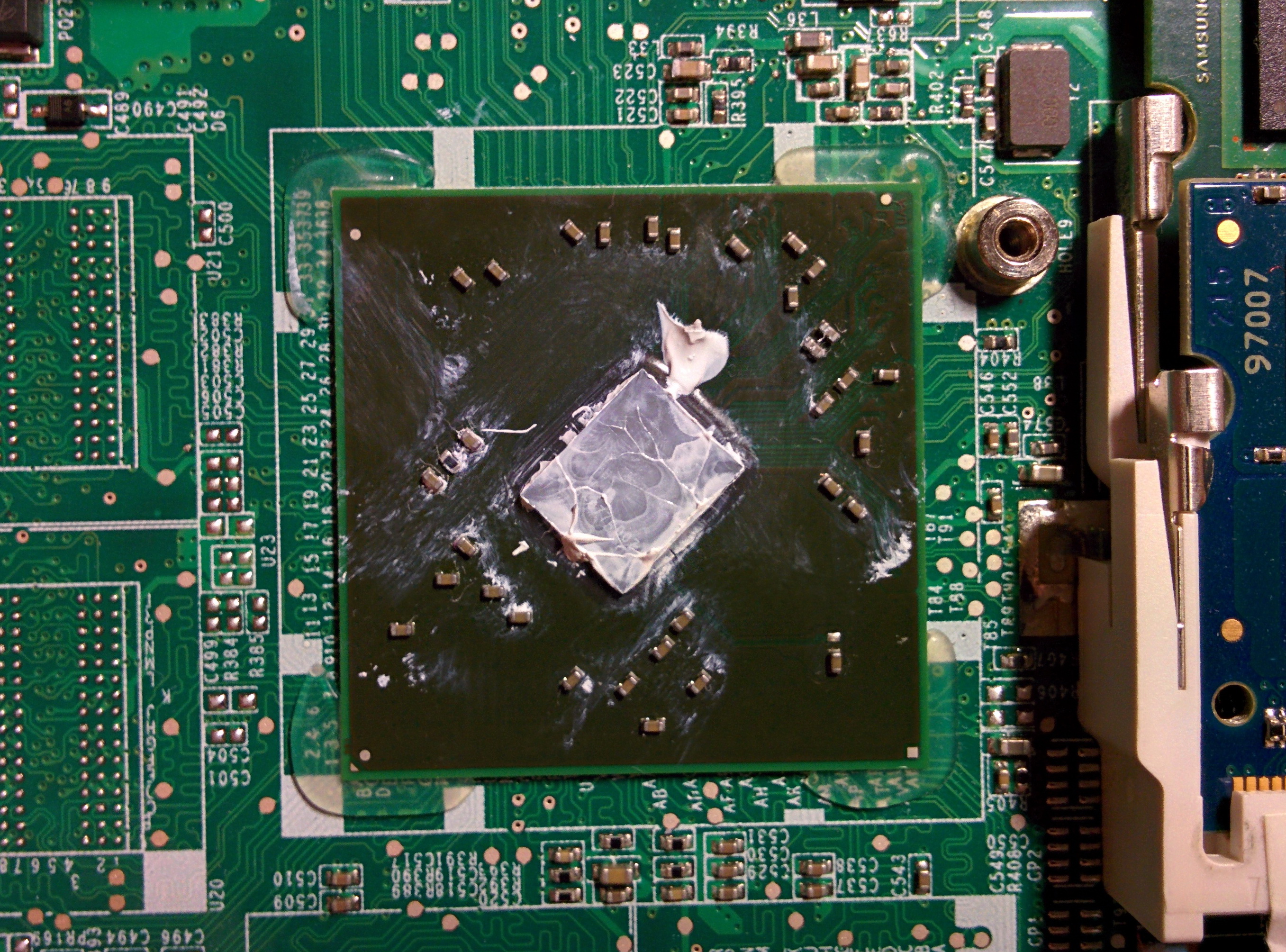

С выбором системы охлаждения пришлось повозиться. TDP этих процессоров составляет 140 Ватт, реальное потребление около 120 Ватт, поэтому и кулер пришлось искать соответствующий. В итоге, прочитав десятки обзоров и сотни отзывов я определился с двумя подходящими вариантами: Thermalright Macho Rev.A и Noctua NH-U14S. Выбирать не пришлось, т.к. Noctua могли привезти не раньше, чем через месяц.

В итоге, прочитав десятки обзоров и сотни отзывов я определился с двумя подходящими вариантами: Thermalright Macho Rev.A и Noctua NH-U14S. Выбирать не пришлось, т.к. Noctua могли привезти не раньше, чем через месяц.

Для монтажа 4K видео (тем более, если вы плотно работаете в After Effects) вам нужно много памяти. Я установил 32 Гб, заняв все 8 слотов. Если бы в продаже в одном месте было 4 одинаковых модуля по 8 Гб я бы, разумеется, купил их. Но с доступностью таких планок DDR4 даже в Москве есть проблемы. Ознакомившись с обзорами стало понятно, что переплачивать 100% стоимости за маркетинговую фишку — «разогнанную память» смысла нет никакого, т.к. разницы в производительности в реальных приложениях нет вообще. А если так уж хочется разогнать — так это можно сделать самостоятельно. Тем не менее, мне досталось 2 комплекта по 16ГБ G.Skill, работающих на частоте 2400 МГц (с небольшим заводским разгоном и вшитым профилем XMP), благо на цене это никак не отразилось, что еще раз говорит о том, что накрутка за разгон — чистый маркетинг.

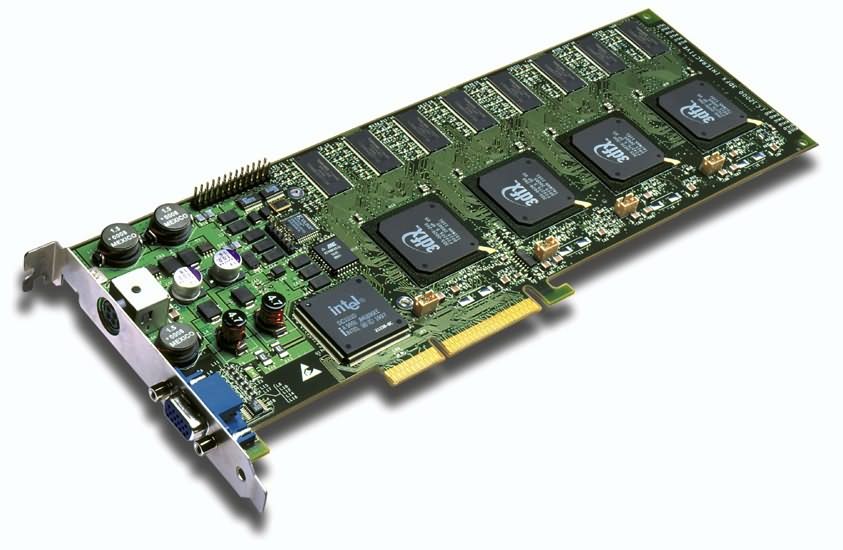

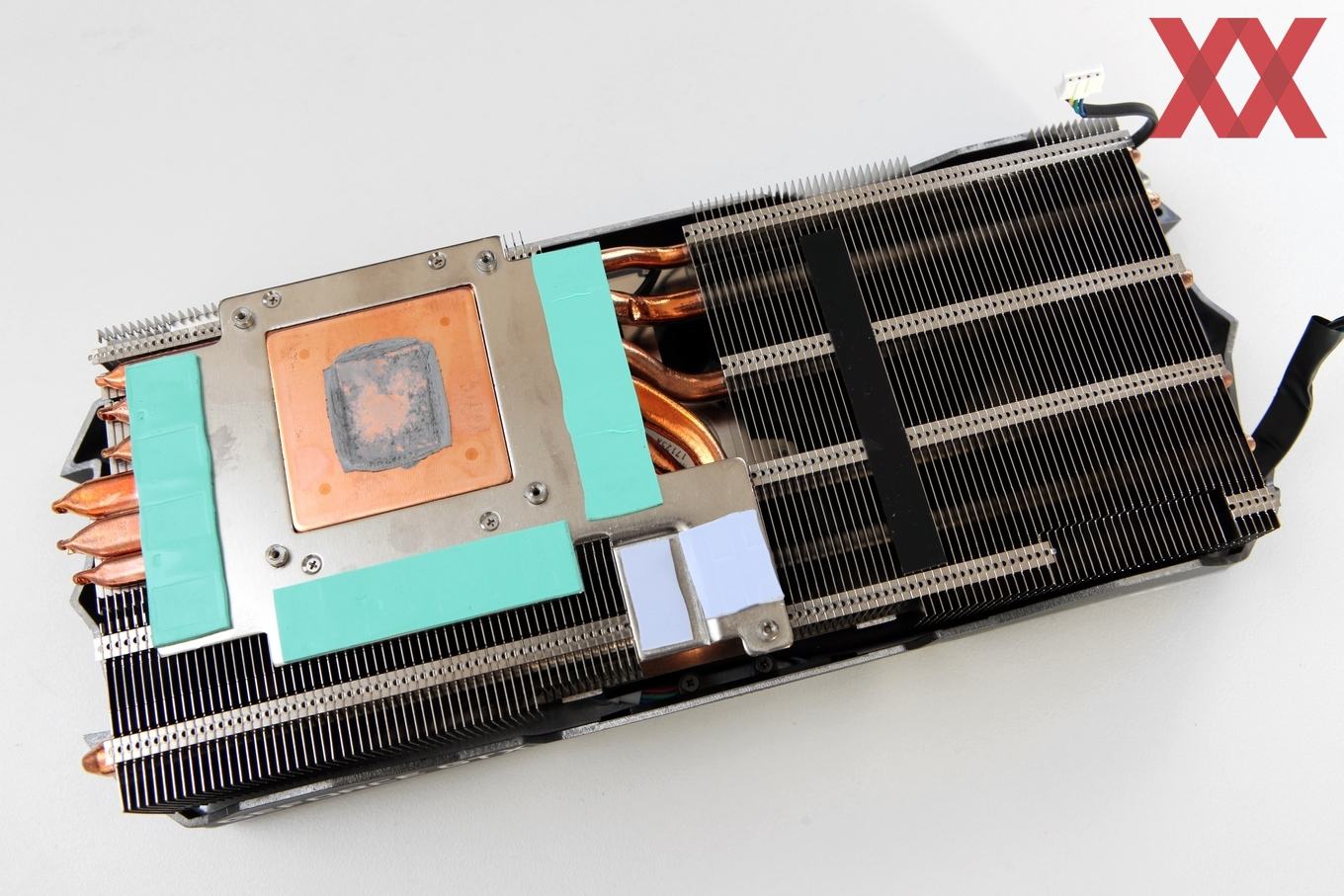

Поскольку современные версии видеоредакторов для расчета эффектов применяют мощности видеокарт, то хорошая видеокарта вам также потребуется. AMD Radeon обладают более высокой чистой математической мощностью, но в среде Windows для Adobe Premiere есть несколько визуальных фильтров, которые работают только на картах от nVidia. Вот эти парни проделывают большую работу, постоянно тестируя разные видеокарты с разными плагинами, рекомендую почитать их.

Главное, что нужно помнить, что если вы монтируете видео в разрешении 4K, то объем видеопамяти для вас будет так же важен, как и графическая производительность видеоядра. Я приобрел Gigabyte nVidia GeForce 960 GTX с 4ГБ памяти под свои задачи, Radeon R9 380 обеспечивают сходную производительность, но потребляет значительно больше энергии. Просадок из-за 128-битной шины памяти 960 GTX еще не показал ни один техно-сайт, видимо, потому что эти видеокарты все равно не потянут игры в разрешении 4K, а для игр в FullHD разницы нет. Я в игры вообще не играю, так что мне разницы нет тем более.

Я в игры вообще не играю, так что мне разницы нет тем более.

Качественный блок питания очень важен, но глупо выбирать его по принципу «чем больше, тем лучше». Реальное потребление подобной системы на пике мощности — 450 Ватт, поэтому 600-Ваттного блока питания будет более, чем достаточно. Aerocool серии KCAS — качественные блоки питания с сертификатом Bronze+ по разумным ценам, что не раз подтверждалось многочисленными тестами всей линейки на сайтах с заслуженной репутацией. Если будете выбирать себе блок питания — смотрите, чтобы версия ATX была не ниже 2.3, а лучше 2.4. Это важно для корректной работы некоторых процессоров Intel в состоянии простоя «С1».

Корпус, жесткие диски, привод я решил не менять — в этом нет необходимости. В качестве системного диска я использую уже не новый и не самый быстрый, но надежный Intel SSD 520 240 Гб. В будущем планирую поставить еще один SSD диск такого же объема, чтобы все файлы одного проекта находились на твердотельном накопителе, хотя это и не дает такого уж значительного эффекта, но об этом ниже.

Итоговая конфигурация

Итак, сводная таблица, а дальше я расскажу о производительности.

Процессор: Intel Core i7-5820K

Материнская плата: MSI X99A SLI PLUS

Оперативная память: DDR4 2400 MHz G.Skill 8*4 Gb

Видеокарта: Gigabyte nVidia GeForce 960 GTX 4Gb

Системный диск: SSD Intel 520 240Gb

Портативный диск USB 3.0 (для тестов) Seagate Backup Plus Portable Drive SRD00F1 2TB

Рабочие диски: 4 HDD 7200 rpm

Блок питания: Aerocool KCAS 600W

Тестирование производительности в Adobe Premiere Pro

Работа с 4K контентом проверялась в Adobe Premiere Pro CC 2015 v 9.0 (работа с потоками) и Adobe Premiere Pro CC 2014 v8.1 (работа с эффектами) на файлах снятых видеокамерой Sony FDR-AX100 (XAVC-S, битрейт 60 Mbs) и квадрокоптером DJI Phantom 3 Pro (60 Mbs).

Многопоточный вывод 4K видеоSSD vs USB 3.0 HDD: есть ли большая разница?

Вначале я решил протестировать дисковую производительность и посмотреть сколько потоков видео 4K система сможет воспроизводить одновременно. Я выбрал два режима: когда исходные файлы находятся на SSD и когда лежат на портативном жестком диске, подключенном через USB 3.0. Для этого я сделал две отдельные секвенции с соответствующими исходниками длиной по 32 секунды каждая. Я предполагал, что разница будет просто разительная, на деле все оказалось совсем не так.

Окно просмотра 1/2 (разрешение FullHD):

SSD Intel 520 240Gb.

5 потоков 4K — пропущено 2 кадра (т.е. без тормозов)

SSD Intel 520 240Gb.

6 потоков 4K — пропущено 189 кадров.

Таким образом, Adobe Premiere на этой системе и с этим SSD может тянуть без задержек максимум 5 потоков 4K в окне просмотра с выводом в FullHD. Разумеется, это идеальные условия: видео запускается с начала и играется до конца. Если вы будете им манипулировать, двигать, обрезать и тут же ставить playback, то будут существенные фризы из-за того, что Премьер не успеет начать чтение всех потоков.

Разумеется, это идеальные условия: видео запускается с начала и играется до конца. Если вы будете им манипулировать, двигать, обрезать и тут же ставить playback, то будут существенные фризы из-за того, что Премьер не успеет начать чтение всех потоков.

Ну а теперь возьмем обычный портативный 2,5″ USB 3.0 диск со скоростью вращения 5400 rpm. Подобные диски я использую для бэкапов и часто монтирую прямо с них.

USB 3.0 Seagate Backup Plus Portable Drive 2,5″ 2TB

4 потока 4K — пропущено 0 кадров.

А вот при 5 потоках видео начинает сильно тормозить за гранью комфортного просмотра. Так что мы имеем? Что в разы более быстрый SSD (тем более при многопоточной нагрузке) выигрывает всего 20% (тянет на 1 поток больше). Adobe пора задуматься над оптимизацией, мне кажется. Разумеется, наш 4K в 65mbs и 4K в 300 mbs это разные вещи. Но, согласитесь, никто не выводит в одно окно 4 потока, такие штуки делаются, в основном в After Effects, а не в Premiere. 99% времени мы работаем всего с 1 потоком на экране, переключаясь между ними при многокамерной съемке. Так что факт остается фактом: помещение исходников на SSD для Adobe Premiere 2015 CC не имеет большого смысла для битрейтов менее 100 mbs. Достаточно обычных внутренних жестких дисков на 7200 rpm.

99% времени мы работаем всего с 1 потоком на экране, переключаясь между ними при многокамерной съемке. Так что факт остается фактом: помещение исходников на SSD для Adobe Premiere 2015 CC не имеет большого смысла для битрейтов менее 100 mbs. Достаточно обычных внутренних жестких дисков на 7200 rpm.

Теперь посмотрим как изменится ситуация, если в окне вывода выставить разрешение 1/4 от оригинала. Для 4К этого более-менее достаточно, если вы не выводите окно просмотра на отдельный монитор, но здесь этот тест, скорее, для общего понимания.

Окно просмотра 1/4:

SSD Intel 520 240Gb.

6 потоков 4K — пропущено 4 кадра (т.е. без тормозов)

USB 3.0 Seagate Backup Plus Portable Drive 2,5″ 2TB

5 потоков 4K — пропущено 4 кадра (т. е. без тормозов)

е. без тормозов)

При добавлении еще одного видеоряда, в обоих случаях начиналось сильное торможение. Вывод: просмотр в разрешении 1/4 оригинала дает возможность проигрывать дополнительно 1 поток видео, но в реальной жизни картинка такого разрешения мало приемлема.

Работа с видеоэффектами в реальном времениОкно вывода 1/2 (разрешение FullHD). Рендер в Film Convert и Magic Bullet Looks на CPU.

Реалтайм с добавлением эффектов на видео я тестировал в Adobe Premiere Pro CC 2014 v8.1. Забегая вперед — здесь все выглядит более чем отлично, сразу чувствуется реальная производительность системы. Какие конкретно фильтры я применял будет написано подробно, но отдельно остановлюсь на настройках фильтров для цветокоррекции, т.к. функций в них предостаточно. В Magic Bullet Looks я поставил все мыслимые фильтры, в том числе и тяжелый Cosmo. Для реальной цветокоррекции все вместе они редко применяются и собраны лишь для того, чтобы проверить систему в тяжелых режимах.

Плагин FilmConvert Pro 2 не предлагает таких обширных возможностей, поэтому в нем я ограничился эмуляцией пленки, коррекцией экспозиции и работой с уровнями.

Для первого прогона я использовал 45-секундный фрагмент, состоящий из двух видео, соединенных между собой cross disolve. На каждом были наложены: Warp Stabilizer, Magic Bullet Looks, Sharpen.

Ролик содержал 1137 из них было пропущено 8. Видно, что система работала на грани. Тем не менее, вытянула реалтайм. Нагрузка на процессор составила 100%. Это и есть потолок данной системы. В реальном монтаже, как я уже говорил, Magic Bullet Looks применяется с гораздо меньшим числом фильтров, так что даже при включенном Warp Stabilizer никаких проблем вы испытывать не будете. Никакого пререндера. Очень хороший результат.

Теперь же перейдем к более естественному тесту. Последовательность видео та же самая, на каждый видеоролик наложены фильтры: FilmConvert Pro 2, Sharpen.

Никаких просадок, нет пропущенных кадров, все очень плавно, нагрузка на процессор всей системы — 65%. Т.е. в реальной работе вы можете использовать цветокоррекцию, еще некоторые фильтры и выводить все это в реал-тайме в разрешении FullHD. При этом у вас остается запас мощности для работы с 4K материалом более высокого битрейта и с большей частотой кадров.

Теперь запустим аналогичный тест, но выставим в настройках плагинов цветокоррекции рендер с помощью GPU (OpenCL)

Окно вывода 1/2 (разрешение FullHD). Рендер в Film Convert и Magic Bullet Looks на GPU.

Нагрузка на процессор составляла от 13% до 60%. Нагрузка на видеокарту была около 20%.

Окно вывода 1/1 (разрешение 4K). Рендер в Film Convert и Magic Bullet Looks на GPU.

Теперь повторим предыдущий тест, но в окне просмотра поставим полное разрешение 4K.

Нагрузка на процессор составила от 45% до 100%, в среднем держалась в районе 85-90%. Нагрузка на видеокарту также была очень неравномерной: от 18% до 80%, в среднем на уровне 45%.

Нагрузка на видеокарту также была очень неравномерной: от 18% до 80%, в среднем на уровне 45%.

Как видно, включение рендера силами GPU везде, где это только возможно, снижает нагрузку на процессор в 3-4 раза, что увеличивает общую отзывчивость системы (хоть и не до того уровня, как хотелось бы).

Узкие места

Как обычно, узким местом Adobe Premiere Pro CC 2015 (как и его предшественников) осталась навигация по таймлайну. Если само проигрывание идет без тормозов, то непосредственно в работе ощущаются задержки и фризы из-за подгрузки видео, даже при размещении всех исходников на SSD. Особенно это проявляется если быстро скользить по видео (доходит вплоть до потери картинки), а если по таймлайну двигаться справа налево (т.е. когда видео проигрывается задом наперед) — все становится еще печальнее. Почему Premiere не использует немалый объем оперативной памяти, чтобы держать видео в полной готовности — непонятно. Ведь наверняка можно грузить в систему все фрагменты видеофайлов, которые в конкретный момент времени находятся на таймлайне. Я, конечно, не программист, но мне кажется, что девелоперам из Adobe еще есть над чем работать в плане комфорта нашей работы.

Я, конечно, не программист, но мне кажется, что девелоперам из Adobe еще есть над чем работать в плане комфорта нашей работы.

Таким образом, даже на таком мощном компьютере во время работы с 4K вы не получите той плавности, о которой мечтали. Причем, собрав систему еще в 2 раза мощнее — результат не изменится из-за несовершенства программного обеспечения.

Тем не менее, выбора у нас нет и работать нужно уже сейчас, Adobe Premiere обновляется достаточно часто, возможно, опять изобретут что-нибудь революционное типа Mercury Engine, как это было в свое время.

Посмотрите видео по теме монтажа в 4к 2018 года.

ЗаключениеПо моему мнению, 4K видео станет реально востребовано не ранее, чем через 2-3 года и то, только для короткого постановочного видео (я не беру крупные студии, снимающие художественные фильмы). 4K на телевидении потребует полного переоснащения и огромных инвестиций. Многие на это не пойдут, хотя ради движения прогресса в 4K уже активно снимаются спортивные мероприятия и транслируются по подписке немногочисленным владельцам 70-дюймовых телевизоров. 4K уже запихивают и в 40″, только вот с расстояния полтора метра разницы не видно, это ведь не монитор.

4K уже запихивают и в 40″, только вот с расстояния полтора метра разницы не видно, это ведь не монитор.

Крупнейшие американские кабельные операторы, студии и телеканалы не спешат переходить на UltraHD, используя его, в основном как пилотные проекты для прощупывания рынка. Их основной аргумент: переход на сверхвысокую четкость не принесет дополнительного дохода, зато принесет огромные расходы и заставит перестраивать всю бизнес-модель. А все дело в том, что обычному потребителю с 50″ телевизором не нужен 4K. Для которого он должен купить новый телевизор.

В России с переходом на 4K можно, тем более, не спешить, т.к. если видепроизводство для вас работа, а не просто увлечение, то вам и так понятно нынешнее положение дел в телеиндустрии, где FullHD будет править бал еще с десяток лет, если не больше. Достаточно того, что многие региональные телеканалы заказывают у студий контент в SD (при том, что снимают и монтируют его в HD).

Тем не менее, никто не мешает вам снимать 4K проекты для себя, даже там, где заказчик требует FullHD. В конце концов, ваше умение обращаться с 4K видео точно пойдет вам на пользу и выделит вас из общей массы, создав вам конкурентные преимущества.

В конце концов, ваше умение обращаться с 4K видео точно пойдет вам на пользу и выделит вас из общей массы, создав вам конкурентные преимущества.

P.S. Обновление 2017

В 2017 году я продолжаю монтировать на этом компьютере в Adobe Premiere Pro СС, изменений в конфигурацию я не вносил, за тем исключением, что сейчас весь монтаж идет с SSD дисков Kingstone HyperX Savage 240 Gb. Эти диски работают на пределе пропускной способности Sata III, переходить на что-то более быстрое — смысла нет, т.к. Adobe Premiere все равно не задействует всю производительность.

Ускорить обработку видео — это включить GPU видеокарты – MLife Studio

Если на вашем компьютере отдельная видеокарта, не интегрированная, то для того, чтобы видео обрабатывалось быстрее, нужно использовать GPU видеокарты.

Включение в настройках видеоредактора GPU ускорит прорисовку объектов в Adobe After Effects, при рендеринге видео ускорит сам процесс рендеринга, и самое главное — уменьшит нагрузку на центральный процессор.

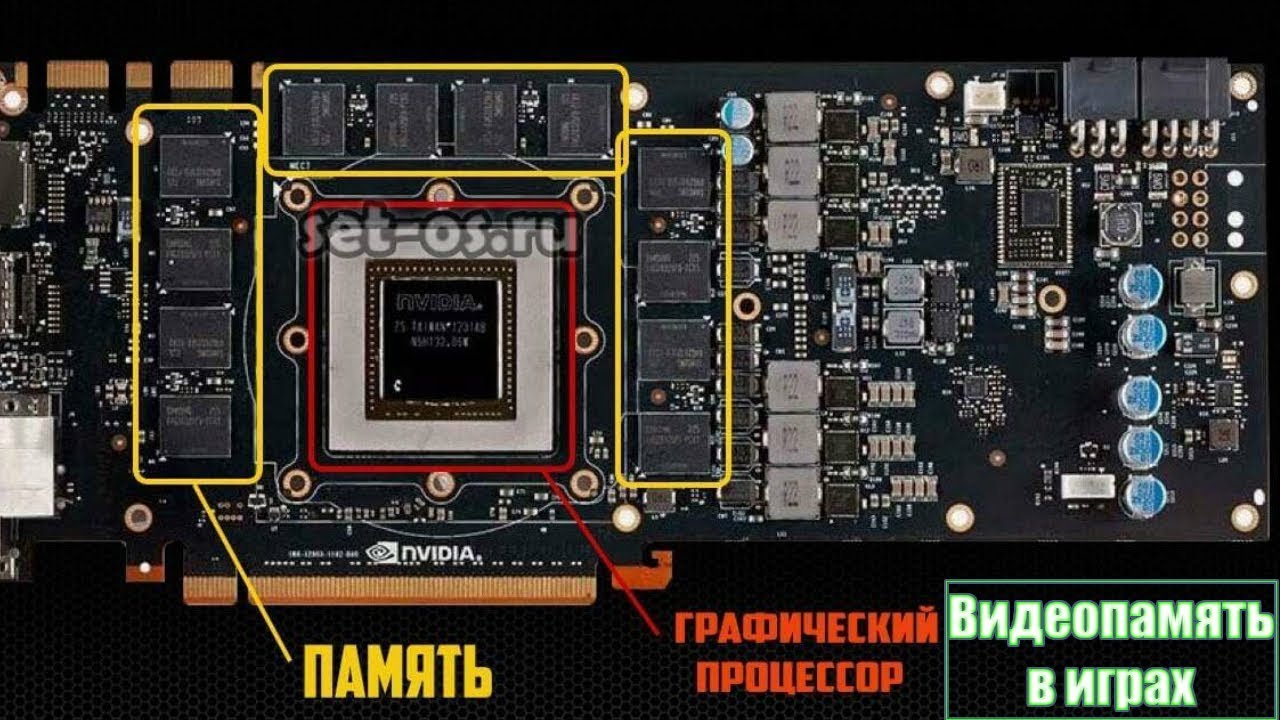

Что такое GPU видеокарты?

Это отдельный процессор самой видеокарты, который работает независимо от центрального процессора. Он выполняет обработку 2D или 3D графики и делает это лучше и быстрее нежели центральный процессор компьютера.

Другими словами, зачем вам нагружать CPU если для задач оцифровки видео есть GPU. Современные видеокарты имеют не только собственную оперативную память, что также немаловажно при работе с большими видеопроектами, но и собственный графический процессор.

Чтобы понять, как именно обрабатывается ваше видео, с помощью CPU или GPU, во время работы в видеоредакторе, откройте диспетчер задач и посмотрите, где больше нагрузки, на процессоре ЦПУ или на видеокарте.

Если видеокарта «спит», её нагрузка 2-5%, а процессор загружен по 90 или 100%, то обязательно нужно изменить настройки своего редактора. Он просто автоматически не подхватывает вашу видеокарту и всю работу по вычислению возлагает на процессор.

Итак, в Adobe Premiere — заходим во вкладку «Файл — Настройки проекта — Общие» и выбираем настройку CUDA, то есть GPU ускорение ядра. Теперь при работе с проектом, в диспетчере задач вы увидите, то центральный процессор загружен меньше, а графический (видеокарта) больше.

Теперь при работе с проектом, в диспетчере задач вы увидите, то центральный процессор загружен меньше, а графический (видеокарта) больше.

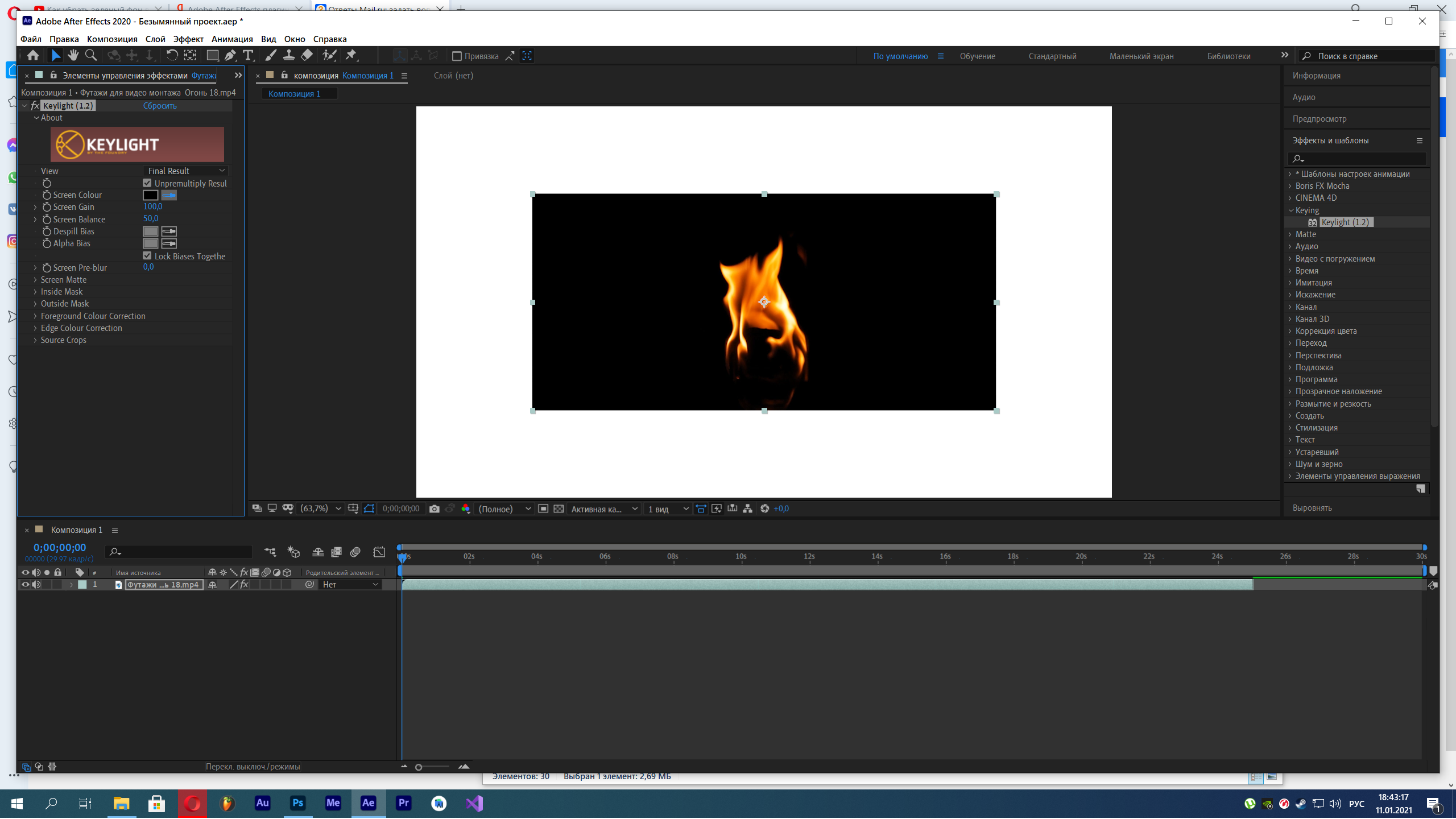

В Adobe After effects заходим во вкладку «Файл — настройки проекта — Рендеринг и эффекты видео». Выбираем настройку «Ускорение с использование ГП (GP) CUDA». Если по умолчанию эта настройка не будет включаться, каждый раз при настройке отдельного проекта, нужно проверить, какая опция стоит.

В Vegas идем в настройки общие. Options — preferences — во вкладку video. Здесь ищем пункт GPU и выбираем свою видеокарту.

Если это любой другой видеоредактор, то в настройках также нужно проверить, нет ли там опции, позволяющей программе работать с ваше картой. Например, в Movavi эта настройка выглядит так: «Включить аппаратное ускорение» и соответственно нужно будет выбрать карту. В моем случае Nvidia.

Итог. Если у вас интегрированная видеокарта, то вся нагрузка за обработку видео ляжет на ЦПУ. Тут без вариантов и чем мощнее процессор, то быстрее будет обрабатываться видео.

Если же у вас отдельная видеокарта, то нужно проверять, как программа подхватывает её и выбирать для работы GPU. Иначе ресурсы видеокарты не будут использоваться.

Ускоряем Premiere Pro и After Effects. Активация CUDA. — DJ KRYPTON

В сегодняшнем уроке я покажу как во много раз ускорить работу таких программ как Premiere Pro и After Effects с использованием технологии CUDA.

CUDA (англ. Compute Unified Device Architecture) — архитектура параллельных вычислений от NVIDIA, позволяющая существенно увеличить вычислительную производительность благодаря использованию GPU (графических процессоров видеокарт).

На сегодняшний день эта технология широко используется в различных областях, включая обработку видео, изображений, 3D графику и тд. Например, в программе Premiere Pro CS6 движок Mercury Playback, усиленный процессором графической карты, позволяет до 8 раз увеличить производительность многих фильтров цветокоррекции, обработку в реальном времени файлов с различными кодировками на одной линейке, промежуточных пересчетов и тд. В программе After Effects повляется возможность использовать новую технологию 3D ray-traced для упрощения и ускорения работы с графикой и анимацией. Полный список программ с поддержкой технологии CUDA.

В программе After Effects повляется возможность использовать новую технологию 3D ray-traced для упрощения и ускорения работы с графикой и анимацией. Полный список программ с поддержкой технологии CUDA.

Многие видеокарты по умолчанию не поддерживаются в программах Premiere Pro и After Effects CS6. К счастью, существует быстрый способ это исправить, который я и покажу Вам в этом уроке.

Для начала несколько фактов:

1. В этом уроке мы будем работать с видеокартой ASUS GeForce GTX 680 2GB, но не все видеокарты NVIDIA GeForce поддерживают технологию CUDA. Список поддерживаемых карт.

2. В Вашей системе должна быть установлена оперативная память не ниже DDR3.

3. Лучше использовать видеокарту с минимальным объемом памяти 1 ГБ.

4. Я покажу как активировать технологию CUDA на системе MAC OSX. Похожим способом можно активировать CUDA и на Windows машине.

Надеюсь, этот урок был полезным! Также надеюсь, что Вы быстро почувствуйте все прелести работы в знакомых приложениях, но на новых скоростях!

Сборка персонализированного ПК для Adobe After Effects

Сборка персонализированного ПК для программного обеспечения может сэкономить часы разочарований от редактирования медленной и неоптимизированной программы. Мы регулярно получаем клиентов с просьбой дать рекомендации по компонентам для Adobe Suite. Наши специалисты по продажам всегда готовы дать вам рекомендации по продуктам, но если вы хотите узнать больше о создании ПК для Adobe After Effects, вы можете получить от нас несколько полезных советов ниже!

Мы регулярно получаем клиентов с просьбой дать рекомендации по компонентам для Adobe Suite. Наши специалисты по продажам всегда готовы дать вам рекомендации по продуктам, но если вы хотите узнать больше о создании ПК для Adobe After Effects, вы можете получить от нас несколько полезных советов ниже!

Что такое Adobe After Effects?

Используется визуальными художниками, Adobe After Effects специализируется на анимированной графике, видео VR, анимации и эффектах CGI.Являясь частью Adobe Suite, After Effects отличается от Premiere тем, что позволяет художникам вносить последние штрихи в сцены и включать различные эффекты, недоступные в Adobe Premiere.

After Effects — отличный выбор для тех, кто хочет вывести свои видеоматериалы на новый уровень. Premiere в основном используется для сшивания «большей картины», в то время как After Effects можно использовать для добавления взрыва к сцене, изменения атмосферы с помощью тумана CGI и множества других применений.

Какие минимальные технические характеристики ПК мне необходимы для запуска Adobe After Effects?

Ниже приведены требования непосредственно от Adobe! Adobe предоставляет как минимальные, так и рекомендуемые спецификации. Минимальных спецификаций ПК будет достаточно, чтобы открыть программу и выполнить простые задачи, в то время как рекомендуемые должны позволить вам выполнить большинство задач, это может занять некоторое время и немного проверить ваше терпение, если вы запускаете программу.

Минимальных спецификаций ПК будет достаточно, чтобы открыть программу и выполнить простые задачи, в то время как рекомендуемые должны позволить вам выполнить большинство задач, это может занять некоторое время и немного проверить ваше терпение, если вы запускаете программу.

| Минимальные спецификации | |

| Процессор | Многоядерный процессор Intel с поддержкой 64-бит |

| Операционная система | Microsoft Windows 10 (64-разрядная) версии 1803 и выше |

| ОЗУ | Минимум 16 ГБ (рекомендуется 32 ГБ) |

| GPU | 2 ГБ видеопамяти GPU.Adobe настоятельно рекомендует обновиться до драйвера NVIDIA 451.77 или более поздней версии при использовании After Effects. Драйверы до этого имеют известную проблему, которая может привести к сбою. |

| Пространство на жестком диске | 5 ГБ свободного места на жестком диске; дополнительное свободное пространство, необходимое во время установки (не устанавливается на съемные флеш-накопители) Дополнительное дисковое пространство для дискового кэша (рекомендуется 10 ГБ) |

| Разрешение монитора | 1280 × 1080 или больше Разрешение дисплея |

| Интернет | Подключение к Интернету и регистрация необходима для обязательной активации программного обеспечения, подтверждения подписок и доступа к онлайн-сервисам. * * |

Приведенная выше информация является хорошим началом и подойдет тем, кто только изучает Adobe After Effects, а рекомендуемые компоненты могут легко получить обычный пользователь After Effects.

Как улучшить работу After Effects на моем ПК?

Послушайте, если вы активно используете Adobe After Effects для завершения проектов, то вы понимаете важность бесперебойной работы After Effects. Никому не нравится, когда программа неожиданно закрывается или на рендеринг уходит часы.Однако After Effects имеет множество применений, и каждое из них требует затрат на разные компоненты ПК. В зависимости от проектов, которые вы обычно выполняете, другой комплект ОЗУ может быть более выгодным, чем обновление ЦП. Наши специалисты по продажам тщательно исследовали и работали с Adobe Suite и могут дать вам оптимизированные рекомендации в рамках вашего бюджета, но мы рассмотрим базовое понимание оптимизации вашего персонализированного ПК для Adobe After Effects.

Какой процессор мне выбрать для After Effects?

After Effects предпочитает процессоры с большим количеством ядер, а не с более высокой рабочей частотой, но в какой-то момент это предел.

Мы рекомендуем Intel Core i9-10900F. Если вы предпочитаете систему на базе AMD, то Ryzen 9 3900X также станет отличным выбором. Обычно вы увидите лучшую производительность при выборе обновления ОЗУ, графического процессора или хранилища, чем при обновлении до платформы Intel Xeon или процессоров AMD Ryzen. Обычно лучше выделять больше средств из бюджета на другие компоненты.

Какой графический процессор лучше всего работает с Adobe After Effects?

Adobe рекомендует использовать видеокарту с 2 ГБ vRAM, которая соответствует графическим процессорам последнего поколения.After Effects довольно сильно зависит от производительности графического процессора для большинства задач, поэтому мы рекомендуем использовать Nvidia GeForce RTX 2080Ti. Лучшая игровая видеокарта на рынке.

Использование графического процессора для рабочих станций с Adobe имеет тенденцию к незначительному увеличению производительности, а графические процессоры класса рабочих станций обычно имеют большую долговечность. Однако производительность не стоит увеличения цены, и ваши деньги лучше потратить на что-то другое. Если вас особенно беспокоит перегрузка видеокарт, тогда карты Quadro RTX — лучший вариант!

Сколько оперативной памяти требуется After Effects?

After Effects требует 16 ГБ ОЗУ, но рекомендует 32 ГБ, что мы выбрали в нашей пользовательской конфигурации ПК After Effects.В зависимости от сложности моделей и эффектов, с которыми вы планируете работать, вы действительно не ошибетесь, обновив оперативную память для After Effects. Дополнительное пространство для маневра в вашем бюджете, вероятно, следует потратить, увеличивая его до 64 ГБ.

Рекомендация Adobe After Effects для индивидуальных ПК от AVADirect

В наших конфигурациях предусмотрены варианты обновления компонентов без помощи нашего отдела продаж.

Adobe After Effects Workstation PC

- Разъем: 1200

- ЦП: Core i7, Core i9

- Набор микросхем: Intel Z490

- Память: до 128 ГБ

- Хранение: до 8 жестких дисков или SSD-накопителей

- Графика: Поддерживает до 2 видеокарт

Наш пользовательский ПК Adobe After Effects содержит компоненты, оптимизированные для эффективной работы After Effects, при этом оставаясь при этом экономичным.Этот ПК поставляется с базовой конфигурацией Intel Core i9-10900F с возможностью обновления до Intel i9-10900K, если вам нужна более высокая частота для лучшей оптимизации вашей системы. Мы также выбрали ASUS ProArt Z490-Creator, который оптимизирован для использования на рабочих станциях. Выбирайте из широкого спектра видеокарт, в базовой конфигурации предварительно выбрана ASUS GeForce RTX ™ 2080 Ti OC. Как упоминалось выше, базовая конфигурация поставляется с 32 ГБ памяти Kingston HyperX Fury DDR4. Если вы планируете многозадачность, выберите больший объем памяти. Возможно, вы захотите заменить кулер с вентилятором на моноблок, если вы планируете разгонять процессор или загружать свою систему часами.

Возможно, вы захотите заменить кулер с вентилятором на моноблок, если вы планируете разгонять процессор или загружать свою систему часами.

С точки зрения хранения, мы предлагаем множество вариантов! Не стесняйтесь обновить твердотельный накопитель Samsung M.2 емкостью 250 ГБ или заменить его на твердотельный накопитель с интерфейсом SATA для повышения скорости записи. Базовая конфигурация поставляется с большим объемом памяти и здоровенным жестким диском на 4 ТБ, но вы немного жертвуете скоростью ради этого бюджета.

Хотите, чтобы персонализированный ПК с Adobe After Effects был оптимизирован для вашего сценария использования и бюджета? Наши компетентные специалисты по продажам доступны по телефону, электронной почте и в чате в обычные рабочие часы.Они с удовольствием обсудят вашу работу и поделятся своим мнением о том, какие компоненты оптимизируют ваш рабочий процесс в зависимости от ваших конкретных проектов.

Так ли важна обработка графики в After Effects?

Обратите внимание, что в обоих типах видеокарт мы много говорили о памяти. Имейте это в виду, потому что через минуту это станет большим событием.

Имейте это в виду, потому что через минуту это станет большим событием.

Действительно ли графический процессор важен для After Effects?

В недалеком прошлом графические процессоры были гораздо важнее, чем сегодня.Adobe когда-то использовала сертифицированную видеокарту для графического ускорителя 3D-рендеринга с трассировкой лучей, а также использовала OpenGL с графическим процессором для Fast Draft и OpenGL Swap Buffer. Однако интеграция OpenGL была изъята из After Effects компанией Adobe из-за отсутствия полной функциональности, а средство 3D-рендеринга с трассировкой лучей было заменено добавлением Cinema 4D Lite в After Effects CC. Итак, возникает вопрос. Действительно ли высококачественная видеокарта и графический процессор так важны для After Effects? Краткий ответ: нет.А теперь перейдем к более подробному ответу. По словам Рика Джерарда, редактора, 9 раз удостоенного премии «Эмми»:Графический процессор не используется для рендеринга 99% всего, что делает AE.

— Рик Джерард, редактор, удостоенный премии «Эмми»

Примечание: Рик использует After Effects с 1993 года и преподает его с 1995 года. Вау.

Итак, если графический процессор не имеет большого значения, то что?

Помните, всего несколько абзацев назад я сказал вам запомнить слово «память»? Что ж, теперь пора поговорить об этом подробнее.Хотя графическая карта будет иметь свою собственную выделенную память, After Effects никогда не использует все возможности этой памяти. Вместо этого After Effects в значительной степени полагается на память и центральный процессор вашего компьютера, а не на видеокарту или графический процессор внутри него.

Оперативная память, как мы ее называем, сегодня очень важна для подавляющего большинства программного обеспечения. Его основная функция — помогать процессору и получать информацию, необходимую для более быстрой обработки задания или задачи. Недостаток оперативной памяти может затруднить работу ЦП и усложнить выполнение работы.

Недостаток оперативной памяти может затруднить работу ЦП и усложнить выполнение работы.

Лучшая видеокарта для After Effects в 2021 году

Adobe After Effects — это технология компьютерных визуальных эффектов, анимированной графики и композитинга, созданная Adobe Systems при пост-продакшене фильмов, видеоигр и телешоу. After Effects можно использовать, помимо прочего, для отслеживания, создания сценариев и анимации. Он также имеет возможности простого нелинейного редактирования, редактирования аудио и перекодирования мультимедиа.

Не требуя C ++, After Effects Extensions позволяет расширить возможности After Effects с помощью современных технологий веб-разработки, включая HTML5 и Node.js. Популярная платформа расширяемости Adobe, или панели CEP, используются для расширений After Effects, что позволяет им интегрироваться с другими приложениями Adobe Creative Cloud.

Сторонние интеграции могут расширить возможности After Effects; самые популярные интеграции — это плагины и скрипты. Сценарии в After Effects — это набор команд, написанных на JavaScript и ExtendScript. За исключением плагинов, сценарии After Effects могут получить доступ только к ключевым функциям After Effects.

Сценарии в After Effects — это набор команд, написанных на JavaScript и ExtendScript. За исключением плагинов, сценарии After Effects могут получить доступ только к ключевым функциям After Effects.

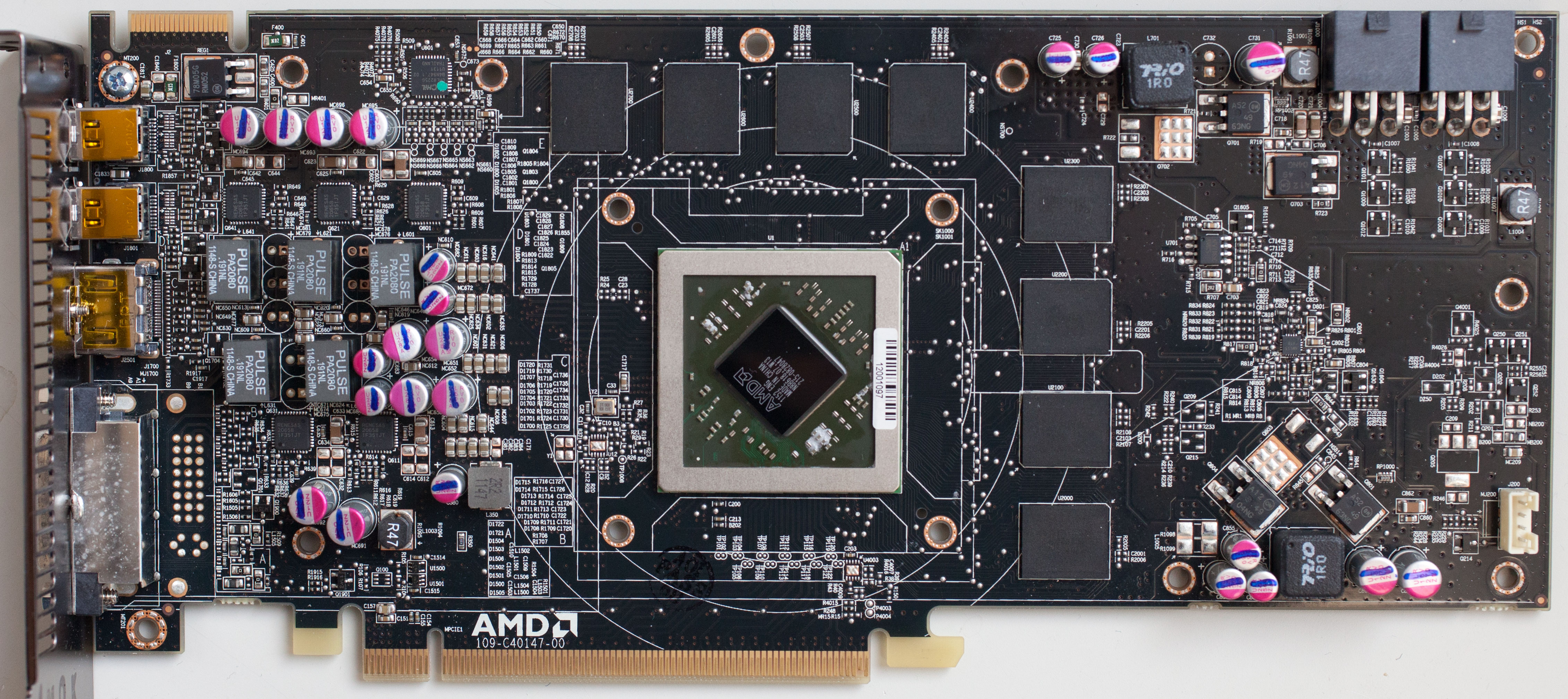

Nvidia Quadro RTX 4000 с чудовищными возможностями, производительностью и функциями занимает первое место в списке видеокарт.По сравнению с некоторыми другими профессиональными видеокартами NVIDIA, Quadro RTX 4000 кажется очень мягким решением. Что касается вычислительной пропускной способности, Quadro RTX 4000 значительно опережает Quadro P4000 и Radeon Pro WX7100, превосходя P5000. Превосходя стандартную про-графику Nvidia за счет значительного обеспечения пиковой пропускной способности памяти и дополнительных функций, этой видеокарте удалось стать лучшим продуктом в этой статье.

В этой статье удастся настроить лучший графический процессор для работы после эффектов путем проведения различных тестов и тестов.

| Дизайн | Руководства по покупке | Продавец |

|---|

| Частота памяти | 1750 МГц |

| Частота разгона | 1545 МГц |

| Имя графического процессора | TU102 |

| Тактовая частота | 1350 МГц |

GeForce RTX 2080 Ti — третий по популярности графический процессор на рынке, даже если вы ищете более мощный графический процессор или хотите получить преимущество перед видением Nvidia будущего с трассировкой лучей..jpg) С точки зрения игры, видеокарта Nvidia GeForce RTX 2080 Ti по-прежнему остается зверем. Он добавляет отличную технологию трассировки лучей и тензорные ядра на базе искусственного интеллекта для каждой миссии с интенсивным использованием графики, и он может играть со скоростью более 60 кадров в секунду в 4K. Он, несомненно, превосходит своего предшественника, Nvidia GeForce GTX 1080 Ti.

С точки зрения игры, видеокарта Nvidia GeForce RTX 2080 Ti по-прежнему остается зверем. Он добавляет отличную технологию трассировки лучей и тензорные ядра на базе искусственного интеллекта для каждой миссии с интенсивным использованием графики, и он может играть со скоростью более 60 кадров в секунду в 4K. Он, несомненно, превосходит своего предшественника, Nvidia GeForce GTX 1080 Ti.

Если вы хотите играть в высококачественные игры, вы не ошибетесь, выбрав Nvidia GeForce RTX 2080 Ti. В частности, если вы объедините его с лучшим процессором и игровым дисплеем, что позволит вам получить от него максимальную отдачу.Nvidia GeForce RTX 2080 Ti обладает впечатляющими характеристиками с 11 ГБ видеопамяти GDDR6, оснащенными 4352 ядрами CUDA и максимальной тактовой частотой 1635 МГц.

Это все из-за первого в истории персонального заводского разгона Nvidia до 90 МГц. С другой стороны, Nvidia GeForce GTX 1080 Ti имеет 11 ГБ видеопамяти GDDR5X последнего поколения, 3584 ядра CUDA и максимальную полосу пропускания 1582 МГц.

Согласно TechRadar, ядра RT и Tensor — это два дополнительных ядра, используемых в этом графическом процессоре, которых не хватало его предшественникам.Трассировка лучей поддерживается 68 ядрами RT RTX 2080 Ti, что позволяет этой видеокарте создавать гораздо более сложные ситуации освещения в реальном времени и естественное затенение, чем когда-либо могла делать 1080 Ti.

Число 544 тензорных ядер представляет машинное обучение (ИИ), которое Nvidia планирует повысить эффективность сглаживания. Turing, по данным Nvidia, в восемь раз быстрее, чем Pascal, при обработке сглаживания благодаря машинному обучению. Тензорные ядра также поддерживают новую технику, известную как суперсэмплинг глубокого обучения, которая может повысить разрешение, а также добавить сглаживание на уровне пикселей.

RTX 2080 Ti имеет два таких порта, которые могут обеспечить до 100 ГБ общей полосы пропускания для поддержки нескольких дисплеев 8K в режиме объемного звучания.

Кулер с вентилятором часто был включен в состав первых карт, который всасывает холодный воздух через свой вентилятор, чтобы отфильтровать тепло через заднюю часть карты. Между тем, машина с двумя вентиляторами забирает холодный воздух и разбрызгивает его на открытый кулер процессора, чтобы отводить тепло в обоих направлениях. Герметичная паровая камера покрывает всю печатную плату или печатную плату Nvidia RTX 2080 Ti, в дополнение к существующим вентиляторам.

Между тем, машина с двумя вентиляторами забирает холодный воздух и разбрызгивает его на открытый кулер процессора, чтобы отводить тепло в обоих направлениях. Герметичная паровая камера покрывает всю печатную плату или печатную плату Nvidia RTX 2080 Ti, в дополнение к существующим вентиляторам.

Благодаря этому, а также конструкции с двумя вентиляторами, вся система работает вместе, обеспечивая ультра-прохладный и бесшумный результат. Он не только опережает GeForce GTX 1080 Ti, но и значительно опережает Nvidia Titan Xp.

Почти в каждом смоделированном тесте последняя флагманская карта GeForce от Nvidia опережает на 2 000 баллов, и в каждом из наших игровых тестов она предлагает как минимум на десять больше кадров в секунду (fps). Nvidia всегда значительно опережала AMD, а с RTX 2080 Ti создается впечатление, что бизнес переместился в следующую галактику.

Удивительно, но Nvidia RTX 2080 Ti использует меньше топлива для достижения такой производительности, чем Titan XP и 1080 Ti, которые он превосходит.

Все больше и больше геймеров поддерживают новые технологии, среди последних дополнений — Cyberpunk 2077 и Call of Duty: Modern Warfare. Nvidia RTX 2080 Ti — последняя лучшая свинья во вселенной видеокарт.

Плюсы

- Возможность игры в 4K со скоростью 60 кадров в секунду

- DLSS — еще одна захватывающая функция с огромным потенциалом

- Устанавливает новую планку производительности одного графического процессора

Минусы

- Единственный реальный вариант для компьютерных игр 4K, и высокая цена означает, что

- Поддержка игр для уникальных функций трассировки лучей должна подождать

В линейку Quadro RTX входят четыре видеокарты, от чудовищной Quadro RTX 8000 с 48 ГБ GDDR6 до Quadro RTX 4000, предназначенные для более популярных создателей контента.

По сравнению с некоторыми другими профессиональными видеокартами NVIDIA, Quadro RTX 4000 кажется очень мягким решением.

NVIDIA Quadro RTX 4000, как и GeForce RTX 2060 и RTX 2070, основана на графическом процессоре Turing TU106. Он имеет графический процессор, который может работать на частоте 1545 МГц и объединен с 8 ГБ GDDR6 через 256-битный интерфейс для скорости передачи данных 13 Гбит / с. Карта обеспечит пиковую пропускную способность памяти до 415 ГБ / с на этой скорости.

Quadro RTX 4000 превосходит Quadro P4000 на базе Pascal в стандартной линейке профессиональных графических процессоров NVIDIA, обладая значительно большей производительностью по всем направлениям и значительно большим объемом памяти, а также некоторыми дополнительными функциями благодаря структуре кэша графических процессоров на основе Тьюринга и лежащей в основе Особенности.

Поскольку TDP Quadro RTX 4000 намного выше, чем у Quadro P4000 (160 Вт против 105 Вт), ему также требуется только один дополнительный источник питания.

Один 8-контактный разъем питания PCI Express выступает из задней части вентилятора на дальнем конце. Quadro RTX 4000 имеет три полноразмерных порта DisplayPort (DP1.4) и один разъем VitualLink в стиле USB-C, четырехканальный порт HBR3 DisplayPort и USB 3.1 Gen 2 через один разъем.

Quadro RTX 4000 имеет три полноразмерных порта DisplayPort (DP1.4) и один разъем VitualLink в стиле USB-C, четырехканальный порт HBR3 DisplayPort и USB 3.1 Gen 2 через один разъем.

Quadro RTX 4000 значительно опережает Quadro P4000 и Radeon Pro WX7100 по пропускной способности хэширования, превосходя P5000.RX 4000 отстает от Radeon Pro WX 7100 в тесте шифрования / дешифрования AES256. С Quadro RTX 4000 эффективность обработки изображений была превосходной. В этом тесте карта почти догнала Radeon Pro WX 8200 и легко опередила Quadro P4000 и P5000.

Низкое энергопотребление Quadro RTX 4000 превращается в удивительно тихую видеокарту. Quadro RTX 4000 работает бесшумно на рабочем столе или при небольшой нагрузке и не будет заметен в закрытом корпусе над стандартным кулером ЦП или блоком питания.

В целом NVIDIA Quadro RTX 4000 оказалась хорошей видеокартой. Нет никакой разницы между RTX 4000 и Quadro P4000 на базе Pascal предыдущего поколения — RTX 4000 был значительно быстрее в любой тестируемой нами рабочей нагрузке. В некоторых случаях Quadro RTX 4000 превосходил Quadro P5000, несмотря на значительно более высокую цену последнего.

В некоторых случаях Quadro RTX 4000 превосходил Quadro P5000, несмотря на значительно более высокую цену последнего.

В наших образцах Quadro RTX 4000 победил Radeon Pro WX 7100 и сражался с немного более дорогим Radeon Pro WX 8200, в то время как RTX 4000 значительно опередил в некоторых тестах рендеринга (например, V-RAY ).

Гигабайт GeForce RTX 2070| Частота памяти | 1750 МГц |

| Базовая частота | 1410 МГц |

| Тактовая частота с ускорением | 1620 МГц |

| TDP | 175 Вт |

GeForce RTX 2070 Gaming OC 8G от Gigabyte превосходит карту Nvidia Founders Edition, поэтому стоит меньше.Прямо из коробки карта обеспечивает фантастическую частоту кадров в разрешении 2560 x 1440 с полностью встроенными настройками детализации. Благодаря большему напряжению питания, тепловому решению с тремя вентиляторами, разогнанной частоте ядра, RGB-подсветке и значительной скидке Gigabyte GeForce RTX 2070 Gaming OC 8G стремится превзойти итерацию Founders Edition. По большей части это работает.

Он плавнее, чем GeForce GTX 1080, имеет более современную архитектуру и стоит почти столько же. 2070 Gaming OC 8G — отличный вариант, если вы играете в разрешении 2560 x 1440 с приличными настройками качества.Просто убедитесь, что он в футляре с хорошей вентиляцией. Переработанный кулер Windforce 3X будет признателен.

Карта Nvidia Founders Editionдороже, чем GeForce RTX 2070 Gaming OC 8G от Gigabyte. Это то, что нужно многим игрокам, чтобы получить рекомендацию. Компания Gigabyte сделала недорогой RTX 2070 на длинной плате с прикрепленными переходниками и восьмифазным блоком питания, который нам нужен.

Если вы можете иметь дело с процессором TU106, предназначенным для более низких тактовых частот, есть более дешевые карты RTX 2070, чем Gigabyte 2070 Gaming OC.Кулер от Nvidia — тоже наш фаворит. Чтобы не отставать от огня TU106, его меньшие 80-миллиметровые вентиляторы должны вращаться быстро.

Предел стандартной мощности, который, как правило, примерно на 40 Вт выше, чем у платы Nvidia, усугубляет ситуацию. Gigabyte может достичь агрессивных тактовых частот благодаря повышенному напряжению графического процессора, но это также означает, что вентиляторы должны справиться с большим количеством тепла. Когда вы помещаете карту в заблокированное шасси, ситуация становится еще хуже.

В худшем случае температура графического процессора превышает 80 ° C, вентиляторы вращаются со скоростью почти 2700 об / мин, а частота ядра падает ниже эталонных 1620 МГц Nvidia.Удивительно, но большинство игр не имеют такой тепловой нагрузки, как FurMark.

Как сказано в аппаратном обеспечении Тома, Gigabyte обсыпает пластиком кожух Gaming OC 8G, который вмещает три 80-мм вентилятора (вместо двух 82-мм вентиляторов 2080 Gaming OC 8G). Эти вентиляторы продувают множество алюминиевых пластин, разделенных на три секции.