Рецепты частотного разложения

Метод частотного разложения, на мой взгляд – это лучшая на сегодняшний день технология, позволяющая отдельно работать с детализацией и цветом. Для тех, кому интересны теоретические основы этого метода, рекомендую почитать соответствующие материалы в ЖЖ Андрея Журавлева, так как не вижу смысла дублировать то, что уже было сделано до меня, причем, максимально подробно, с описанием математики.

Мы же с вами коснемся чисто практических аспектов и нюансов применения данного метода, рассмотрим как достоинства, так и недостатки, а точнее, ограничения различных способов реализации метода частотного разложения.

Если вы уже сталкивались с этим методом, то знаете, что существует несколько способов его реализации.

Разложение на две частоты с помощью фильтров Размытие по Гауссу (Gaussian Blur) и Цветовой контраст (High Pass).

Именно этот метод получил поначалу самое широкое распространение в сети. Он прост в реализации, но имеет некоторые ограничения в применении.

Для того, чтобы разложить изображение на две частоты, нужно выполнить следующие операции:

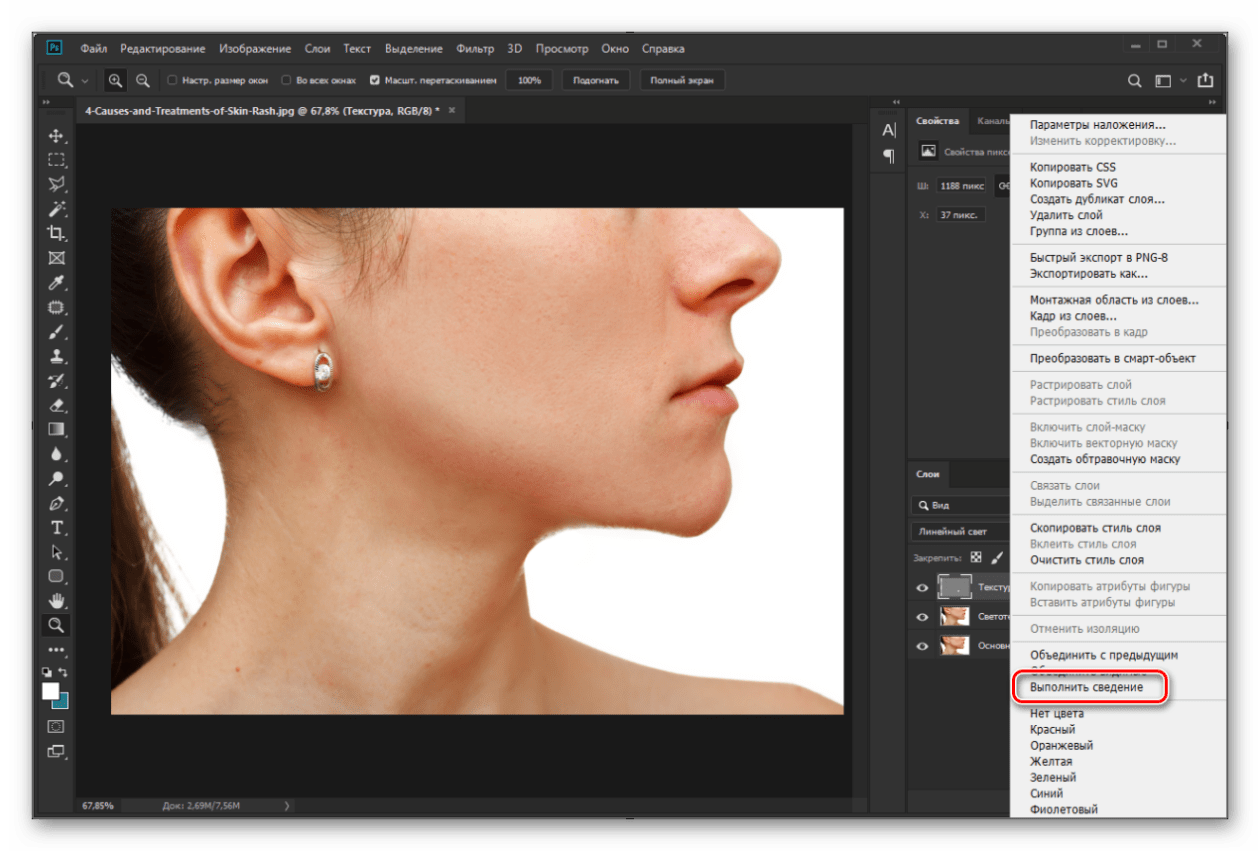

1. Создаем копию фонового слоя или объединяем видимые слои на отдельный слой.

2. Называем ее как-то осмысленно, исходя из того, что этот слой будет являться основой для дальнейших действий. Например, Base или Основа.

3. Делаем две копии слоя Base. Первую называем Low или Низкая частота, вторую, соответственно, High или Высокая частота.

4. Дальнейшие действия зависят от того, на какую составляющую мы будем ориентироваться. Если нам важно вынести на слой

5. К слою High применяем фильтр Цветовой контраст (High Pass) с таким радиусом, чтобы видеть только ту текстуру кожи, которая нам нужна. Радиус не должен быть слишком малым, иначе часть хорошей текстуры уйдет на слой с низкой частотой, то есть

Радиус не должен быть слишком малым, иначе часть хорошей текстуры уйдет на слой с низкой частотой, то есть

Неправильный выбор радиуса фильтра Цветовой контраст. Слишком большой радиус.

Неправильный выбор радиуса фильтра Цветовой контраст. Слишком маленький радиус.

Оптимальный радиус фильтра Цветовой контраст

6. Подобрав необходимый радиус фильтра Цветовой контраст (High Pass), например, 5 пикселей, запоминаем его и применяем. Очень желательно прописать радиус фильтра в названии слоя. Например,

7. Применяем фильтр Размытие по Гауссу (Gaussian Blur) с таким же радиусом, то есть, в данном случае, 5 пикселей.

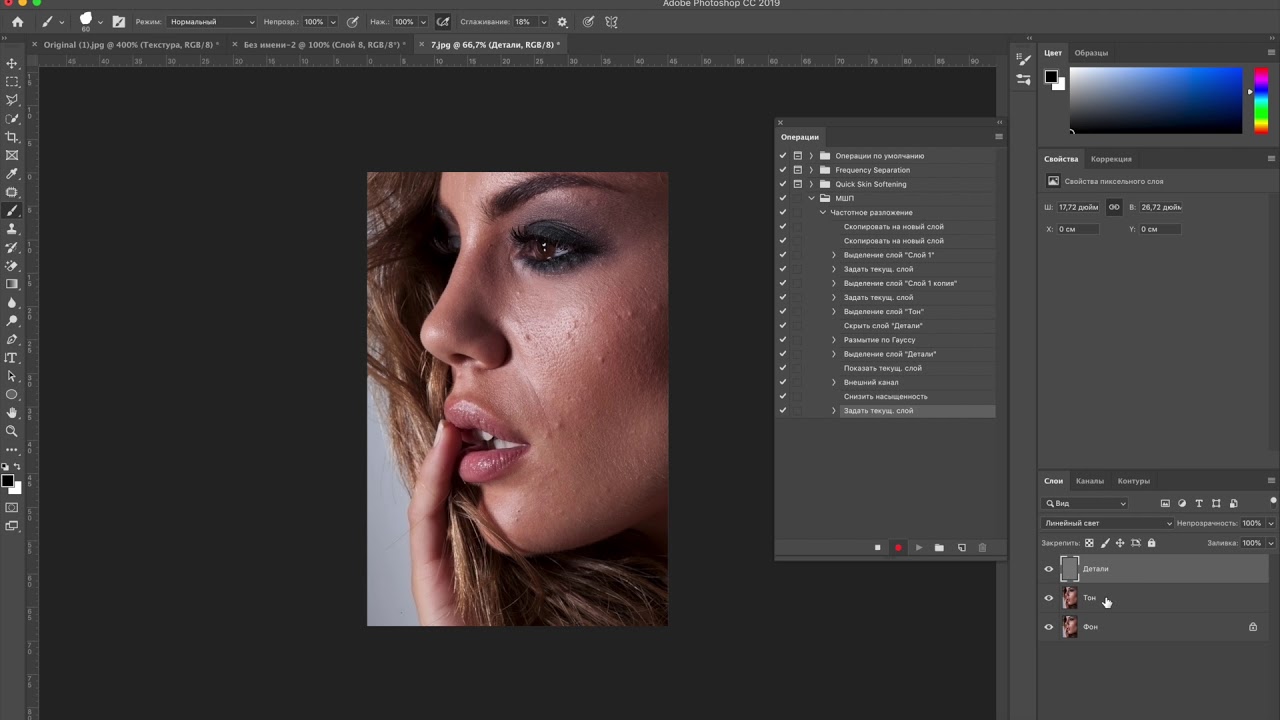

8. Меняем режим наложения слоя High на Линейный свет (Linear light)

10. Мы разложили изображение на две частоты. Теперь можно по отдельности работать с детализацией, цветом и объемом. Я не буду подробно останавливаться на процессе, так как подробнее вы можете узнать об этом, купив запись онлайн мастер-класса «Частотное разложение — просто как 2х2»

11. Если же нам важно наоборот, контролировать, какие дефекты останутся на низкой частоте, то есть, работа с низкой частотой в приоритете, то нужно сначала отключить видимость слоя  Далее все аналогично.

Далее все аналогично.

12. После этого можно создать дополнительные слои для ретуши низкочастотной и высокочастотной составляющих.

Достоинства метода: простота в освоении даже для новичков, возможность временно усилить текстуру для ретуши путем простого отключения корректирующего слоя, снижающего контраст.

Недостатки и ограничения метода: недостаточная гибкость, по сравнению с разложением изображения на три пространственных частоты, опасность появления артефактов на контрастных границах при работе на слое с текстурой, некоторая математическая неточность, обусловленная особенностью математики фильтра Цветовой контраст (подробнее об этом можно почитать здесь). Впрочем, надо отметить, что в 99% случаев этой погрешностью можно пренебречь, так как вы сами при ретуши вносите гораздо более существенные «погрешности», несоизмеримо большие.

Разложение на две частоты с помощью операции вычитания.

Для реализации этого метода нужно выполнить следующее:

1. Сделайте копию фонового слоя или копию видимых слоев, аналогично предыдущему алгоритму.

2. Точно также сделайте две копии, назвав одну Low, а другую High.

3. Отключите видимость слоя High.

4. Подберите радиус размытия для слоя Low, примените фильтр Размытие по Гауссу.

5. Перейдите на слой High. Если вы работаете с глубиной цвета 8 бит, то примените команду Внешний канал (Apply Image), установив следующие параметры – слой

Параметры команды Внешний канал для режима 8 бит

Параметры команды Внешний канал для режима 16 бит

6. Измените режим наложения слоя

Достоинства метода: более аккуратная математика, отсутствие «проблемы High Pass», возможность применения любых фильтров размытия, а не только Размытия по Гауссу. Например, за счет применения фильтра Размытие по поверхности можно полностью решить проблему грязи на контрастных границах, легкость применения при построении «частотных эквалайзеров», то есть, многополосного разложения на пространственные частоты.

Недостатки метода: необходимость дополнительных операций для визуализации высокой частоты. Как выполнить такую визуализацию, я расскажу в конце статьи. Также к недостаткам (скорее к особенностям) метода можно отнести недостаточный контраст слоя  Точно также, метод имеет недостаточную гибкость, по сравнению с разложением на три пространственных частоты.

Точно также, метод имеет недостаточную гибкость, по сравнению с разложением на три пространственных частоты.

Разложение на три полосы частот.

Обеспечивает гораздо большую гибкость в работе, чем двухполосные методы. В частности, на низкой частоте можно полностью сосредоточиться на крупных участках, цвете, светотеневом рисунке, на высокую частоту вынести только необходимую текстуру, а все остальное оставить на промежуточной, средней частоте. В диапазон средних частот попадают такие дефекты как родинки, прыщи, пигментация кожи, веснушки, целлюлит, растяжки и т.д. Ретушируя среднюю полосу частот, мы избавляемся от этих дефектов. Иногда можно встретить рекомендации размывать среднюю полосу или просто вырубать ее черным цветом на маске. Я считаю такой подход несколько некорректным, так как именно ретушь средней полосы частот даст гораздо лучший результат.

Именно метод с разложением на три полосы частот я использую для ретуши фотографий, к которым предъявляются очень высокие требования по качеству постобработки. Подробный процесс ретуши со всеми объяснениями вы сможете найти в обучающем

Подробный процесс ретуши со всеми объяснениями вы сможете найти в обучающем

Как разложить изображение на три пространственных частоты:

1. Делаем базовый слой, как описано выше.

2. Создаем три копии слоя, называя их соответственно Low, Mid и High.

3. Подбираем радиус фильтра Цветовой контраст для слоя High. На этом слое будет только текстура кожи, без излишней информации о локальных объемах и дефектах. Радиус фильтра прописываем в названии слоя.

4. Подбираем радиус фильтра Размытие по Гауссу для слоя Low. Основным критерием здесь является размытие дефектов мелких и средних размеров. Должны остаться только дефекты относительно крупные, такие как следы крупных родимых или пигментных пятен, неровностей светотеневого рисунка. Однако, переусердствовать тоже не следует, иначе средняя частота получится слишком широкой. Как показала практика, оптимальное соотношение между высокой и низкой частотой в большинстве случаев лежит в пределах от 1:3 до 1:4, то есть, радиус размытия в 3-4 раза больше радиуса фильтра Цветовой контраст. Прописываем радиус фильтра в названии слоя.

Как показала практика, оптимальное соотношение между высокой и низкой частотой в большинстве случаев лежит в пределах от 1:3 до 1:4, то есть, радиус размытия в 3-4 раза больше радиуса фильтра Цветовой контраст. Прописываем радиус фильтра в названии слоя.

5. Все, что лежит между этими радиусами, будет вынесено в среднюю полосу частот. Для этого переходим на слой Mid и выполняем вычитание из него слоя Low. Делаем это с помощью команды Внешний канал, аналогично тому, как делали разложение на две частоты. Таким образом мы убиваем двух зайцев: получаем честный математический алгоритм, что критично для довольно больших радиусов, а также имеем возможность использовать на слое НЧ любые фильтры размытия, отличные от гауссова.

6. Размываем слой Mid по Гауссу с радиусом, который использован на слое High для фильтра Цветовой контраст.

7. Меняем режим наложения слоя Mid на Линейный свет.

8. Меняем режим наложения слоя High на Линейный свет. Уменьшаем контраст этого слоя в два раза, аналогично первому методу.

9. Теперь мы сможем работать раздельно с тремя пространственными частотами.

Достоинства метода: больше гибкости в работе, более качественный результат ретуши.

Недостатки метода: те же, что и у метода с разложением на две частоты, требуется больше времени для ретуши, так как приходится работать на трех слоях, вместо двух. Сложность в освоении метода, если нет необходимых базовых знаний Photoshop.

Полосовой фильтр.

Этот метод в зарубежных источниках имеет название Inverted High Pass, однако, по аналогии с электрическими фильтрами, здесь имеет место простое подавление некоторой полосы частот, то есть это аналог режекторного или полосового фильтра.

Полосовой фильтр хорошо использовать для быстрой ретуши, когда требуется с минимальными затратами времени и приемлемым для массовых работ качеством избавиться от дефектов в средней полосе частот.

Алгоритм действий:

1. Делаем копию фонового слоя, называя ее, например, Fast Retouch, то есть Быстрая Ретушь.

2. Размываем данный слой по Гауссу с таким радиусом, чтобы убрать ненужные локальные объемы.

3. Вычитаем из размытого слоя исходный, то есть, в данном случае процесс происходит наоборот, так как в предыдущих методах мы вычитали из исходного слоя как раз размытый. Делаем это с помощью команды Внешний канал.

4. Изменяем режим наложения слоя Fast Retouch на Линейный свет. Мы должны увидеть размытую картинку.

5. Теперь снова размываем данный слой по Гауссу, только теперь с радиусом в 2-4 раза меньшим, проявляя мелкую текстуру кожи. Мы получим изображение, которое выглядит несколько необычно.

Мы получим изображение, которое выглядит несколько необычно.

6. Прячем данный слой в черную маску и белой кистью проявляем его в нужных местах. При этом избегайте работы вблизи контрастных границ, так как получите грязь на этих местах.

Впрочем, проблему грязи на контрастных границах довольно легко решить. Уже догадались как?

Правильно! Использовать для размытия фильтр, оставляющий четкие границы, например, Размытие по поверхности.

Достоинства метода: простота и эффективность, быстрота в применении для массовой обработки. В отличие от плагинов, более контролируемый результат.

Недостатки метода: отсутствие какой-либо гибкости в работе, невозможно получить результат высокого качества.

Многополосное разложение или «эквалайзер».

Для упрощения процесса ретуши можно модифицировать предыдущий метод, раскладывая изображение на несколько пространственных частот, с использованием различных радиусов для размытия изображения. Таким образом мы получим возможность, работая по маске слоя, быстро убирать дефекты различных размеров.

Таким образом мы получим возможность, работая по маске слоя, быстро убирать дефекты различных размеров.

Алгоритм создания эквалайзера:

1. Определяемся со значениями радиусов, которые будем использовать. Обычно используются значения 5, 10, 15, 25, 40 пикселей, но вы можете выбирать любые, которые вам подходят.

2. Создаем базовый слой, как в предыдущих методах.

3. Создаем необходимое количество копий, по числу радиусов плюс один слой. В данном случае шесть копий базового слоя.

4. Называем копии осмысленно, например, по диапазонам радиусов, то есть, 40, 40-25, 25-15, 15-10, 10-5, 5.

5. Отключаем все слои выше слоя 40. Размываем этот слой по Гауссу с радиусом 40 пикселей

6. Включаем вышележащий слой 40-25, переходим на него и выполняем вычитание слоя 40 с помощью команды Внешний канал.

7. Размываем данный слой по Гауссу с радиусом 25 пикселей. Получаем полосу частот от 40 до 25 пикселей.

Получаем полосу частот от 40 до 25 пикселей.

8. Меняем режим наложения на Линейный свет.

9. Переходим на слой 25-15 и, ВНИМАНИЕ! Не включаем видимость слоя!

10. Выполняем вычитание из данного слоя содержимого всех слоев. То есть, в настройках команды Внешний канал в качестве источника нужно поставить Объединено. Таким образом мы вычтем из данного слоя изображение, размытое на 25 пикселей.

11. Теперь включаем видимость слоя 25-15 и меняем режим наложения на Линейный свет.

12. Размываем слой 25-15 на 15 пикселей.

13. Повторяем операции с другими слоями. Последний слой, с названием 5, не размываем, так как на нем будет находиться текстура с размерами элементов до 5 пикселей.

14. Таким образом, мы получаем эквалайзер пространственных частот. Теперь мы можем как ослаблять нужный диапазон частот, так и усиливать его. Ослабление производится путем наложения маски слоя и рисования по нужным местам черной кистью с необходимой непрозрачностью. Усиление производится с помощью корректирующего слоя, например, Кривые, действующего через обтравочную маску на конкретный слой. Поднимая контраст простым поворотом кривой против часовой стрелки, мы усиливаем контраст слоя, тем самым усиливая видимость данной полосы частот.

Ослабление производится путем наложения маски слоя и рисования по нужным местам черной кистью с необходимой непрозрачностью. Усиление производится с помощью корректирующего слоя, например, Кривые, действующего через обтравочную маску на конкретный слой. Поднимая контраст простым поворотом кривой против часовой стрелки, мы усиливаем контраст слоя, тем самым усиливая видимость данной полосы частот.

Достоинства метода: возможность быстрого подавления или усиления в выбранных полосах частот, таким образом можно значительно ускорить процесс ретуши.

Недостатки метода: сложность в реализации для начинающих, накопление ошибок округления из-за большого количества слоев, при работе вблизи контрастных границ те же проблемы с грязью из-за ореолов размытия.

Частотное разложение без потерь.

Все предыдущие способы разложения изображения на пространственные частоты имеют общий недостаток (хотя это скорее особенность), возникающий из-за целочисленной арифметики Photoshop, то есть, из-за округления чисел до целых при расчете. В результате, например, 5 разделить на 2 будет равно уже не 2.5, а 3.

В результате, например, 5 разделить на 2 будет равно уже не 2.5, а 3.

Поэтому, если вынести изображение, получаемое частотным разложением, на отдельный слой и сравнить его с исходником, наложив в режиме Разница (Difference) и сильно подняв контраст, мы увидим, что изображения имеют небольшое отличие друг от друга.

Как правило, это отличие не превышает один-два тоновых уровня. Те изменения, которые вносятся впоследствии в картинку при ретуши, несоизмеримо больше. Поэтому не следует обращать на это внимания.

Однако, если для вас все же критична даже такая микроскопическая разница, можете воспользоваться способом честного частотного разложения, без потерь.

Для режима 8 бит алгоритм будет следующий:

1. Создаем базовый слой. Делаем три копии базового слоя.

2. Называем первый слой Low, следующий High_Dark, и верхний High_Light.

3. Отключаем видимость слоев High_Light и High_Dark.

4. Размываем слой Low с необходимым радиусом. При этом можно использовать любые фильтры размытия.

5. Включаем слой High_Dark. Переходим на него. Применяем команду Внешний канал со следующими настройками: источник слой Low, канал RGB, инвертировать, режим наложения Линейный осветлитель (Linear Dodge).

6. Меняем режим наложения слоя High_Dark на Линейный затемнитель (Linear Burn).

7. Включаем слой High_Light и переходим на него. Применяем команду Внешний канал со следующими настройками: источник слой Low, канал RGB, инвертировать, режим наложения Линейный затемнитель.

8. Меняем режим наложения слоя High_Light на Линейный осветлитель.

Если вынести разложенную картинку на отдельный слой с помощью комбинации клавиш CTRL+ALT+SHIFT+E, то при наложении ее на исходную в режиме Разница, с предельно усиленным контрастом, мы ничего не увидим. То есть, метод обеспечивает математически точное частотное разложение. К сожалению, в режиме 16 бит данный метод имеет видимую погрешность. Для 16 бит используется несколько другой алгоритм, который также дает погрешность, но уже на уровне единичных пикселей, что абсолютно некритично.

9. Таким образом, мы получаем два слоя для текстуры – один High_Light со светлой составляющей на черном фоне и второй High_Dark с темной составляющей на белом фоне. Ретушь текстуры в данном случае придется производить в два этапа, сначала одну составляющую, затем другую.

Достоинства метода: математически точное частотное разложение, без погрешностей.

Недостатки метода: необходимость ретуши высокочастотной составляющей в два этапа.

Алгоритм визуализации высокочастотной составляющей.

При работе с фильтрами размытия, такими как Размытие по поверхности (Surface Blur) или Медиана (Median) имеется определенная проблема. Заключается она в том, что довольно часто хочется реализовать видимость высокочастотной составляющей, как будто мы применяем фильтр Цветовой контраст. Это необходимо для того, чтобы иметь возможность контролировать, какая текстура будет впоследствии вынесена на высокочастотный слой.

Для визуализации высокочастотной составляющей я предложил следующий метод, который основан на знании математики режимов наложения и особенностей работы фильтров в Photoshop. Теперь этот метод используют многие ретушеры и преподаватели в различных онлайн и оффлайн школах, обучающих обработке изображений.

Алгоритм визуализации следующий:

1. Создаем базовый слой. Делаем две копии, называем одну Low, другую High. Слой High отключаем.

2. Копируем слой Low, называем копию Temp, что означает временный.

3. Слой Temp инвертируем и устанавливаем непрозрачность 50%. Получаем 50% серый.

4. Теперь над слоем Temp создаем временный корректирующий слой Инверсия (Invert).

5. Для дополнительного усиления контраста, чтобы лучше видеть текстуру, желательно создать еще один временный корректирующий слой Кривые, закрутив кривую RGB против часовой стрелки вокруг центральной точки.

6. Теперь, если мы будем размывать каким-либо фильтром слой Low, мы увидим серую картинку с текстурой, как будто мы применяем фильтр Цветовой контраст. В данном случае я применил фильтр Медиана

В данном случае я применил фильтр Медиана

7. Подобрав таким образом параметры фильтра, применяем его, удаляем все временные слои.

8. Затем включаем слой High и получаем высокочастотную составляющую путем вычитания с помощью команды Внешний канал.

Надеюсь, что данный сборник рецептов поможет вам лучше разобраться в использовании метода частотного разложения для ретуши в различных его вариациях.

Более подробно о самых современных методиках быстрой ретуши вы можете узнать из записи онлайн-мастер-класса «Частотное разложение 2.0. Эксклюзивные методики быстрой ретуши» (предупреждаю, что материал там не для начинающих).

А для тех, кто делает только первые шаги в ретуши, рекомендую запись моего трехдневного онлайн-марафона по ретуши «Сделай первые шаги в ретуши портретов»

По всем вариантам частотного разложения вы можете записать экшены и использовать их в своей работе. Пусть это будет вашим домашним заданием.

Пусть это будет вашим домашним заданием.

Автор: Евгений Карташов

Частотное разложение. ULTIMATE | Виртуальная школа Profile

Частотное разложение. ULTIMATE

Цикл завершен. Начавшаяся 4 года назад история подошла к логическому концу. Я не изобретал этот прием, мне просто удалось вытащить его из узкого кулуарного круга «крутых профи» и запустить в широкие массы. Само название «частотка» — яркое тому доказательство. Огромное спасибо Александру Миловскому за подсказку, позволившую мне открыть Америку через форточку (так мой дед называл изобретение для себя лично чего-либо уже известного окружающим). Именно из его статьи шагнул в массы термин «частотное разложение».

1. ТЕОРИЯ

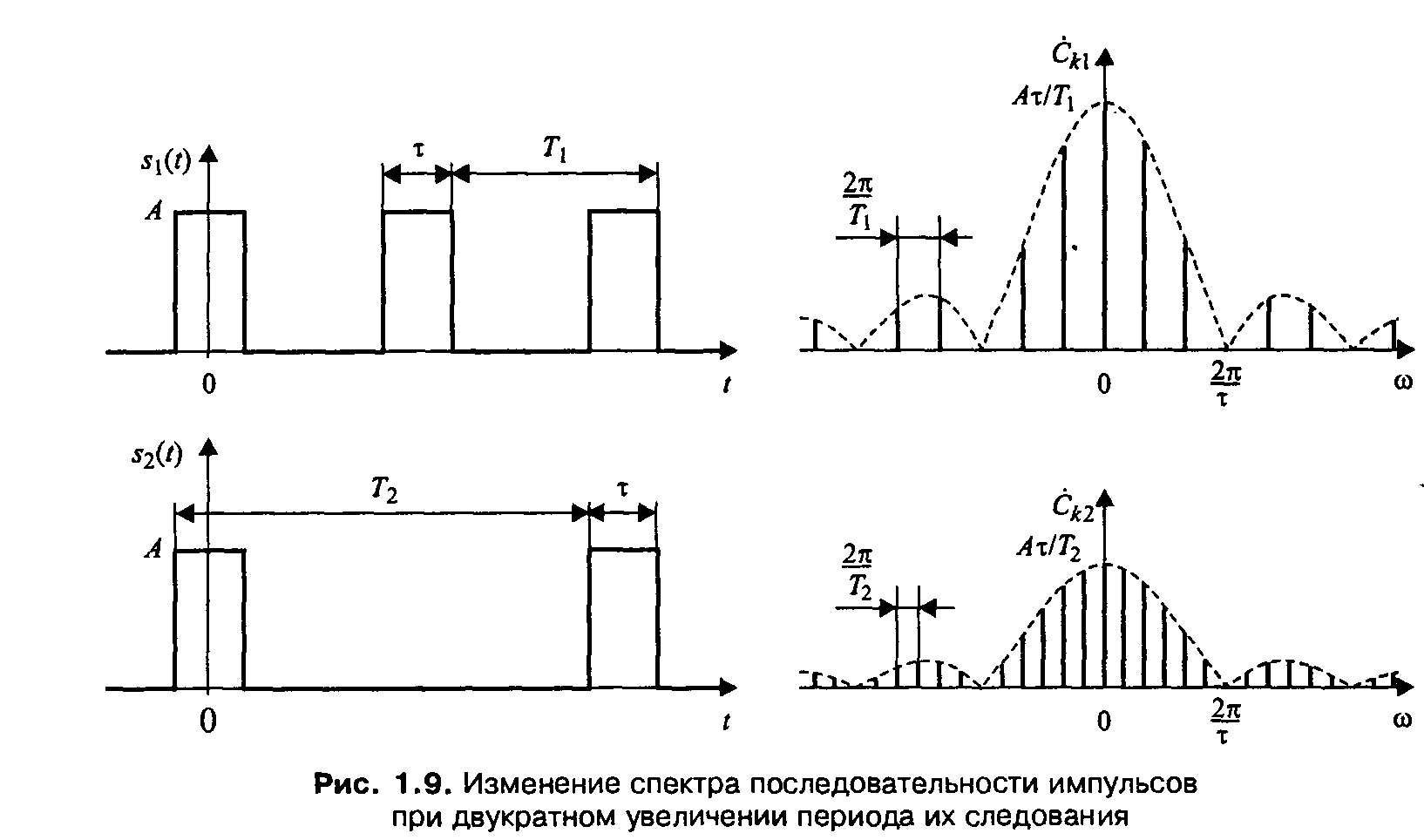

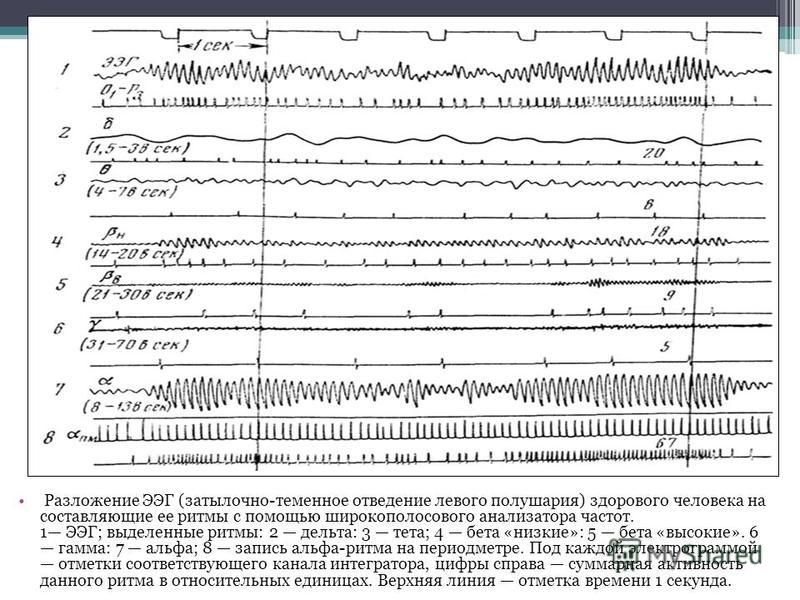

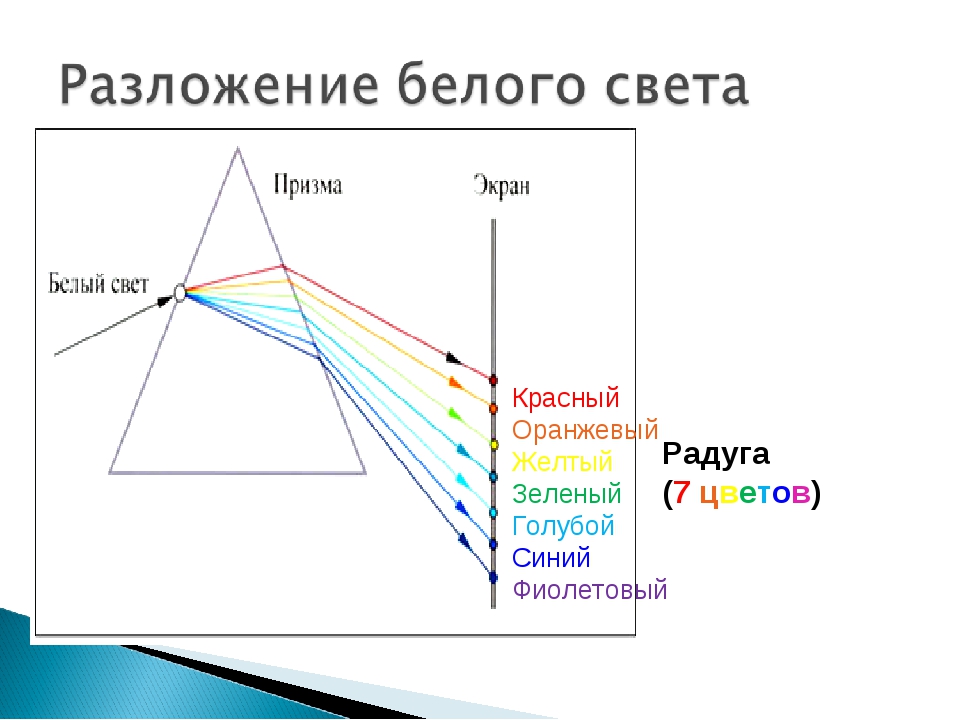

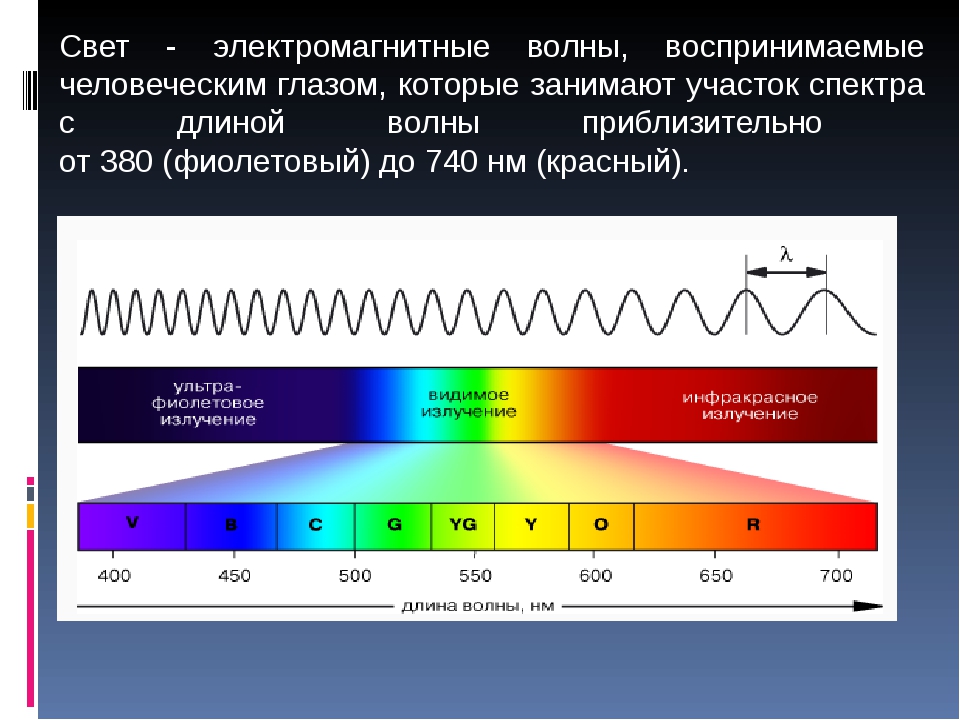

Разложение в спектр.

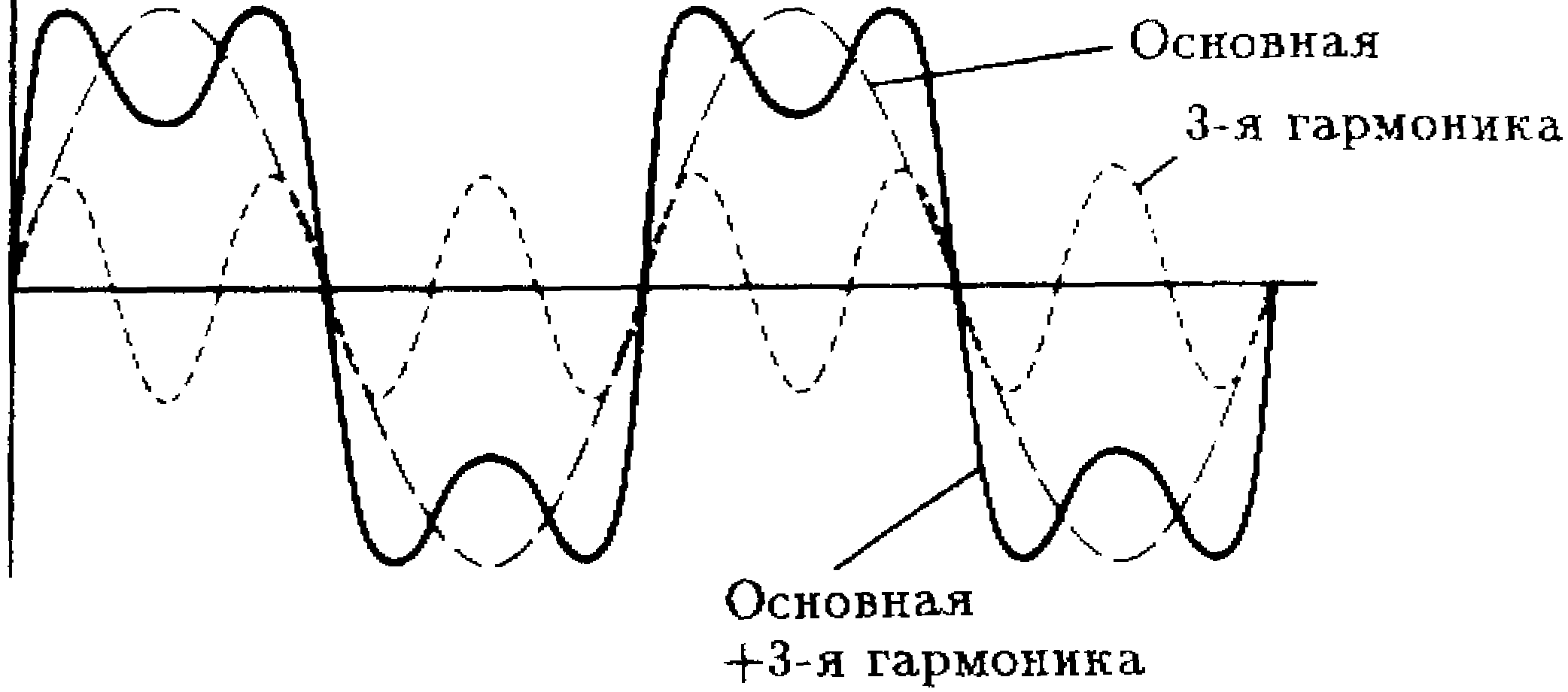

В 1807 году Жан Батист Жозеф Фурье подготовил доклад «О распространении тепла в твёрдом теле», в котором использовал разложение функции в тригонометрический ряд

При таком преобразовании функция представляется в виде суммы синусоидальных колебаний (гармоник) с различной амплитудой

Любой сигнал может быть представлен в таком виде, а все образующие его гармоники вместе называются спектром

В 1933 году Владимир Александрович Котельников сформулировал и доказал теорему, согласно которой любой сигнал с конечным спектром может быть без потерь восстановлен после оцифровки, при условии, что частота дискретезации будет как минимум в два раза выше частоты верхней гармоники сигнала

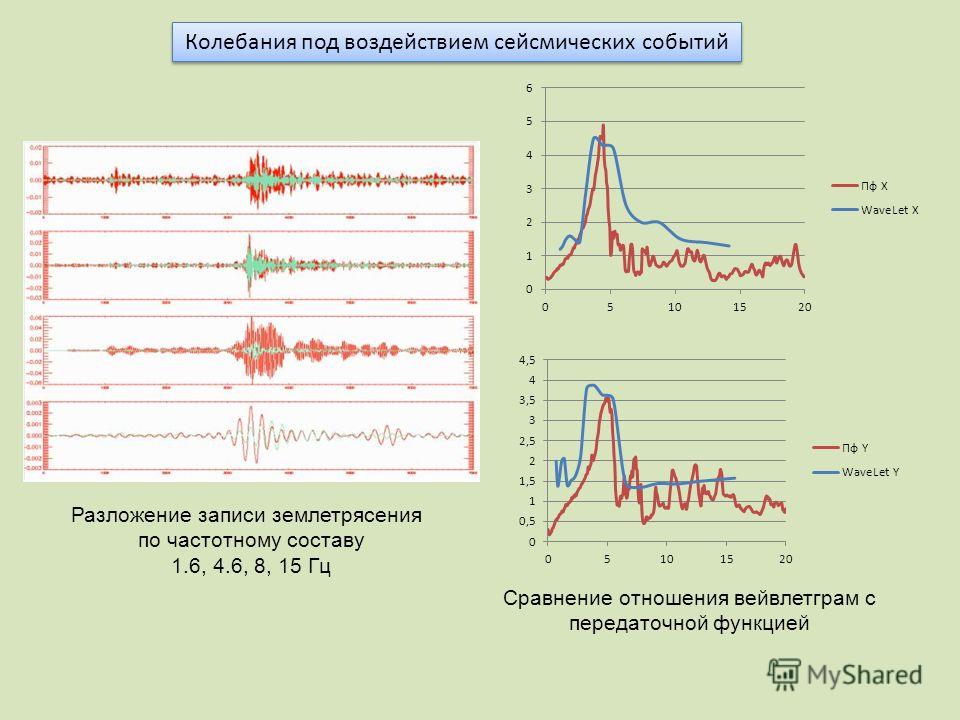

Что такое пространственные частоты.

Частота с которой меняется яркость при перемещении по горизонтали или вертикали

Изображение — это двумерный сигнал (яркость меняется при перемещении по горизонтали и вертикали), поэтому общая решетка образуется из двух решеток различных ориентаций — горизонтальной и вертикальной

Чем выше частота, тем быстрее меняется яркость, тем мельче детали которые она задает

Самые мелкие детали — это перепады яркости на контрастных контурах

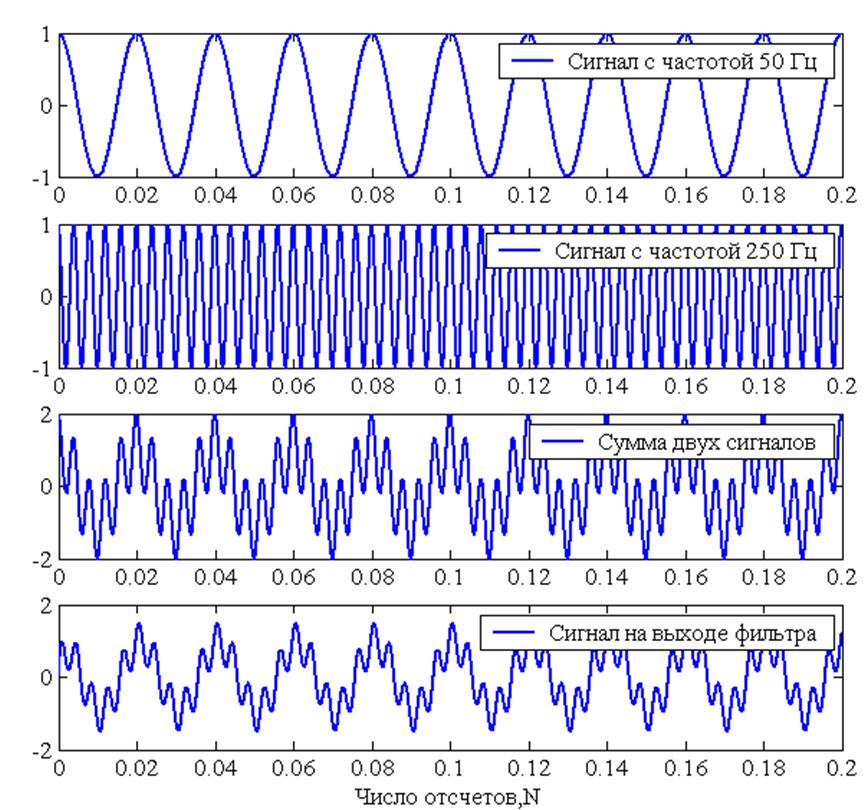

Разложение на полосы частот.

Для эффективной обработки сигнала нет необходимости раскладывать его в спектр, достаточно разложить его на несколько полос, содержащих все гармоники ниже или выше определеной частоты

Самые низкие частоты задают общее распределение яркости и, как следствие, цвета

Средние частоты уточняют эту картинку принося основные объемы объектов

Верхние частоты добавляют самую мелкую детализацию — фактуру поверхностей

Дополнительные материалы:

Алексей Шадрин. «Управление визуальным объемом изображений»Александр Миловский. «Муар нам только снится»

«Муар нам только снится»2. ПРОСТОЕ РАЗЛОЖЕНИЕ НА 2 ПОЛОСЫ ЧАСТОТ

Фильтры нижних и верхних частот.

Gaussian Blur — фильтр нижних пространственных частот

Чем больше Raduis, тем более крупные детали убираются, тем ниже оставшиеся частоты

High Pass — фильтр верхних пространственных частот, дополнительный к Gaussian Blur

High Pass показывает детали, которые убрал Gaussian Blur при том же значении Radius

Эти детали отображаются в виде отклонения от средне-серого цвета (отклонения от средней яркости в каждом канале)

Сложение исходного изображение из частотных полос.

Добавить эти отклонения к исходному изображению может режим Linear Light

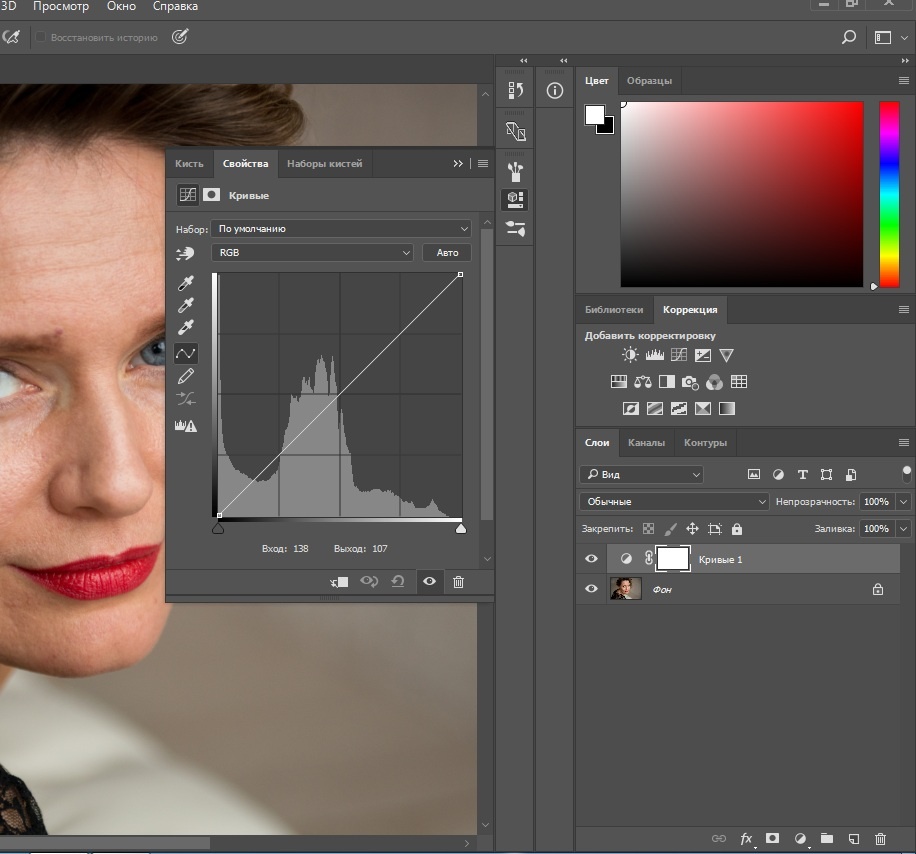

Контраст ВЧ-слоя надо понизить в два раза вокруг средней яркости (тон 128), чтобы скомпенсировать заложенное в Linear Light удвоение

Это можно сделать при помощи кривых (Curves) подняв черную точку в позицию (0; 64) и опустив белую в позицию (255; 192)

Можно понизить контраст при помощи Brightness/Contrast с установкой Contrast -50 и активированным ключем Use Legacy

Вместо понижения контраста можно уменьшить до 50% непрозрачность слоя, но в этом случае регулятор Opasityиспользовать нельзя, а нужно воспользоваться регулятором Fill

Дополнительные материалы:

Андрей Журавлев. «Ретушь портрета на основе частотного разложения»3. DODGE & BURN

Идеология Dodge & Burn.

Основная идея этой техники: ручное осветление излишне темных и затемнение слишком светлых участков для придания объекту более гладкой и правильной формы

Таким же образом усиливаются или дорисовываются недостающие объемы

Классически реализуется при помощи инструментов Dodge Tool и Burn Tool, но эти инструменты допускают только деструктивную обработку

Может быть реализована при помощи режимов наложения или корректирующих кривых с рисованием по макске слоя

Реализация Dodge & Burn при помощи режимов наложения.

Для сильной перерисовки свето-теневого рисунка используются режимы наложения Multiply и Screen

Рисование производится на пустых или залятых нейтральными для данных режимов цветом слоях

Основным преимуществом такой работы является большая сила воздействия: Multiply способен затемнять даже белый объект, а Screen осветлять даже черный

Дополнительным плюсом является возможность работать разным цветом на одном слое и простота выбора цвета: его можно брать с самого изображения

Минусом (особенно для начинающих) является уже упомянутая сила воздействия, заставляющая точно контролировать свои движения

Для легкой финальной правки применяют слой в режиме Soft Light (прозрачный или залитый средне-серым)

Плюсами являются: мягкость и визуальная однородность воздействия; ограниченный диапазон воздейстывий; отсутствие воздействия на белые и черные участки

Реализация Dodge & Burn при помощи кривых.

Затемнение и осветление производится при помощи корректирующих слоев кривых (Curves), а необходимые участки прорисовываются по их маскам

При затемнении происходит повышение, а при осветлении понижение, насыщенности изображения. Для их компенсации к каждому слою кривых через маску вырезания (Create Clipping Mask) добавляется слой Hue/Saturation

К плюсам метода можно отнести большую (по сравнению с использованием режимов наложения) гибкость последующих настроек

Минусом является невозможность вносить разные оттенки цвета при помощи одного корректирующего слоя

Для самостоятельного изучения:

Алиса Еронтьева и Дмитрий Никифоров. «Портретная ретушь»4. ИНСТРУМЕНТЫ ИХ НАСТРОЙКИ

Почему выгодно править частотные полосы по отдельности.

При ретуши необходимо согласовывать цвет и его переходы с одной стороны и фактуру поверхности с другой

При исправлении формы крупных объектов выгодно использовать пониженную непрозрачность

Для сохранения мелких объектов (фактура поверхности) необходимо использовать 100% непрозрачность

Мягкая граница кисти у штампа — вынужденный компромисс между этими двумя требованиями

Жесткий стык между однородными однотипными фактурами заметен не будет

Выбор радиуса при разложении на две полосы частот.

Для Gaussian Blur выгодно задавать большой радиус, чтобы максимально убрать фактуру

Для High Pass выгодно задавать малый радиус, чтобы не пропустить объемы

Конкретное значение выбирается как компромиссный вариант между этими двумя условиями

При этом учитывается детали какой крупности мы относим к фактуре

Визуализация при выборе радиуса разложения.

Радиус Gaussian Blur удобнее подбирать плавно увеличивая его, пока не исчезнут ненужные детали

Радиус High Pass удобнее подбирать плавно уменьшая его, пока не пропадут ненужные объемы

Если более важной является форма, радиус удобнее подбирать ориентируясь на содержимое НЧ (размытая картинка)

Если более важной является фактура поверхности, радиус удобнее подбирать ориентируясь на содержимое ВЧ («хайпасная» картинка)

Зависимость радиусов от размера лица и крупности дефектов.

Пропорции среднего лица (ширина к высоте) составляют примерно один к полутора

При вычислении радиусов удобнее отталкиваться от высоты лица, так как она меньше зависит от ракурса съемки

Для удаления аккуратной фактуры кожи необходимо взять значение Radius порядка 1/280 — 1/250 от высоты лица

Для удаления мелких дефектов (прыщи, морщины и т.п.) необходимо взять значение Radius порядка 1/100 — 1/120 от высоты лица

Для удаления крупных дефектов (подглазины, шрамы и т.п.) необходимо взять значение Radius порядка 1/50 — 1/60 от высоты лица

5. РЕТУШЬ ПРИ РАЗЛОЖЕНИИ НА 2 ПОЛОСЫ ЧАСТОТ

Ретушь НЧ-составляющей — исправление формы.

Находящуюся на НЧ слое форму удобно ретушировать при помощи инструментов Clone Stamp, Brush и Mixer Brush

Штампом работаем с мягкой кистью и пониженной непрозрачностью

Можно работать на новом прозрачном слое с настройкой штампа Sample: Current & Below

При этом на экран можно вывести общий вид картинки, а не только НЧ слоя.

Кисть (Brush Tool) удобно использовать для закрашивания локальных дефектов (пробойные блики, проваальные тени и т.п.) телесным цветом

Mixer Brush используется для быстрого разглаживания лишних объемов

Ретушь ВЧ-составляющей исправление фактуры.

Работаем штампом с жесткой кистью и 100% непрозрачностью

Можно работать на новом прозрачном слое с настройкой штампа Sample: Current & Below и отображением только ВЧ слоя

Чтобы ретушировать глядя на финальную картинку надо работать на самом ВЧ слое (его копии) с настройкой штампа Sample: Current Layer

Чтобы иметь возможность откатиться к исходному состоянию ретушь проводят на копии слоя ВЧ с применением к нему команды Create Clipping Mask

Для лучшего контроля над деталями можно временно включить корректирующий слой кривых, повышающий контраст ВЧ составляющей

При отсутствии на изображении необходимой текстуры можно перенести ее с другой фотографии

Как работает Healing Brush.

На НЧ слое после размытия на участках рядом с контрастной границей появляется цвет соседней области

На ВЧ слое вдоль контрастных границ появляются ореолы противоположных цветов

Если в процессе ретуши ВЧ слоя убрать ореол на финальной картинке на этом участке появится цвет соседней области

Healing Brush переносит фактуру с донорской области, подгоняя цвет и яркость под ретушируемого участка под цвет и яркость его окрестностей

Его работа построена на алгоритме частотного разложения, а значение радиуса привязано к размер кисти

6. ОТДЕЛЬНЫЕ ПРИЕМЫ РЕТУШИ

Как побрить человека.

Вынести волоски (щетину) на ВЧ слой и заменить их фактурой чистой кожи

Если щетина была темная, поправить цвет на НЧ слое

Внимательно следите за фактурой, она сильно отличается на разных участках лица

«Брить» мужчину тяжело, поскольку на лице не хватает нужной фактуры

При необходимости нужную фактуру кожи можно взять с другой фотографии

Борьба с пробойными бликами. Ретушь НЧ.

Изображение раскладывается на две полосы с установками обеспечивающими полный переход фактуры кожи на ВЧ слой

На НЧ слое участки пробойных бликов закрашиваются цветом кожи

При необходимости на них наносится свето-теневой рисунок передающий объем объекта

Борьба с пробойными бликами. Ретушь ВЧ.

Если блик пробойный и вообще не содержал фактуры, она переносится с целых участков кожи

Если блик близок к пробойному и фактура кожи все-таки содержится, после ретуши НЧ она визуально усилится

Чтобы смягчить этот эффект можно наложить на нее фактуру с более гладких участков на отдельном слое с пониженной непрозрачностью

7. «ЧЕСТНОЕ» РАЗЛОЖЕНИЕ НА 2 ПОЛОСЫ ЧАСТОТ

Ошибка High Pass.

Максимальный диапазон разностей яркости от -256 (вычитаем белый из черного) до 256 (вычитаем черный из белого) составляет 512 тоновых уровней

Максимально возможные отклонения от средней яркости от -128 (затемнение) до 127 (осветление)

При наличии мелких деталей на массивном фоне отличающихся по яркости более чем на 128 уровней High Pass ошибается

Обычно это случается на точечных бликах расположенных на темном объекте

Чем больше радиус размытия, тем больше сама ошибка и вероятность ее появления.

На практике, при малых радиусах разница является «гомеопатической» и рассматривать ее как реальную проблему можно только с академической точки зрения

При больших радиусах ошибка составляет реальную проблему, поскольку «гасит» мелкие блики

Создание ВЧ составляющей вычитанием НЧ из оригинала.

Альтернативой High Pass является наложение на исходное изображение размытой версии при помощи команды Apply Image в режиме Subtract с установками Scale:2 Offset:128

В поле Offset (смещение) задается значение яркости вокруг которого будет откладываться результат вычитания

В поле Scale устанавливается во сколько раз будет уменьшаться результат вычитания перед добавлением к значению Offset

Диапазон установок Scale от 1 до 2, то есть контраст можно понизить максимум в 2 раза

Применять корректирующий слой понижающий контраст в этом случае не нужно, поскольку он уже понижен установкой Scale:2

Особенности разложения 16-битных изображений.

При вычислении ВЧ через команду Subtract у 16-битных изображений появляется ошибка величиной в 1 восьмибитный (128 шестнадцатибитных) уровень

Вероятно, это связано с тем, что реально вычисления происходят в пятнадцатибитном виде

Чтобы избежать этой ошибки при работе в 16-битном режиме вместо команды Subtract используют команду Add с активированным ключом Invert и установками Scale:2 Offset:0

Использование Surface Blur для получения НЧ составляющей.

В случае применения для получения НЧ составляющей Gaussian Blur вдоль контрастных границ создаются сильные ореолы

Ретушь в области ореолов может привести к «затягиванию» на объект цвета соседнего фона

Проблема проявляется тем более сильно, чем больше радиус размытия, поскольку в этом случае ореолы становятся более массивными и плотными

Чтобы избежать такой проблемы НЧ составляющую можно создавать при помощи фильтра Surface Blur

Границы, имеющие перепад яркости больше уровня установленного регулятором Threshold, не размываются

На практике удобнее всего подобрать значение Radius при установленном на максимум Threshold, а потом уменьшать значение Threshold до восстановления контрастных границ

8. АВТОМАТИЗАЦИЯ ПРОЦЕССА

Запись универсального экшена для разложения на 2 полосы частот.

Все операции выполняются со слоями, созданными самим экшеном

Слой создается командой Layer > New Layer и сразу переименовывается

Текущее изображение помещается на него при помощи команды Image > Apply Image с установкой Layer: Merged

Переключения между слоями выполняются при помощи шоткатов «Alt»+«[» и «Alt»+«]»

Для возможности переключения вместо отключения видимости слоя его непрозрачность уменьшается до нуля

При необходимости перемещение слоев выполняются командами Layer > Arange

В качестве подсказки перед применением Gaussian Blur в экшен вставляется команда Stop с комментариями по подбору радиуса

При регулярном применении Stop можно деактивировать или удалить

Преимущества «честного» разложения при работе с экшенами.

При записи экшена количество стандартных операций не является критичным

При этом важно минимизировать количество операций, требующих участия пользователя

Вычисление ВЧ составляющей через наложение НЧ на копию исходного слоя избавляет пользователя от задания радиуса для фильтра High Pass

Дополнительным плюсом такого метода является возможность применить для размытия не Gaussian Blur, а какой-нибудь другой фильтр

Создание набора экшенов для разложения на 2 полосы.

Сделать набор экшенов с жестко заданными значениями радиуса можно на основе универсального экшена

Для этого нужно убрать команду Stop, отключить диалоговое окно в Gaussian Blur и настроить его радиус на требуемый

Для удобства последующей работы с файлом к названиям слоев Low и High можно сразу добавить приписку со значением радиуса размытия

Экшен для пакетной обработки с настройкой по первому кадру.

При обработке серии фотографий с одинаковой крупностью объектов было бы удобно один раз вручную подобрать нужный радиус разложения, а потом применять его ко всей серии

Это можно сделать, если вместо прямого вызова конкретного фильтра вписать в экшен команду вызова последнего использовавшегося фильтра

Теперь достаточно один раз вызвать нужный фильтр (в рамках стандартного экшена или отдельно), настроить его параметры и он будет применяться при всех следующих запусках экшена

9. РАЗЛОЖЕНИЕ НА 3 ПОЛОСЫ ЧАСТОТ

Зачем раскладывают картинку на три полосы.

Чаще всего задача такого разложения — вынести все дефекты в среднюю полосу частот

Таким образом можно бороться с объектами определенного типоразмера, например веснушками

Кроме того, в средних частотах находится большинство «старящих» элементов: глубина морщин, жилистость, вены, провисания, мешки под глазами и т.п.

Реже ретушируются все три полосы, в этом случае процесс аналогичен разделению на 2 полосы, но позволяет проще работать объектами разного типоразмера

Как это сделать.

Для НЧ увеличиваем радиус Gaussian Blur пока не останется чистая форма

Для ВЧ уменьшаем радиус High Pass пока не останется чистая фактура

Создаем между нами слой средних частот применив к нему сначала High Pass с радиусом который использовался для создания НЧ, а потом Gaussian Blur с радиусом который использовался для создания ВЧ

Универсальное правило: High Pass следующего слоя имеет такой же радиус, как Gaussian Blur предыдущего

Теперь можно ретушировать средние частоты не обращая внимание не только на фактуру, но и на разницу цвета исходной и ретушируемой области

При «честном» разложении средние частоты получаются вычитанием из исходного изображения низких и высоких

Автоматизация разложение на три полосы.

Для создания ВЧ удобно использовать High Pass, поскольку он позволяет более наглядно подобрать радиус

В процессе подбора уменьшаем радиус High Pass пока на ВЧ не останется чистая фактура

Вместо High Pass можно использовать Gaussian Blur с визуализацией ВЧ составляющей

Слой средних частот можно получить вычитая из исходного изображения верхние и нижние частоты

10. УПРОЩЕННЫЙ МЕТОД РЕТУШИ СРЕДНИХ ЧАСТОТ (INVERTED HIGH PASS)

Почему можно упростить ретушь средних частот.

Ретушируя средние частоты мы прежде всего убираем лежащие в них излишние локальные объемы

Это можно сделать проще, не раскладывая изображение на три полосы, а выделить среднюю и вычесть ее из исходника

Вычитание должно быть локальным: только на участках где присутствует лишний объем, пропорционально степени его подавления

Как это сделать.

Подбирать радиус для High Pass удобнее через Gaussian Blur (через НЧ составляющую) и наоборот

Делаем копию исходного слоя

Вызываем Gaussian Blur, плавно увеличиваем радиус пока не исчезнут ненужные детали, запоминаем его значение и нажимаем Cansel

Вызываем High Pass, плавно уменьшаем радиус пока не пропадут ненужные объемы, запоминаем его значение и вводим радиус подобранный на предыдущем шаге

Применяем Gaussian Blur с радиусом подобранным на предыдущем шаге

Инвертируем изображение

В два раза понижаем контраст вокруг средней точки

Переключаем режим наложения на Linear Light

На слой вычитающий средние частоты из исходного изображения набрасываем черную маску

Белой кистью по маске прорисовываем те участки, на которых нужно подавить крупные детали

Автоматизация процесса.

Все рутинные операции записываются в экшен

Полоса средних частот получается вычитанием из исходного изображения НЧ и ВЧ полос с подобранными пользователем радиусами

За счет этого визуализация оказывается наиболее комфортной

Подбор верхнего радиуса можно делать после наложения на исходное изображение инвертированной СЧ+ВЧ составляющей. В этом случае используется Gaussian Blur и на размытой картинке начинает проступать чистая фактура

Чем приходится расплачиваться за скорость.

Результат ручной ретуши выглядите естественно прежде всего из-за сохранения мелких неоднородностей

За скорость и простоту приходится расплачиваться механистически правильной формой объектов, что визуально удешевляет работу

Соотношение радиусов обычно выбирают 1:3 или меньше, иначе результат будет выглядеть слишком неестественным

Для более тонкой работы соотношение радиусов берут примерно 1:2 и производят несколько циклов разложения с разными значениями вилки

При ретуши второстепенных участков можно брать соотношение 1:4 и даже больше

Для самостоятельного изучения:

Евгений Карташов. «Рецепты частотного разложения»11. ЧАСТОТНОЕ РАЗЛОЖЕНИЕ И ДРУГИЕ ИНСТРУМЕНТЫ PHOTOSHOP

Средние частоты и Clarity.

Алгоритм работы Clarity строится на усилении (ослаблении) средних пространственных частот

При этом работа идет только по яркостной составляющей изображения

Повышение и ослабление Clarity не симметрично

Инструмент использует интеллектуальное размытие с сохранением контрастных контуров напоминающее Surface Blur, но не совпадающее с ним

При умеренных значениях можно рекомедовать использование Clarity в конвертере, при условии, что в дальнейшем изображение не будет подвергаться «сильной» обработке

Высокие частоты и повышение резкости.

Искусственное повышение резкости есть ни что иное, как усиление самых верхних из содержащихся в изображении частот.

При подготовке пейзажей основной проблемой является замыливание (исчезновение) сверх мелкой детализации (трава) вследствии нехватки разрешения.

Аналогичная проблема встает при подготовке изображений с мелкими деталями для размещения в интернете

Создать визуально ощущение наличия сверх мелких деталей можно добавив в изображение мелкий шум, согласованный с его элементами

Для этого повышаем резкость классическим способом, но оставляем это повышение только на низко контрастных областях

Проще всего это сделать используя Surface Blur в качестве фильтра, создающего нерезкую маску

12. В ЗАВЕРШЕНИИ РАЗГОВОРА

Для чего еще можно применять частотное разложение

Частотное разложение — это универсальный метод применимый к любому жанру фотографии

Убирать складки на ткани или других материалах

С его помощью можно смягчать слишком жесткие тени

Избавляться от разводов оставшихся после общей ретуши

Решать любые задачи, требующие различной работы с общей формой и мелкими деталями

Почему после частотного разложения картинка выглядит плохо?

Ретушь — это процесс не поддающийся автоматизации

Частотное разложение не делает ретушь за вас, оно лишь упрощает решение некоторых проблем

Увлекшись возможностью решить все «несколькими размашистыми мазками», при использовании частотного разложения ретушеры нередко позволяют себе работать халтурно

Будьте честны перед собой, не сваливайте собственные ошибки и халтуру на «плохую методику»

Чтобы избежать такой ловушки можно разделить процесс на два этапа

При помощи частотного разложения быстро поправить форму и разобраться с сильными огрехами фактуры (пробойные блики, грубая фактура и т.п.)

Последующую доработку производить при помощи привычных реализаций Dodge & Burn, чтобы обеспечить остаточную неоднородность и естественность изображения

Для самостоятельного изучения:

ModelMayhem.com — RAW! Beauty Robot.Сергей Брежнев «Частотное разложение vs Dodge&Burn»«Adobe Photoshop. Продвинутый уровень». Занятие 9.

Конспект к девятому занятию курса «Adobe Photoshop. Продвинутый уровень» в его гибридной версии, стартовавшей в 2019 году. Курс состоит из 5 видоезанятий и 5 онлайн занятий. Конспекты сделаны только для видеозанятий, поскольку на онлайн занятиях идет разбор пройденной темы и домашних заданий. Здесь можно посмотреть полное описание и программу курса.Перед записью на любой курс по Adobe Photoshop очень рекомендую прйти тест на знание программы. Как показывает опыт, самостоятельная оценка собственных знаний не всегда адекватно отражает их действительный уровень.

Дополнительные материалы — материалы, рекомендованные к изучению в процессе прохождения курса.

Для самостоятельного изучения — материалы, рассчитанные на самостоятельное освоение не только в процессе, но и по окончании курса.

Для стандартизации внешнего вида, обеспечения стабильности и удобства доступа, данные материалы представлены в виде документов Evernote с упрощенным форматированием. Чтобы перейти к оригиналу статьи, кликните по адресу сайта непосредственно под ее названием.

Для лучшей связи конспекта и занятия в соответствующих местах помещены миниатюры разбираемых в этот момент изображений.

Задачи на занятие

1. Освоить ручное разложение на 2 и 3 полосы пространственных частот

2. Научиться подбирать радиус разложения под конкретную задачу

3. Наработать первичные навыки пользования инструментами при ретуши низких и верхних частот

4. Разобрать автоматизацию процесса и настройки экшенов под свои собственные задачи

Дополнительные материалы:

Андрей Журавлев «Частотное разложение. Ultimate. Конспект и видео»

Евгений Карташов. «Рецепты частотного разложения»

Для самостоятельного изучения:

Liveclasses. Частотное разложение на пальцах

Liveclasses. Управление визуальным объемом и резкостью изображений

Liveclasses. Зрительное восприятие: от физиологии к образу

Алексей Шадрин. «Управление визуальным объемом фотографических изображений»

Александр Миловский. «Муар нам только снится»

Тема 9. Разложение на пространственные частоты.

9.1 Что такое пространственные частоты

- Пространственная частота — это частота с которой меняется яркость при перемещении по горизонтали или вертикали

- Чем выше частота, тем быстрее меняется яркость, соответственно тем мельче детали, которые она задает

- Низкие частоты задают общее распределение яркости и цвета на изображении, проявляя самую общую форму объектов

- Средние частоты уточняют картинку, созданную низкими частотами, привнося в нее локальные контрасты, то есть форму и объемы более мелкой детализации

- Верхние частоты добавляют самую мелкую детализацию и фактуру поверхностей

- Самые верхние частоты отвечают за микро контрасты на контрастных границах, то есть за резкость этих границ

9.2 Общие принципы частотного разложения

- Для выделения низких частот используются низкочастотные фильтры, которыми в Photoshop являются все фильтры размытия

- Чем больше значения параметра Radius (Радиус), тем более крупная детализация будет подвергаться размытию и исчезать с низкочастотного слоя, тем ниже будут оставшиеся на нем частоты

- Если для выделения низких пространственных частот используется фильтр Gaussian Blur (Размытие по Гауссу), то для выделения верхних пространственных частот можно использовать взаимно-дополнительный к нему фильтр High Pass (Краевой контраст), применив его с таким же значением параметра Radius (Радиус)

- Фильтр High Pass (Краевой контраст) выдает результат вычитания размытой картинки из исходной, то есть показывает детали, которые размыл на изображении Gaussian Blur (Размытие по Гауссу), при применении с таким же значением параметра Radius (Радиус)

- Эти детали отображаются в виде отклонения от средне-серого цвета (отклонения от средней яркости в каждом канале)

- Создание очередной частотной полосы нужно производить на базе исходного изображения, скопировав его на новый слой

- Чтобы добавить получившуюся на высокочастотном слое детализацию к расположенному ниже размытому изображению можно использовать режим наложения Linear Light (Линейный свет)

- Поскольку режим Linear Light (Линейный свет) добавляет к ниже лежащему изображению удвоенное отклонения яркости текущей картинки от средне-серого, перед наложением нужно понизить контраст высокочастотного слоя в два раза относительно средней яркости

- Это можно сделать при помощи кривых (Curves) подняв черную точку в позицию (0; 64) и опустив белую в позицию (255; 192)

- Категорически нельзя использовать для понижения контраста высокочастотного слоя уменьшение его непрозрачности до 50%, поскольку такая манипуляция не дает правильный результат!!!

- После разложения изображения на частотные полосы и сложения из них композитной картинки нужно сравнить ее с исходном. Если разницы нет, значит все было сделано правильно

9.3 Часто совершаемые ошибки

- Ошибка 1: для создания новой частотной полосы используется копия не исходного, а уже размытого изображения

- Результатом такой ошибки будет отсутствие мелких деталей на изображении

- Ошибка 2: несовпадения значения параметра Radius (Радиус) у фильтров Gaussian Blur (Размытие по Гауссу) и High Pass (Краевой контраст)

- Если значение Radius (Радиус) у Gaussian Blur (Размытие по Гауссу) было больше, чем у High Pass (Краевой контраст), произойдет выпадение некоторой полосы средних частот, и на изображении будет заметен некоторый эффект размытия, напоминающий работу софт-фильтра, при сохранении резкости мелких деталей

- Если значение Radius (Радиус) у Gaussian Blur (Размытие по Гауссу) было меньше, чем у High Pass (Краевой контраст), произойдет усиление некоторой полосы средних частот, и на изображении усилится объем мелких и средних деталей. Результат будет напоминать применение регулировки Clarity (Четкость) в конвертере

- Ошибка 3: в настройках кривых крайние точки окажутся не в позициях (0; 64) для точки черного, и (255; 192) для точки белого

- В зависимости от того, в какую сторону от правильного положения сместится кривая, результат получится немного светлее или темнее исходника

- Ошибка 4: режим наложения Linear Light (Линейный свет) задается корректирующему слою кривых, задача которого снизить контраст высокочастотной картинки

- В результате такого наложения контраст деталей на высокочастотном слое сильно увеличится, что на композитной версии будет выглядеть как сильный перешарп

- Ошибка 5: для сложения картинки был использован не режим Linear Light (Линейный свет), а какой-то другой

- В результате фактура с высокочастотного слоя проявится недостаточно активно и картинка будет выглядеть слегка размытой

- Ошибка 6: непрозрачность какого-то из слоев будет меньше 100%

- В зависимости от того, с каким слоем это произойдет, мелкая детализация либо усилится, либо ослабится

- Уменьшение непрозрачности слоя может произойти если во время работы с ним была задета цифровая клавиша на клавиатуре

9.4 Инструменты и настройки. Низкие частоты

- Ретушь полосы частот производится на копии слоя соответствующей полосы частот, что позволяет, с одной стороны, сохранить неизменным исходное изображение соответствующей частотной полосы, а с другой стороны, в процессе ретуши не обращаться к информации за пределами слоя, на котором производится ретушь

- Ретушь на слое низких частот как правило делается полупрозрачными инструментами с максимально мягкими кистями, поскольку это позволяет более мягко и плавно сопрягать полутоновые переходы

- Работа инструментом «Штамп» (Clone Stamp Tool) с полупрозрачной мягкой кистью позволяет плавно наносить на ретушируемые участки новый цвет, не теряя при этом контраста фактуры

- Работа инструментом «Кисть» (Brush Tool) с полупрозрачной мягкой кистью позволяет закрашивать сильно выбивающиеся по яркости и цвету участки в цвет в цвет окрестных областей

- При работе инструментом «Кисть» (Brush Tool) нужно стараться не наносить много мазков одним и тем же цветом на одно место, поскольку это приводит к появлению однородно окрашенных плоских пятен

- Чтобы минимизировать подобный эффект можно регулярно забирать цвет для рисования с близлежащих участков, кликая по ним с зажатой клавишей «Alt»

- Для разглаживая полутоновых переходов можно использовать инструмент «Микс-кисть» (Mixer Brush Tool), который является более продвинутой версией инструмента «Палец» (Smudge Tool), и занимается «растиранием» уже имеющейся на изображении краски

- В поле Current brush load (Текущая заполненность кисти) в палитре Options (Параметры) нужно отдать команду Clean Brush (Очистить кисть) и убедиться, что в данном поле отображается клетчатая пиктограмма, обозначающая непрозрачность

- В противном случае инструмент будет не просто растирать уже присутствующие на изображении краски, но и добавлять имеющийся на нем цвет

- Кнопка Load the brush after each stroke (Заполнять кисть после каждого мазка) должна быть деактивирована, чтобы кисть не запоминала краску, забранную на предыдущем мазке

- Кнопка Clean the brush after each stroke (Чистить кисть после каждого штриха) должна быть активирована, чтобы кисть очищалась от краски, которую могла забрать на предыдущем мазке

- Настройки параметров Wet (Влажн.), Load (Заполн.), Mix (Смеш.) нужно установить на 25%-30%, поскольку именно при таких настройках микс-кисть наиболее аккуратно имитирует растирающую краски на изображении

- С помощью настройки параметра Flow (Наж.) меняем скорость, с которой инструмент вносит изменения в изображение

- Ключ Sample All Layers (Все сл.) должен быть дезактивирован, чтобы при вкрученном отображении верхних частот не происходил их перенос на слой ретуши нижних частот

- Для выравнивания неоднородностей при сохранении полутонового перехода движения микс-кистью производятся вдоль линий сохранения яркости (вдоль границы перехода)

- Для выравнивания неоднородностей с одновременным удалением (разглаживанием) полутонового перехода движения микс-кистью производятся поперек линий сохранения яркости (поперек границы перехода)

9.5 Инструменты и настройки. Высокие частоты

- Ретушь полосы частот производится на копии слоя соответствующей полосы частот, что позволяет, с одной стороны, сохранить неизменным исходное изображение соответствующей частотной полосы, а с другой стороны, в процессе ретуши не обращаться к информации за пределами слоя, на котором производится ретушь

- Это особенно важно при ретуши верхних частот, если при этом хочется видеть на экране ужо собранное финальное изображение

- Ретушь верхних частот производится штампом с максимальной жесткой кистью и стопроцентной непрозрачностью, это позволяет предотвратить замаливание фактур на полупрозрачных участках заплатки

- Основной особенностью при такой работе является настройка штампа Sample: Curent Layer (Образец: Активный слой)

- Если оставить штампу привычную настройку Sample: Curent & Below (Образец: Активный и ниже), при ретуши с визуализацией всех пространственных частот (на экране готовое изображение) на высокочастотный слой будет переноситься композитное изображение, что приведет к неадекватно виду картинки

- Визуально это будет проявляться в виде появления на коже пятен «позолоты» или «йода»

- Особое внимание нужно уделить ретуши участков в окрестностях контрастных границ, поскольку при применении для разложения фильтров Gaussian Blur (Размытие по Гауссу) и High Pass (Краевой контраст) на высокочастотном слое в этой зоне появляются ореолы, а их удаление приводит к затягиванию на участок цвета с противоположной стороны границы

- Использование других инструментов кроме штампа при ретуши верхних частот нецелесообразно

9.6 Подбор радиуса

- Радиус при разложении выбирается исходя из желания ретушера «выдавить» дефекты на верхнюю или нижнюю полосу частот

- Данное желание зависит не только от навыков работы конкретного ретушера с теми или иными инструментами, но и от его личных пристрастий и привычек

- Если ретушеру удобнее исправлять дефекты на верхних частотах, радиус подбирается настолько большим, чтобы все неровности ушли с низких частот

- В таком случае удобнее делать визуализацию по низкой частоте, то есть начинать с применения фильтра Gaussian Blur (Размытие по Гауссу), плавно увеличивая радиус до такого минимального значения, при котором дефекты перестанут отображаться на низких частотах

- Если ретушеру удобнее исправлять дефекты на нижних частотах, радиус подбирается настолько маленьким, чтобы все неровности остались на низких частотах

- В таком случае удобнее делать визуализацию по верхней частоте, то есть начинать с применения фильтра High Pass (Краевой контраст), задав изначально достаточно большой радиус и плавно уменьшая его до такого максимального значения, при котором дефекты перестанут отображаться на верхних частотах

- Для ретуши портретов можно указать приблизительные соотношения размеров лица и значения параметра Radius (Радиус), при которых с низких частот удаляются детали определенного типоразмера

- При вычислении радиусов удобнее отталкиваться от высоты лица, так как она меньше зависит от ракурса съемки

- Для удаления аккуратной фактуры кожи необходимо взять значение Radius (Радиус) порядка 1/280 — 1/250 от высоты лица

- Для удаления мелких дефектов (прыщи, морщины и т.п.) необходимо взять значение Radius (Радиус) порядка 1/100 — 1/120 от высоты лица

- Для удаления крупных дефектов (подглазины, шрамы и т.п.) необходимо взять значение Radius (Радиус) порядка 1/50 — 1/60 от высоты лица

9.7 Ретушь верхних частот

- Разложение начинается с применения фильтра Gaussian Blur (Размытие по Гауссу), у которого плавно увеличивается радиус до такого минимального значения, при котором дефекты перестанут отображаться на низких частотах

- Высокочастотный слой формируется при помощи фильтра High Pass (Краевой контраст), который применяется со значением Radius (Радиус), аналогичным использованному на предыдущем шаге в фильтре Gaussian Blur (Размытие по Гауссу)

- Ретушь производится на копии высокочастотного слоя, либо помещенного с ним в одну группу, либо привязанного к оригиналу с помощью команды Create Clipping Mask (Создать обтравочную маску)

- Для ретуши используется штамп с максимальной жесткой непрозрачной кистью и настройкой Sample: Curent Layer (Образец: Активный слой)

- Таким образом с изображения легко удаляются мелкие дефекты: родинки, прыщики, морщинки, мелкие шрамы, сосуды и капилляры (как на склере глаза, так и просвечивающие через кожу), выбившиеся из прически волоски, щетина и пушок на лице, края контрастных границ, и т.п.

- Для лучшего контроля над деталями можно временно отключить корректирующий слой кривых, понижающий контраст высокочастотного слоя (или включить слой кривых, повышающий контраст высокочастотного слоя при честном разложении)

9.8 Ретушь низких частот

- Разложение начинается с применения фильтра High Pass (Краевой контраст), у которого задается изначально достаточно большой радиус и плавно уменьшается до такого максимального значения, при котором дефекты перестанют отображаться на верхних частотах

- Низкочастотный слой формируется при помощи фильтра Gaussian Blur (Размытие по Гауссу), который применяется со значением Radius (Радиус), аналогичным использованному на предыдущем шаге в фильтре High Pass (Краевой контраст)

- Ретушь производится на копии высокочастотного слоя, для удобства и единообразия помещенного с ним в одну группу, либо привязанного к оригиналу с помощью команды Create Clipping Mask (Создать обтравочную маску), хотя это и не обязательно

- Для ретуши на первом этапе может использоваться инструмент «Кисть» (Brush Tool), а в последующем инструменты «Штамп» (Clone Stamp Tool) и «Микс-кисть» (Mixer Brush Tool)

- Все инструменты применяются с максимально мягкими полупрозрачными кистями

- Таким образом с изображения можно легко удалить как пятна, созданные светл-теневым рисунком, то есть неровности на различных материалах (кожа, ткань, обивки мягких поверхностей, твердые поверхности и т.п.), так и пятна созданные различной окраской разных участков объекта (пигментные пятна и покраснения на коже, неоднородности окраски древесины, пятна жира и краски на любой поверхности и т.п.)

9.9 Ретушь двух полос частот

- Существуют дефекты, которые невозможно выдавить на отдельную полосу частот, поэтому их приходится ретушировать как на низких, на и на высоких частотах

- Чаще всего такими дефектами являются слишком жесткие акцентированные тени или объекты со слишком резкими и четкими краями

- Преимущество такого подхода, по сравнению с ретушью композитного изображения, состоит в том, что работа с формой и цветом производится на низкочастотной составляющей, без оглядки на фактуру поверхности и резкие края, а ретушь жестких границ делается на высокочастотной составляющей, без привязки к цвету конкретного участка изображения

9.10 Ретушь «металлических» бликов на коже

- Слишком яркие блики на коже, часто называемые «металлическими», яркий пример дефекта, который нужно ретушировать на двух полосах частот

- Разложение производится с таким радиусом, чтобы вся фактура кожи и мелкие детали «ушли» на верхние частоты

- Ретушь нижних частот начинается с закрашивания особенно ярких участков бликов с помощью инструмента «Кисть» (Brush Tool) (подробности настроек и применения смотри в разделе 9.4)

- Если ретушеру это более удобно, работу инструментом «Кисть» (Brush Tool) можно заменить на «Штамп» (Clone Stamp Tool)

- После выравнивания цвета на участках бликов производится их разглаживание с помощью инструмента «Микс-кисть» (Mixer Brush Tool)

- Сначала движения этим инструментом делаются только в центр блика, таким образом цвет с окрестных участков «натягивается» на ликующую область, еще больше выравнивая ее по сравнению с соседними участками

- После этого растирка делается через область блика в обе стороны, чтобы максимально сгладить и смягчить полутоновые переходы на данном участке

- После ретуши низких частот не забудьте про верхние!

- Если блик пробойный и вообще не содержал фактуры, она переносится с целых участков кожи

- Если фактура на бликах изначально была, она будет более контрастной, чем на остальных участках изображения, поэтому ее контраст нужно понизить

- Чтобы фактура не выглядела «замыленной», при понижении ее контраста нужно замещать ее другой фактурой

- Выделяем на изображении подходящий по размеру участок высокочастотного слоя с подходящей фактурой и копируем его на отдельный слой

- Переносим эту заплатку на место блика и уменьшаем ее непрозрачность, таким образом смягчая изначально слишком контрастную фактуру, и частично сохраняя ее для обеспечения более естественного вида изображения

9.11 Ретушь и продление однородных фонов

- После ретуши на достаточно однородных участках с низко контрастной фактурой часто остаются достаточно крупные низко контрастные пятна

- Для удаления этих пятен проще всего разложить изображение на пространственные частоты, выдавив всю фактуру на высоко частотный слой, а после этого отретушировать низко частотный слой полупрозрачной мягкой кистью или аналогичным штампом

- При необходимости продлить достаточно однородный фон поступаем аналогично: раскладываем изображения, выдавив всю фактуру на высоко частотный слой, на низких частотах продолжаем фон при помощи градиентной или обычной заливки, дорабатывая его большой мягкой полупрозрачной кистью, а на верхних частотах просто планируем имеющуюся на фоне фактуру

Тема 10. Сложные варианты разложения и автоматизация.

10.1 Разложение без применения фильтра High Pass (Краевой контраст)

- Вычисление верхних частот можно проводить без применения фильтра High Pass (Краевой контраст), и тому есть три причины

- Во-первых, фильтр High Pass (Краевой контраст) дает ошибку

- Во-вторых, применение этого фильтра невозможно, если для размытия используется не Gaussian Blur (Размытие по Гауссу), а другой фильтр размытия

- В-третьих, когда при написании экшена нужно избавить пользователя от необходимости запоминать радиус и вводить его второй раз

- Про «ошибку High Pass»: при вычитании размытой версии из исходной максимальный диапазон составляет от -256 (вычитаем белый из черного) до 256 (вычитаем черный из белого), то есть 512 значений

- В то же время, максимально возможные отклонения от средней яркости на высокочастотном слое составляют от -128 (затемнение) до 127 (осветление)

- При наличии мелких деталей на массивном фоне отличающихся по яркости более чем на 128 уровней High Pass (Краевой контраст) ошибается, обычно это случается на точечных бликах расположенных на темном объекте

- Чем больше радиус размытия, тем больше сама ошибка и вероятность ее появления, хотя на практике, при малых радиусах разница является «гомеопатической» и рассматривать ее как реальную проблему можно только с академической точки зрения

- При больших радиусах данная ошибка составляет реальную проблему, поскольку «гасит» мелкие блики

- Альтернативой High Pass (Краевой контраст) является создание высокочастотного слоя путем наложения на копию исходного изображения его размытой версии при помощи команды Apply Image (Внешний канал) в режиме Subtract (Вычитание) с установками Scale: (Масштаб:) 2 Offset: (Сдвиг:) 128

- В поле Scale: (Масштаб:) устанавливается во сколько раз будет уменьшаться результат вычитания наложенной яркости из исходной, а в поле Offset: (Сдвиг:) задается какое значение нужно добавить к получившемуся результату

- При помощи таких настроек диапазон значений после вычитания (-256: 256) приводится к имеющемуся у нас в распоряжении диапазону яркостей (0; 256)

- Применять корректирующий слой кривых понижающий контраст к высокочастотному слою в данном случае не нужно, поскольку он уже понижен установкой Scale: (Масштаб:) 2

10.2 Настройки для 16-битных изображений

- При вычислении высокочастотной составляющей при помощи режима наложения Subtract (Вычитание) у 16-битных изображений появляется ошибка величиной в 1 восьмибитный (128 шестнадцатибитных) уровень

- Чтобы избежать этой ошибки при работе в 16-битном режиме вместо режима наложения Subtract (Вычитание) используют режим Add (Добавление) с активированным ключом Invert (Инвертировать) и установками Scale: (Масштаб:) 2 Offset: (Сдвиг:) 0

10.3 Применение альтернативных фильтров размытия

- «Честное» вычисление высокочастотной составляющей позволяет перейти от применения фильтра Gaussian Blur (Размытие по Гауссу) к любым другим фильтрам размытия

- В случае применения для получения низкочастотной составляющей фильтра Gaussian Blur (Размытие по Гауссу) вдоль контрастных границ создаются сильные ореолы, ретушь в этой области может привести к «затягиванию» на объект цвета соседнего фона

- Данная проблема проявляется тем более сильно, чем больше радиус размытия, поскольку в этом случае ореолы становятся более массивными и плотными

- Чтобы избежать такой проблемы низкочастотную составляющую можно создавать при помощи фильтра Surface Blur (Размытие по поверхности)

- При использовании Surface Blur (Размытие по поверхности) границы, имеющие перепад яркости больше уровня установленного регулятором Threshold (Изогелия), практически не размываются

- На практике удобнее всего подобрать значение Radius (Радиус) при установленном на максимум параметре Threshold (Изогелия), а потом уменьшать значение Threshold (Изогелия) до восстановления резкости контрастных границ

- Такой прием упрощает ретушь высокочастотной составляющей в окрестностях контрастных границ, а при переделке фонов облегчает и доработку низкочастотной составляющей в этой же зоне

- Как более простая и быстрая альтернатива фильтру Surface Blur (Размытие по поверхности) может использоваться фильтр Median (Медиана), впрочем, в некоторых случаях, этот фильтр может оказаться даже более полезен, чем Surface Blur (Размытие по поверхности)

10.4 Разложение на 3 полосы частот

- Основная идея разложения на три полосы частот состоит в том, чтобы выдавить все дефекты на слой средних частот

- Таким образом можно бороться с объектами определенного типоразмера, например веснушками

- Кроме того, в средних частотах находится большинство «старящих» элементов: глубина морщин, жилистость, вены, провисания, мешки под глазами и т.п.

- Реже ретушируют все три полосы, в этом случае процесс аналогичен разделению на 2 полосы, но позволяет проще работать объектами разного типоразмера

- В целом такое разложение напоминает разложение на два полосы частот, только значения параметра Radius (Радиус) на начальном этапе выбираются не одинаковыми

- Сначала для низкочастотной составляющей, для фильтра Gaussian Blur (Размытие по Гауссу), подбираем такой значение Radius (Радиус), чтобы с нее исчезли все ненужные неровности

- Потом формируем высокочастотную составляющую, подобрав такое значение фильтра High Pass (Краевой контраст), чтобы на ней не проявлялись ненужные неровности

- В конце формируем вреднечатотную составляющую, начав работу с копии исходного изображения, и применив к ней фильтр High Pass (Краевой контраст) с такими же настройками, как у Gaussian Blur (Размытие по Гауссу), примененному к слою низких частот, и Gaussian Blur (Размытие по Гауссу) с такими же настройками, как у High Pass (Краевой контраст), примененному к слою верхних частот

- Для сложения картинки понижаем в два раза контраст средних и верхних частот вокруг средне-серого и накладываем их в режиме Linear Light (Линейный свет) на лежащее ниже изображение

- Ретушь средних частот производится аналогично описанной ранее ретуши нижних частот

- Преимущество данного метода в том, что даже при очень размашистых и неаккуратных движениях, аккуратная форма объекта сохранится, поскольку она находится на низких частотах, которые мы не затрагиваем

10.5 Упрощенная ретушь средних частот

- Ретушируя средние частоты, мы прежде всего убираем лежащие в них излишние локальные объемы, это можно сделать проще, не раскладывая изображение на три полосычастот, а выделив только среднечастотную составляющую, вычесть ее из исходного изображения

- Вычитание должно быть локальным: только на участках где присутствует лишний объем, пропорционально степени его подавления

- Подбор значения Radius (Радиус) для выделения средних частот аналогичен предыдущему примеру, поэтому фильтры придется использовать «шиворот-навыворот», то есть подбирать радиус для High Pass (Краевой контраст) удобнее через Gaussian Blur (Размытие по Гауссу) и наоборот

- Делаем копию исходного слоя, вызываем Gaussian Blur (Размытие по Гауссу), плавно увеличиваем радиус пока не исчезнут ненужные детали, запоминаем его значение и нажимаем Cansel (Отмена)

- Вызываем High Pass (Краевой контраст), задаем заведомо большой радиус и плавно уменьшаем его, пока не пропадут ненужные объемы, запоминаем его значение и вводим радиус, подобранный на предыдущем шаге, применяем Gaussian Blur (Размытие по Гауссу) с радиусом подобранным на предыдущем шаге

- Желательно, чтобы значения Radius (Радиус) отличались не больше, чем в три раза, иначе будет удаляться слишком широкая полоса частот, что приведет к неестественно равномерной форме

- Инвертируем изображение командой Image > Adjustments > Invert (Изображение > Коррекция > Инверсия)

- В два раза понижаем контраст вокруг средней точки с помощью прямой коррекции: Image > Adjustments > Curves (Изображение > Коррекция > Кривые)

- Меняем режим наложения получившегося слоя на Linear Light (Линейный свет)

- На слой, вычитающий средние частоты из исходного изображения, добавляем черную маску

- Белой кистью по маске прорисовываем те участки, на которых нужно подавить крупные детали

- Данный прием нужно с аккуратностью применять к коже, поскольку он дает слишком правильную, механистически-чистую форму, что смотрится не естественно

- Однако, такой прием идеально подходит для разглаживая одежды, драпировок, и всего, что мы воспринимаем как «не кожу»

10.6 Устройство и работа экшенов

- Для ускорения и оптимизации процесса работы все рутинные операции можно записать в экшена, оставив на долю человека только подбор радиуса

- Преимущество экшенов перед панельками и плагинами состоит в том, что пользователь может самостоятельно их модифицировать, настроив под свои задачи

- Процесс написания и модернизации экшенов не входит в рамки данного курса, поэтому на все возникшие вопросы преподаватель может факультативно ответить на онлайн занятии

- Экшен «2_FB_Low» — разложение на две полосы частот с визуализацией по нижней полосе, для ретуши используются слои помеченные красным цветом, для усиления деталей можно включить видимость корректирующего слоя кривых

- Экшен «2_FB_High» — разложение на две полосы частот с визуализацией по верхней полосе, для ретуши используются слои помеченные красным цветом, для усиления деталей можно включить видимость корректирующего слоя кривых

- Экшен «3_FB» — разложение на три полосы частот, визуализация разделения между низкими и средними частотами делается по низкой частоте (первый подбор радиуса), визуализация разделения между средними и верхними частотами делается по верхней частоте (второй подбор радиуса), для ретуши используются слои помеченные красным цветом

- Экшен «Inverted_HighPass» — упрощенный метод ретуши (подавления) средних частот, визуализация разделения между низкими и средними частотами делается по низкой частоте (первый подбор радиуса), визуализация разделения между средними и верхними частотами делается по верхней частоте (второй подбор радиуса), для ретуши нужно рисовать белым цветом на маске слоя «Inverted_HighPass»

© Андрей Журавлев (aka zhur74), 2012 г.

Редакция третья (2020 г.) переработанная и дополненная.

Первая публикаци https://zhur74.livejournal.com/101357.html

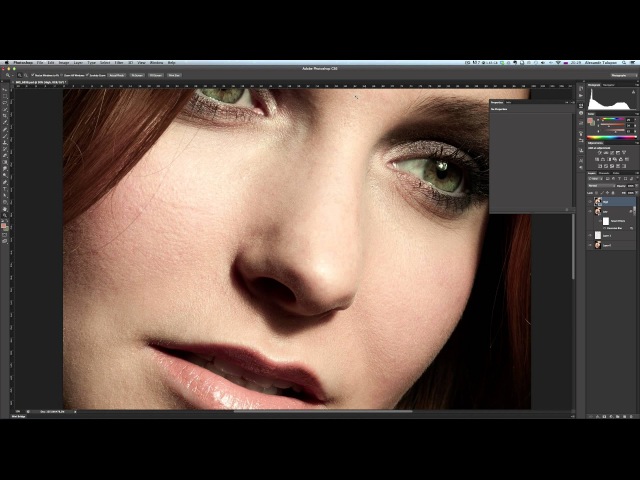

Советы и хитрости: техника частотного разложения | Фотограф — Александр Золотухин

Если вы читали мою предыдущую статью — Профессиональная портретная ретушь: техника частотного разложения, то вы уже знаете что такое частотное разложение и как им пользоваться. Если нет, пожалуйста сначала прочитайте ту статью.

Тут я хочу рассказать вам некоторые советы и хитрости по использованию техники частотного разложения, которые помогут вам работать эффективнее и получать лучшее качество. В конце статьи вы можете скачать бесплатные экшены, чтобы применять эту технику быстро и автоматически (нужно подписаться на блог, чтобы получить ссылку на загрузку).

Что же, давайте начнем.

1. Всегда используйте метод Apply Image.

Если ваша цель — получить качественный результат, никогда не используйте метод High Pass для разложения на частоты. В предыдущей статье я уже упоминал, что High Pass не корректен математически, в отличие от Apply Image. Вот простой тест, чтобы увидеть погрешность. Я разделил изображение методом High Pass, сгрупировал получившиеся слои и изменил режим наложения группы на Difference. И вот что я получил:

Отчетливо видны не черные пиксели и линии — это и есть разница между оригинальным изображением и разложенным на частоты, или говоря математическим языком, погрешность. Я немного повысил контрастность, чтобы разница была видна отчетливее, потому что на уменьшенном изображении на сайте она не так заметна. Можете повторить это сами дома, это не опасно 🙂

Если не хотите потерять в качестве еще до того, как начнете собственно редактирование, используйте Apply Image.

2. Используйте 16-битную глбину цвета, если это возможно.

Это касается редактирования изображений всегда. Чем выше глубина цвета изображения — тем лучше. 16-битные изображения в значительно меньшей степени страдают постеризацией. Подробнее этот аспект описывается в статье Глубина цвета. 8 бит или 16 бит.

Но что касается именно техники частотного разложения — этот тот факт, что 8-битные изображения, в отличие от 16-битных, не имеют настоящего 50% серого! На слое высоких частот 50% серый означает не оказывать никакого влияния на низлежащий слой при наложении в режиме Linear Light. Потому возможностьиметь реальные 50% серые пиксели будет очень к стати.

Давайте начнем с простой математики. Представьсте себе что у нас нечетное количество цветов, скажем 5, где 1 — белый, 5 — черный. ТОгда 2 будет светло-серым, 3 — 50% серым и 4 — темно-серым.

Но что будет если у нас нечетное количество цветов? Давайте рассмотрим случай с 6 цветами. На значениях 3 и 4 мы получаем 40% и 60% серый. Наш средний-серый будет где-то на 3,5, но цвета могут быть представлены только целыми числами. Это означает что при четном количестве цветов 50% серый не существует.

Теперь вернемся к 8 и 16-битным цветам.

8-битные цвета представлены значениями от 0 до 255, это дает нам 256 цветов. 256 — это четное число, так что истинного среднего серого цвета в 8-битном режиме не будет. Значение 127,5 будет округлено до 128.

16-битный цвет в Фотошопе на амом деле 15-битный + 1 цвет. 215 = 32768. Добавляем еще 1 цвет и получаем 32769 — нечетное число, в котором 50% серый вполне возможен.

3. Не трогайте оригинальные слои.

Как я уже упоминал в предыдущей статье, всегда используйте отдельные слои любой коррекции, чтобы иметь возможность в любой момент вернуться к любому этапу ретуши. Когда выолняете низкочастотную ретушь, используйте отдельные слои для мешков под глазами, морщинок, мимических складок и прочего. можно использовать любые типы слоев над слоем Low Frequency в режиме наложения Normal. Таким образом вы сможете быстро снизить эффект отдельных коррекций снизив непрозрачность соответствующих слоев. Это дает намного больше гибкости и ускоряет работу. Можно конечно держать все эти изменения на одном слое и при необходимости пользоваться маской слоя, но это не так удобно и не так быстро, как если у вас будут отдельные слои.

4. Раскладываем изображение на 3 и более разных частоты.

Это процедура чуть более сложная (потому в конце статьи прилагается набор бесплатных экшенов для автоматизации) и на мой взгляд довольно бесполезная, но может быть она кому-то пригодится. Покажу на примере разложения на 3 частоты:

- Создайте 3 копии слоя Background: Low Frequency, Med Frequency, High Frequency.

- Примените фильтр Gaussian Blur с большим радиусом. к слою Low Frequency.

- Выбираем слой Med Frequency и запускаем Image -> Apply Image. В графе Layer выбираем слой Low Frequency. Остальные настройки в зависимости от битности изображения.

- Меняем режим наложения слоя Med Frequency на Linear Light.

- Размываем слой Med Frequency с таким радиусом, чтобы пропали только самы мелкие детали, которые уйдут на слой High Frequency (можно воспользоваться фильтром High Pass чтобы точнее прикинуть радиус).

- Выделите слои Med Frequency и Low Frequency, нажмите Cmd+Option+Shift+E / Ctrl+Alt+Shift+E чтобы объединть эти слои на новом слое. Назовите его Help.

- Выбираем слой High Frequency и запускаем Image -> Apply Image. В графе Layer выбираем слой Help. Остальные настройки в зависимости от битности изображения.

- Меняем режим наложения слоя High Frequency на Linear Light.

- Удаляем слой Help.

По такому же алгоритму можно разложить изображение и на большее число частот.

5. Повышение резкости и микроконтраста с помощью частотного разложения.

Техника частотного разложения открывает кучу возможностей не только для ретуши, но и многих других типов обработки. Повышение микроконтраста может значительно улучшить вид пейзажа и даже портрета. Оно делает изображение более резким, четким, выделяет все мельчайшие детали изображения. Оно делает фотографии очень похожими на HDR фотографии с тонмаппингом.

Запомните: делайте это только после того, как закончите ретушь, в противном случае вы сделаете все не исправленные дефекты еще более заметными.

Шарпинг (повышение резкости)

- Выделите все высокочастотные слои (оригинальный и корретирующий). Нажмите Cmd+Option+E / Ctrl+Alt+E чтобы объединить их на новом слое.